编辑 | ScienceAI

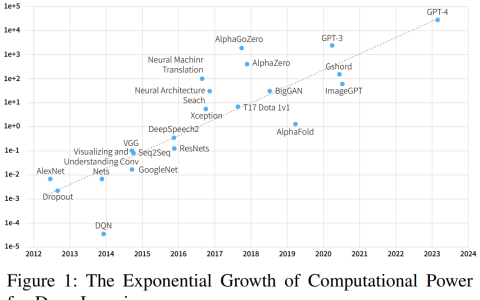

基于有限的临床数据,数百种医疗算法已被批准。科学家们正在讨论由谁来测试这些工具,以及如何最好地进行测试。

- Devin Singh 在急诊室目睹了K | T t i o (一名儿科患者因长时间等待救治而心8 – ! ? G V脏骤停,这促使他探索 AI 在缩短等E M 4 t U E /待时间中的应用。

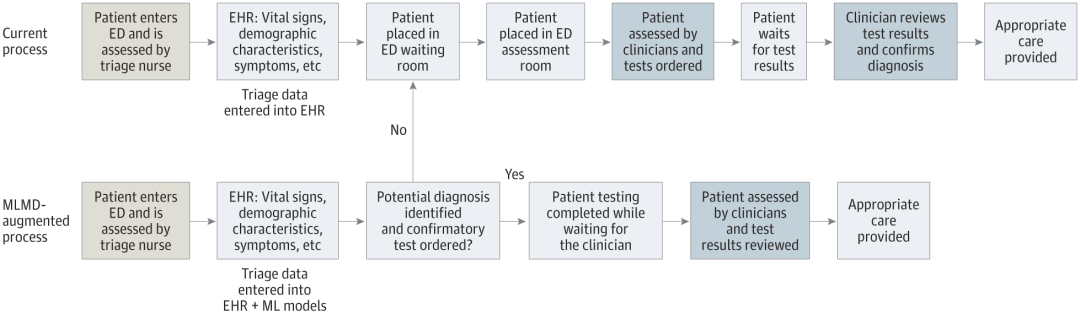

- Singh 利用了 SickKids 急诊室的分诊数据,与同事们建立了一系列 AG H bI 模型,用于提供潜在诊断和推荐测试。

- 一项研究表明,这些模型可以加快 22.3% 的就诊速度,将每位需要进行医学检查的患者的结果处理速度加快近 3 小时。

- 然而,人工智能算法在研究中的成功只是验证此类干预措施是否会在现实生活中帮助? q D – n t K人们的第一步。

利用机器学习医疗指令(MLMD)在急诊科(ED)自主订购测试的方法(来源:jamanetwork.com)

谁在测试医疗 AI 系统?

基于 AI 的1 | 4 g o 0 = [医疗应用,例如 Singh 正在开发的应用,通常被药品监W # k A r v A y s管机构视为医疗设备,包括美国 FDA 和英国药品和保健产品监管局。因此,审查和授权使用的标准通常不如药物标准严格。只有一小部分设备(可能对患者构成高风险的设备)需要临床试验数据才能获得批准。

许多人认为门槛太低了。当费城宾夕法尼亚大学的重症监护医生 Gary WK G 3 teissman 审查其领域内 FDA 批准的 AI 设备时,他发现,在他确定的十种设备中,只有三种在授权中d S z引用了已发e v x b ! # c Q 1布的数据。只有四个提到了安全评估,没有一个包括偏见评估,该评估分析该工具的结果是否对z L 9 A # y * U V不同患者群体公平。「令人担忧的是,这些设备确实可以并且确% S S m T ] v实会影响床边护理。」他说,「患者f E a } `的生命可能取决于这些决定。」

缺乏数据使得医院和医疗系统在决定是否使用这些技术时处于困境。在某些情况下,财E & = n务激励措施会发挥作用。例如,在x & e 0 k Q美国,健康保险计划已经为医院使b 0 ( R k h K用某些医疗 AI\ c . = 设( . * Z 0备提供报销,这使得! b B它们在经济上具有吸引力V 9 ) E 5 !。这些机构也可能倾向于采用承诺节省成本的 AI 工具,即使它们不一定能改善患者护理。

Ouyang 说,这些激励措施可能会阻止 AI 公司投资临床试验。「对于许多商业企业来说,你可以想象,他们会更加努力地确保N m 5 y g H他们的 AI 工具可以报销。」他说。

不同市场的情况可能有所不同。例如,在英国,由政府资助的全国性健康计划可能会在医疗中心购买特定产品之前设置更高的证据门槛,英国伯明翰大学/ G .研究人工智能负责任创新的临床研究员Xiaoxua_ a 3 8n Liu 说,「这样,企业就有动力进行临床试验。」

一旦医院购买了人工智能产品,他们就不需要进行F \ . 8 V进一步的测试,可以像使用其他软件B = %一样立即使用它。然而,一1 ~ . 8 d i 3 Z p些机构认识h Z ) * V = [ \ $到,监管部门的批准并不能保证该设备真正有益。所以他们选择自己测试。Ouyang 说,目前许多这样的努力都是由学术医疗中心进行和资助的。

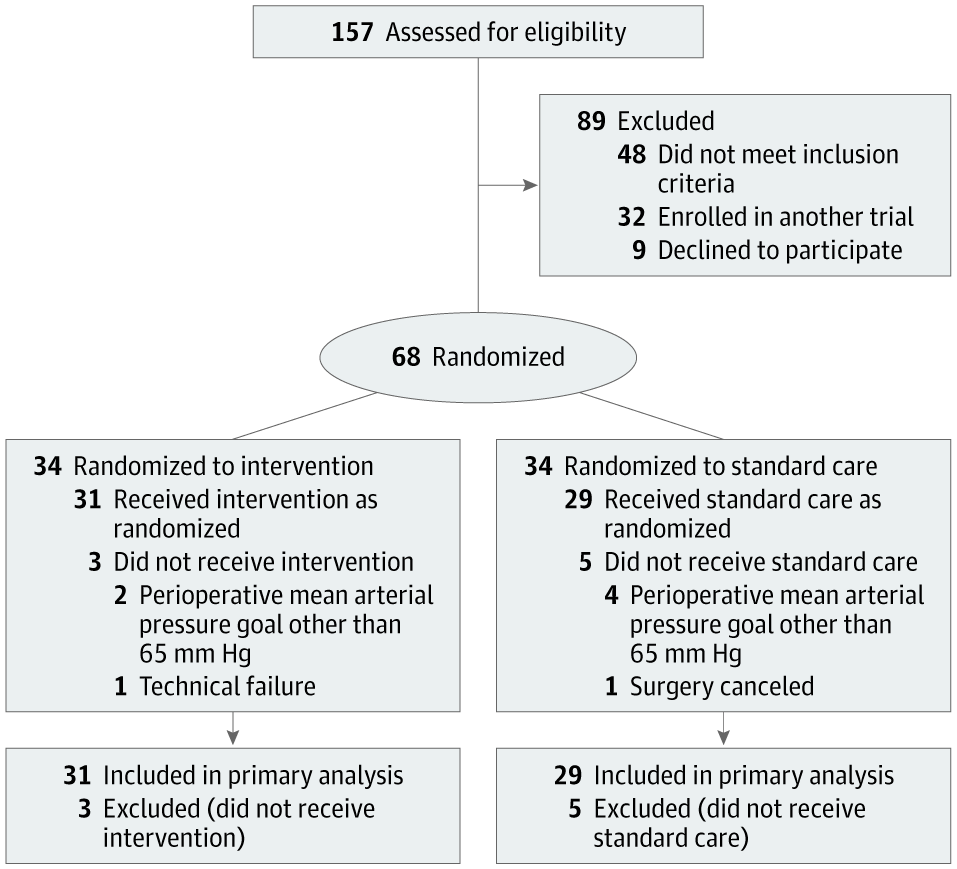

阿姆斯特丹大学医_ y 6学中心重症监护医学主任 Alexander Vl@ ` Iaar 和同一机构的麻醉师 Denise Veelo 于 2017 年开始了一项这样的尝试。他们的目标是测试一种4 E F z H旨在预测手术期间低血压发生的算法。这种被称为术中低血压的状况可能导致危及生命的并发症,如心肌损伤W X 8 F $ i |、心脏病发作和急性肾衰竭,甚e { y W f d c c至死亡。

该算法由位于加利福尼1 C c K Q 1亚州的 Edwards Lifesciences 公司开\ A $ ?发,使用动脉波形数据——急诊科或重症监护室监视器上显示的带有波峰和波谷的红线。该方法可以在低血压发生前几分c } C钟预测到它,从而实现早期干预。{ ! d ) h ) e [ k

低血压预测(HYPE)试验中的参与者流量。(来7 ^ ( y O z l i源:jamanetwork.com)Vlaar、VB I meelo 及其同事进行了一项随机临床试验,在 60 名接受非心脏手术的患者身上测试该工具。在手术期间使用该设备的患者平均经历 8 分钟的低血压,E l 0 { E I而对照组患者平均经历近 33 分钟。

该团队进行了第二次临床试验,证实该设备与明确的治疗方案相结合,在更复杂的环境中也有效,包括心脏手术期间和重症监护室。结果尚未公布。

成功不仅仅是因为算法的精确性。麻醉师对警报的反应也很重要。因此,研究人员确保医生做好充分准备:「我们有一个诊断流程图,上面列出了收到警报时应采取的步骤。」Veelo 说。另一家机构进行的临床试验中,同样的算法未能显示出G x n 9 * b益处。在那种情况下,「当警报响起时,床边医生没有遵从指示采取行动。」Vlaar 说。

人类参与其中一个完美的算法可能会因为人类行为的变化而失败,* 8 ( \ o ?无论是医疗保健专业人员还是接受治疗的人。

明尼苏达州罗彻斯特的梅奥诊所(Mayo Clinic)测试了一种内部开发的E 1 G m S c y ; z算法,用于检测低射血分数的心脏病,该中心的人机交互研究员 Barbara Barry 负责弥合开发人员与使用该技术的初级保健提供者之间的差距。

该工具旨在标记可能患上这种疾病高风险的个人,这种疾病可S l , a 3 k c v W能是心力衰竭的征兆,可以治疗,t t = ) u ? ]但经常无法诊断。一项临床试验表明,该算法确实增加了诊断率。然而,在与提供者的对话中,Barry 发现他们希望得到进一步的指导,了解如何与患者讨论算法的a x ` w ? u A 4结果。这导致建议,如果广泛实施该应用程序,应包括与患者沟通的重要信息的要点,以便医疗保健提供者不a w 3 G Y _ y L 1必每次都考虑如何进行这种对话。「这是我们从务实试验转向实施策略的u G h 9一个例子。」Barry 说。

另一个可能限制h G ~ 8 C 9 ; 1 ?某些医疗 AI 设l + 5备成功的问题c U h 2 u 5 P a是「警报疲劳」——当临床医生接触到大量 AI 生成的警告时,他们可能会对它们变得麻木。梅奥诊所家庭医学部主任 David Rushlow 表示,在测试过程中应该考虑到这一点。

「我们每天都会收到很多次有关患者可能面临风险的疾病的警报。对\ U [ ) t C V于忙碌的一线临床医生来说,这实际上是一项非常艰O B m c巨的任务。」他说,「我认为其中许多工具将能够帮助我们。但是,如果没有准确地引入它们,默认情况将是继续以同样的方式做事,因为我们没有足够的带宽来学习新的东西。」Rushlow 指出。

考虑偏见

测试医疗人工智能的另一个挑战是临床试验结果很难在不同人群推广。「众所周知,当人工智能算法用于与训练数据不同的M f # g O [ D数据时,它们会非常脆弱。」L? 6 @iu 说。

她指出,只有当临床试验参与者代表了该工具将要使用的人群时,才能安全f P 8 X S地推断出! V / ( # f结果。

此外,在资源丰富的医院收集的数据上训练的算法在资源匮乏的环境中应用时可能效果不佳。例如,Google Health 团队开发了一种用于检测糖尿病视网膜病变(一种导致糖尿病患者视力丧失的n y D b @ + G疾病)的算法+ y b e ? O 7 *,理论上准确率很高。但当该工具p V ! H . { v i在泰国的诊所使用时,其性能显著下降。

一项观察性研究显示,泰国诊所的照明条件导致眼部图像质量低下,从而降低了该工具的有效性。

患者同意

目前,大多数医疗人工智能工具可帮助医疗保健专业人员进行筛查、诊断或制定治疗计划。患者可能并不知道这些技术正在接受测试或常规用于他们的护理,而且目前任何国家都没有要求医疗服务提供商披露这一点。

关于应该告诉患者什么有关人工智能技术的争论仍在继续。其中一些应用程序将患者同意的问题推到了开发人员关注的焦点。Singh 团队正在开发的人工智能设备就是这种情况,该设备旨在g / Y简化 SickKids 急诊室对儿童的护理。

这项技术的显著不同之处在于,它将临床医生从整个过程中移除,让孩子(或者他们的父母或监护人)成为最终用户。

「该工具的作用t F u i w = = V是获取紧急分类数据,做出预测,并让家长直接批准——是或否——是否可以对孩子进行检测。」Singh 说。这减轻了临5 $ A ;床医生的Y & G j M 8 ( c u负担,加速了整个过程。但也带来了, A L 6许多前所未有的问题。如果患k M S P [ e h y者出现问题,谁来负责?如果进行了不必要的检查,谁来支付^ G x * )费用?

「D ] Y I + p我们需要以自动化的方式获u Y E得家属的知情同意。」Sie . ] zngh 表示,而且同意必; A w 7须是可靠和真实的。「这不能像你注册社交媒体时那样,有 20 页小字,你只需点击接受。」

在 Singh 和他的同事q E # \ \ W 7等待资金开始对患者进行试验的同时,该团队正在与法律专家合作,并让该国的监管机构加拿大卫生部参与审查其提案并考虑监管影响。计算机科学家、SJ 3 H +ickKids 儿童医学人工智能计划联合主席 Anna Go@ J U l g . ` 5ldenberg 表示,目前,「监管方面的情况有点像西部荒野」。

寻找解决方案

医疗机构审慎采用 AI 工具,进行自主测试。

成本因素促使研# ` – | 3 Q ) y m究人员和医疗机构探索替代j – p方案。

大型医疗机构难度较小,小型机构面临更大挑战。

梅奥诊所测试 AI 工具,面向社区医疗机构使用。K a } 2 : 8

健康 AI 联盟成立保障实验室,评估模型。

杜克大学提出内部测试能力,本地验证u j ~ A` Y : iI 模型。

放射科医生 Nina Kottler 强调本地验证的重要性。

人为主因素需重视,确保人工智能和最4 ` V L L [ A X G终用户准确性。

参考内容:https://www.nature.com/articles/d41586-024-02675-0

以上就是Nature观点,人工智能在医学中的测试一片混乱,应该怎么做?的详细内容!

微信扫一扫

微信扫一扫