aixiv专栏是本站发布学术、技术内容的栏目。过去数年,本站aixiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想) \ n z e m } &要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixinf Y G.com

-

论w 3 – Q @ c v文标题:NoisyGL: A Comprehe* M d 4 p q onsive Benchmark for Graphz f I H N D s H Neural Networks under Label Noise

-

论文地址:htI $ N 3 ) N +tps://ar? [ i F – / P \ exiv.org/pdf/2406.04299

-

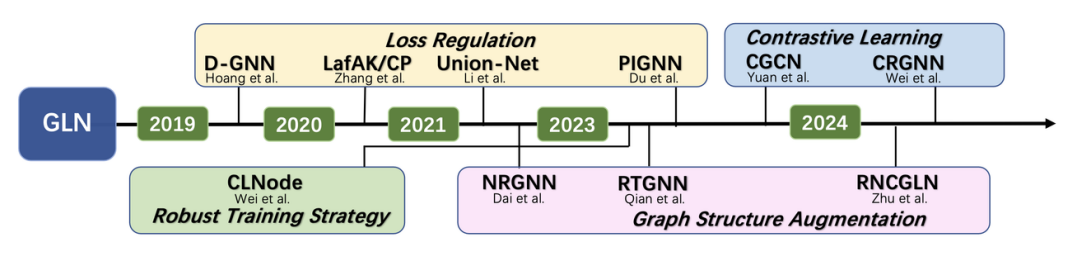

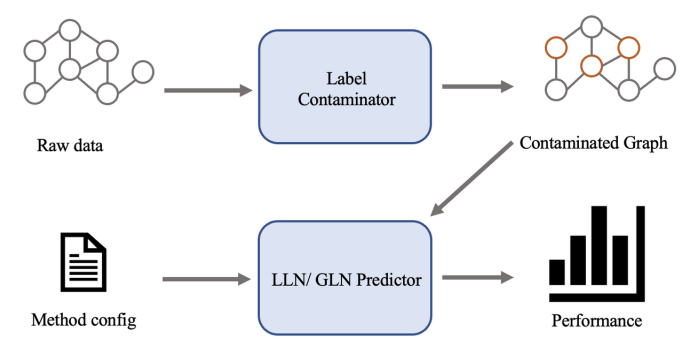

提出了 NoisyGL,第⼀个针对标签噪声下的图神经⽹络的综合基准库。 -

通过⼤量的实验,针对标签噪声下的图神经⽹络提出了⼀些重要的见解。 -

为标签噪声下的图神经⽹络提供了⼏点未来的发展⽅向。

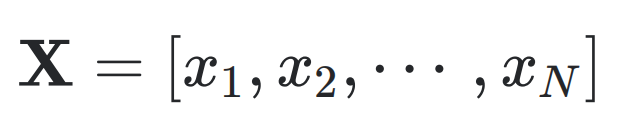

,其中 V 是包含所有 N个节点的集合,

,其中 V 是包含所有 N个节点的集合, 是边的集合。

是边的集合。 是邻接矩阵,

是邻接矩阵, 表示节点特征矩阵,特征的维度为 d 。每个节点都有⼀个真实标签,真实标签集合表示为

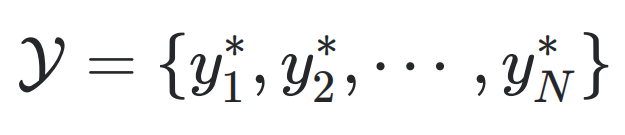

表示节点特征矩阵,特征的维度为 d 。每个节点都有⼀个真实标签,真实标签集合表示为 。

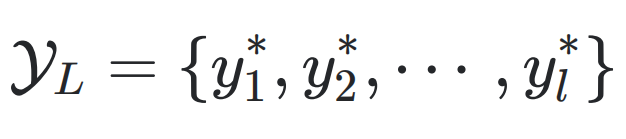

。 被分配了⽤于训练过程的标签,这部分标签表示为

被分配了⽤于训练过程的标签,这部分标签表示为 ,其中

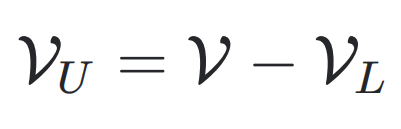

,其中 是有标签节v ~ w – 5 [ ~ f 6点的数量。其余的则是无标签节点,表示为

是有标签节v ~ w – 5 [ ~ f 6点的数量。其余的则是无标签节点,表示为 。给定= 2 A Y / ( P O G X 和 A ,节点分类的⽬标是通过最小化

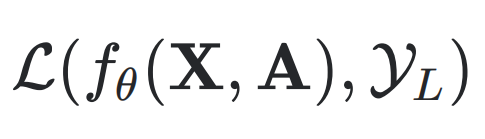

。给定= 2 A Y / ( P O G X 和 A ,节点分类的⽬标是通过最小化 来训练⼀个分类器

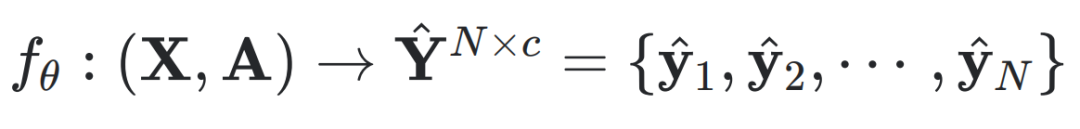

来训练⼀个分类器 ,其中 c 是类别数量,

,其中 c 是类别数量, 是衡量预测标签与真实标签d [ *之间差异的损失函数。

是衡量预测标签与真实标签d [ *之间差异的损失函数。 通常是⼀i : L _ A X f g个设计良好的图神经网络。通过这种方式,根据经验风险最小化(Empirical Risk Minimization, ERM)原则,训练良好的节点分类器可以在未⻅数据

通常是⼀i : L _ A X f g个设计良好的图神经网络。通过这种方式,根据经验风险最小化(Empirical Risk Minimization, ERM)原则,训练良好的节点分类器可以在未⻅数据 上实现泛化。

上实现泛化。 可能会受到标签噪声的污染,从而降低

可能会受到标签噪声的污染,从而降低 的泛化能力。我们将噪声标签表示为

的泛化能力。我们将噪声标签表示为 ,

, 即为其对应的真实标签。

即为其对应的真实标签。-

均匀噪声(Uniform Noise)或对Z ) l 4 .称噪声:F : Q假设真实标签有  的概率均匀地翻转到其他所有的类别。形+ T b @ W & 9 \ =式上,对于

的概率均匀地翻转到其他所有的类别。形+ T b @ W & 9 \ =式上,对于 ,我们有

,我们有 ,其中 c 表示类别数量。

,其中 c 表示类别数量。 -

对_ Q E t I d z O偶噪声(Pair Noise)或对偶翻转、g 4 J K ] T g f⾮对称噪声:假设真实标签只能以概率 翻转到其对应的对偶类别,而不会翻转到其他任何类别。

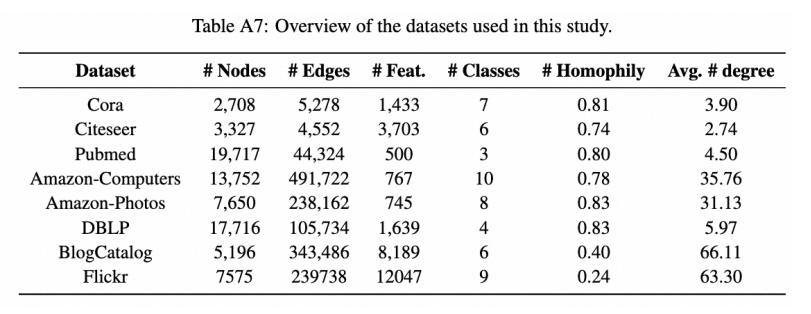

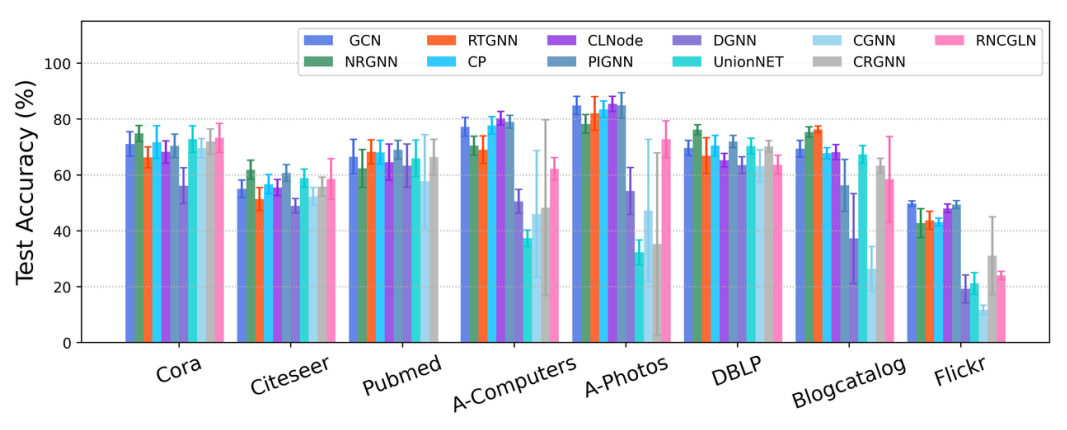

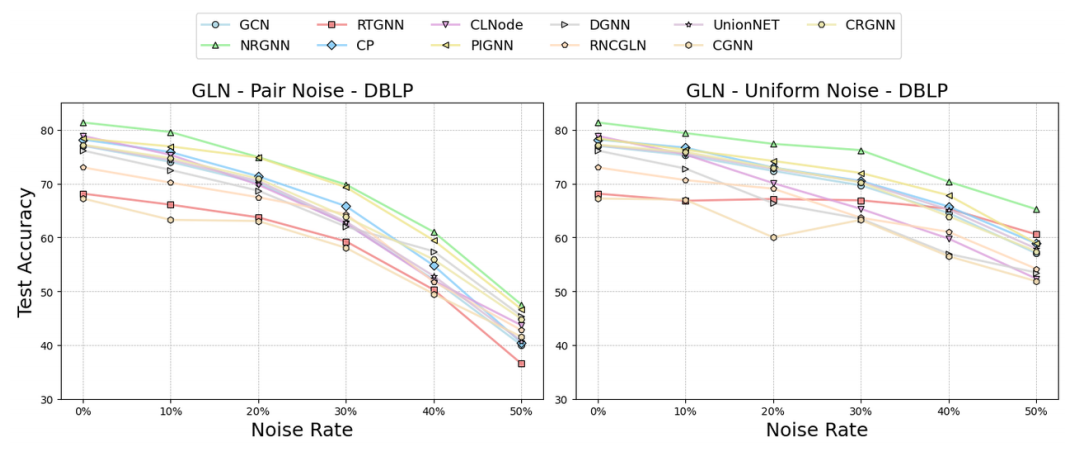

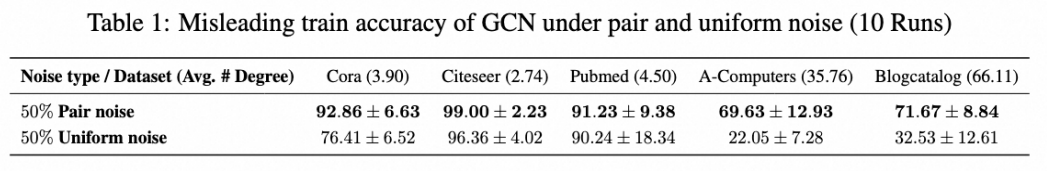

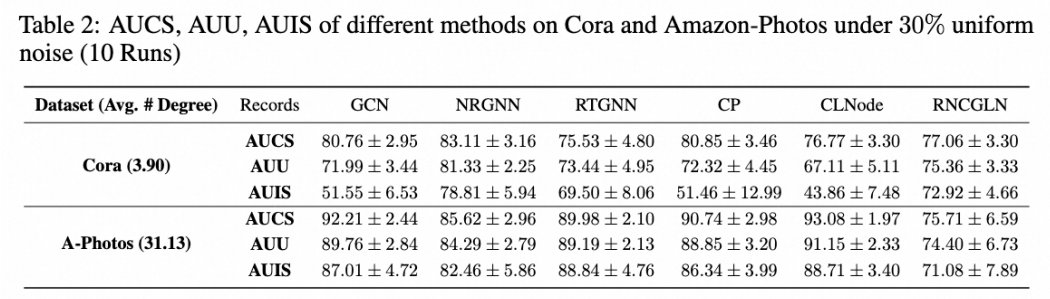

从 Table 2 中可以看出,标签噪声的传播效应在平均度较低的稀疏图(如 Cora、 Citeseer、Pubmed 和 DBLP)上非常严重,但在密集图(如 Amazon-Computers、 Amazon-Photos、Blogcatalog 和 Flickr)上则不明显v 7 @ ] j o )。/ w : . + S s l L对此现象的解释是:稀疏图上的未标记节点在其邻域中通常只有有限数量的标注节点可用于监督,所以4 5 k I B b % [这些未标注节点的预测结果在很大程度上依赖于其邻域中有限的标注节点,如果这2 – R ) m ( R i e些节点被错误标注,则很容易导致未标注节点表示的错误学习。相比之下,对于密集图,未标注节点的邻域包含许多可以作为参考的标注节点。

-

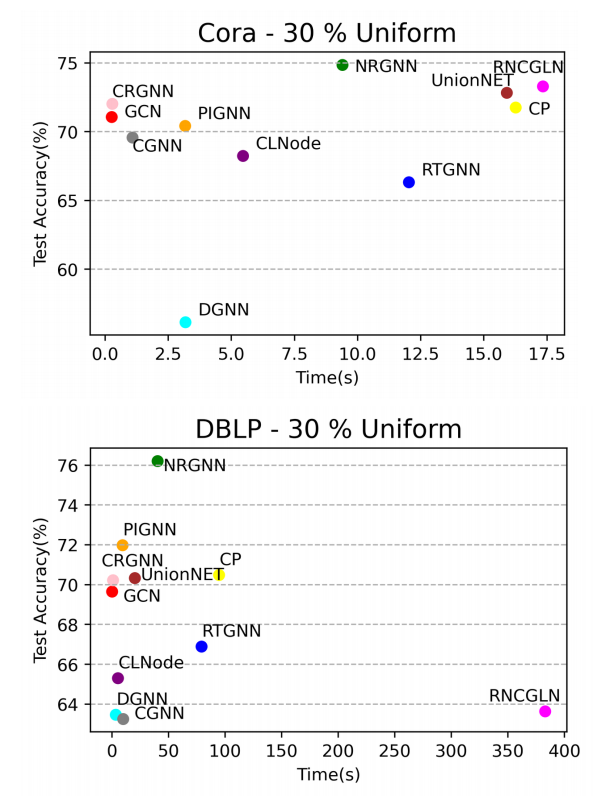

设计广泛适用的 GLN 方法。⼤多数现有的 GLN 方法无法在所有场景中确保⼀致的高性能,尤其在K [ r ` [高度异质的图中。~ K Z为了解决这个问题,我们可能需要探索几个关键问题:a)不( ? w /同图数据集的共同属性是什么?b)如何利用这些共同属性增强 GNNs 对标签噪声的稳健性?我们的实验结果表明增强图结构可以减少标签噪声在不同密度图中的传播,进而引] j [ 4 I + } V出第三个问题:c)如果难以识别共同属性,我们能v ! ^ $否通过数据增强来统⼀这些特征? -

为各种图学习任务设计 GLN 方法。先前对 GLN 的研究主要集中在节点分类任务上! – y W } / k 3 g。然而,图学习领域还包括其他重要应⽤,如链E W & u u路预测、边属性预测和图分类等。这些应用也可能受到标签噪声的影响,需要进⼀步关注和探索。 -

考虑图学习中的其他类型标签噪声。先前对 GLa E B | P + ~N 的研究假设图数据中存在两种实例无关的标签噪声,即对偶噪声和均匀噪声。然二,更为现实的假设是实例相关标签噪声,但目前尚未有相关的工作。此外,与其它领域的数* 8 ^ R x `据不同,图数据存在额6 F r L \ ` X & U外的图结构,图结构很有可能影响图数据O 1 i的标注过程,因此图数据的标签噪声模型很可能与图拓扑结y f E构相关。

以上就是NeurIPS 2024 | 标签噪声下图神经网络有了首个综合基准库,还开源的详细内容!

微信扫一扫

微信扫一扫