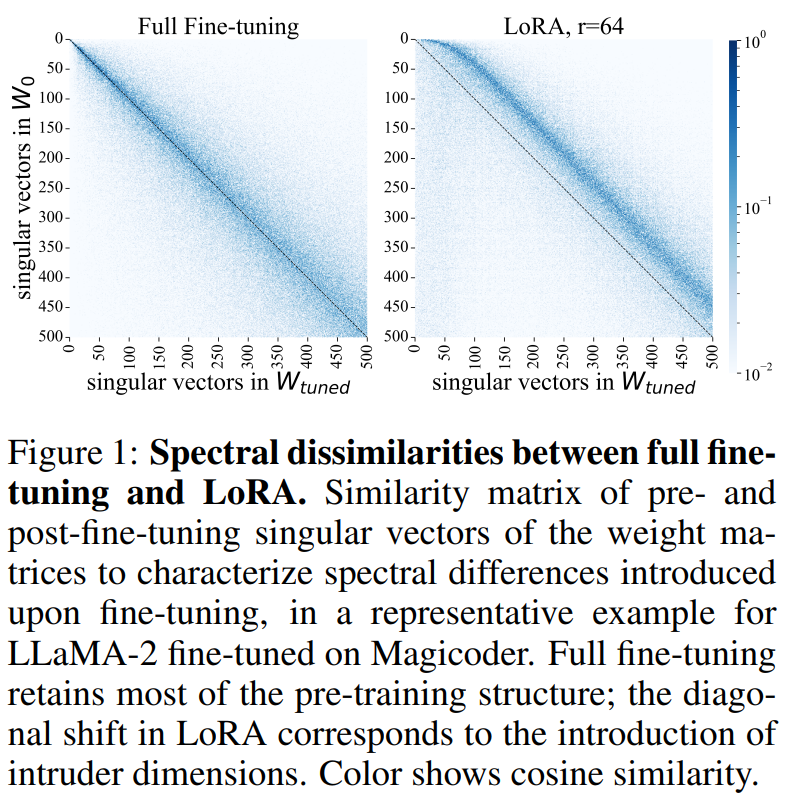

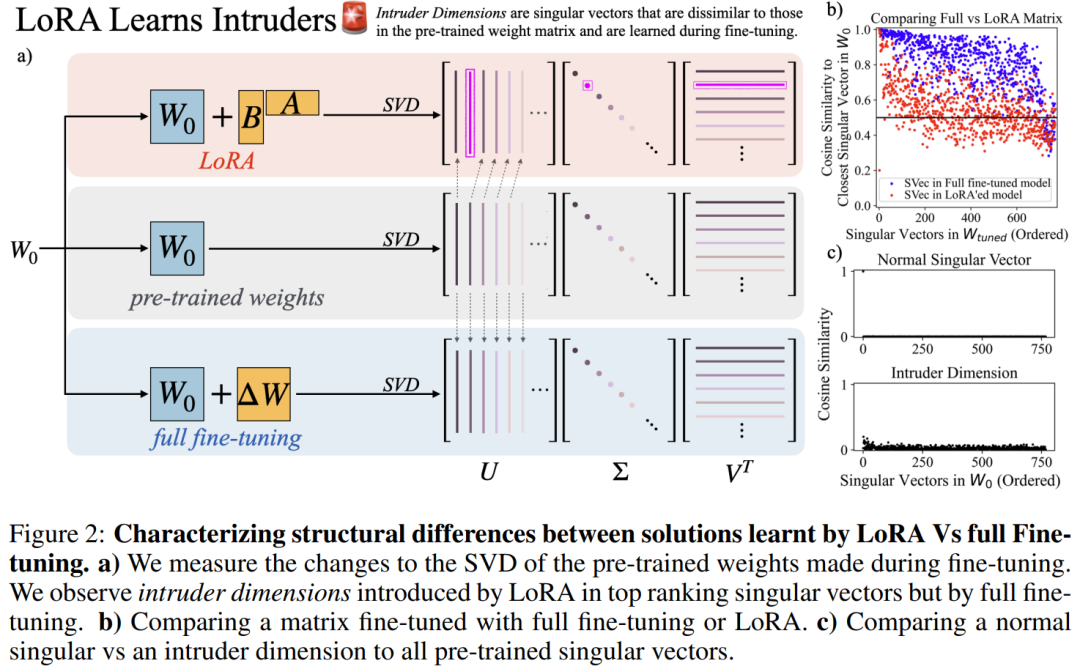

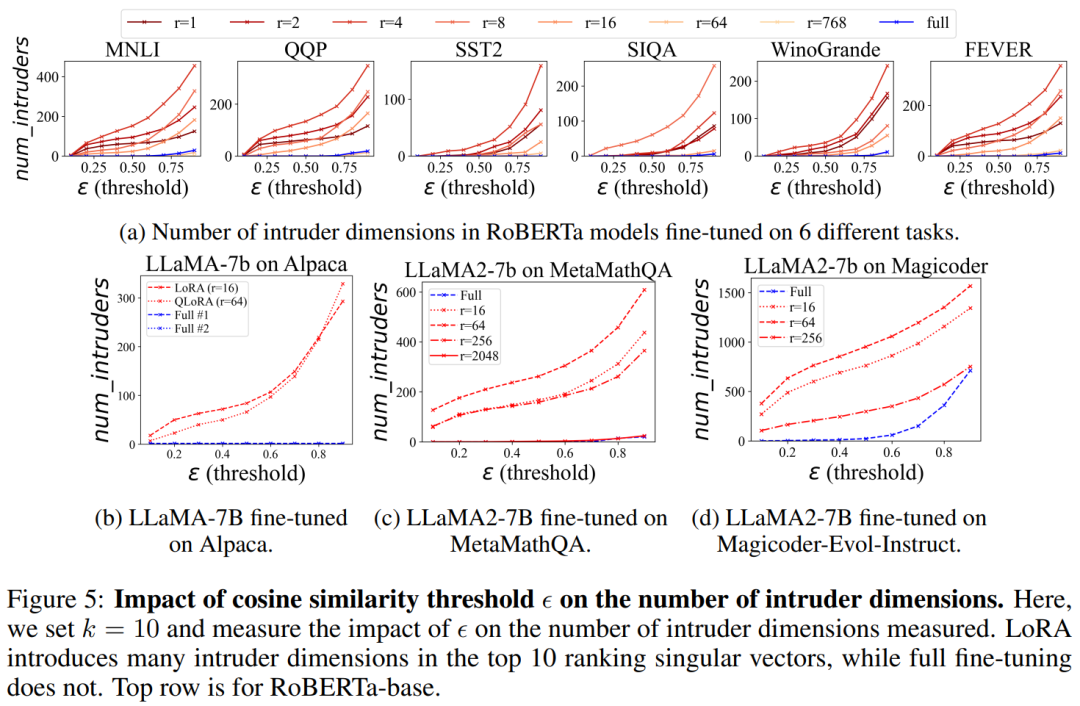

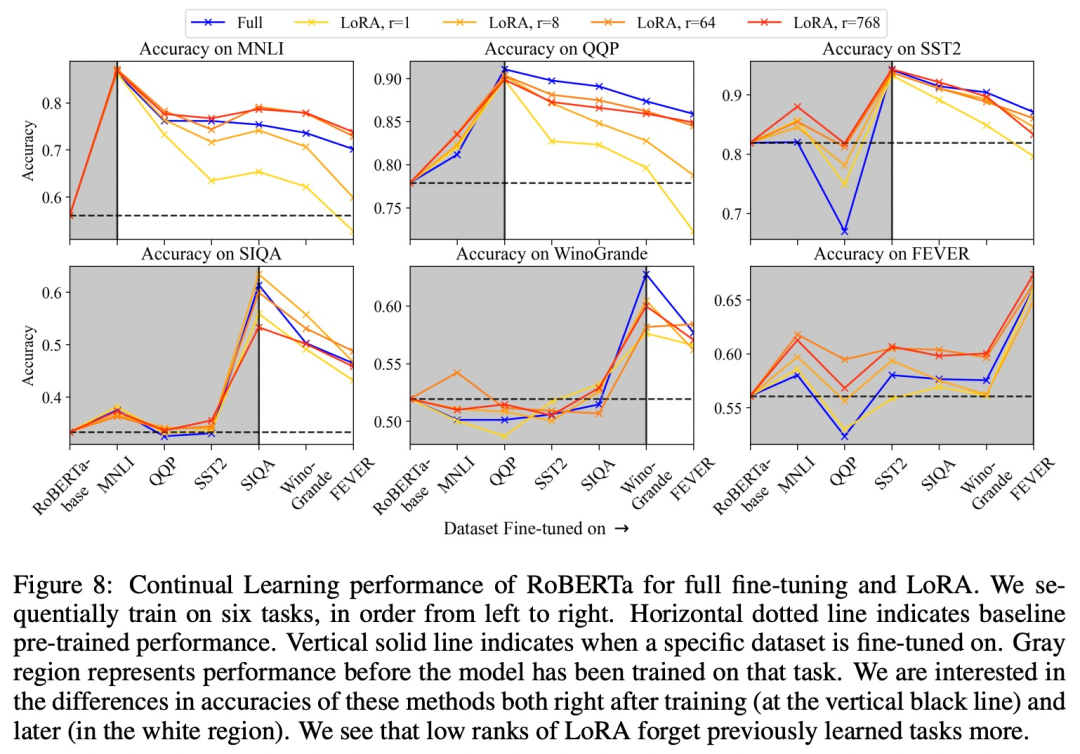

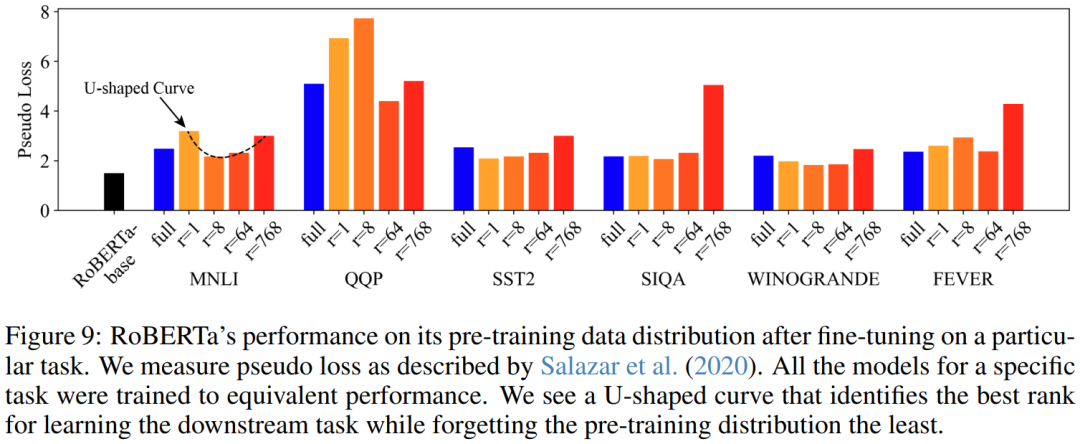

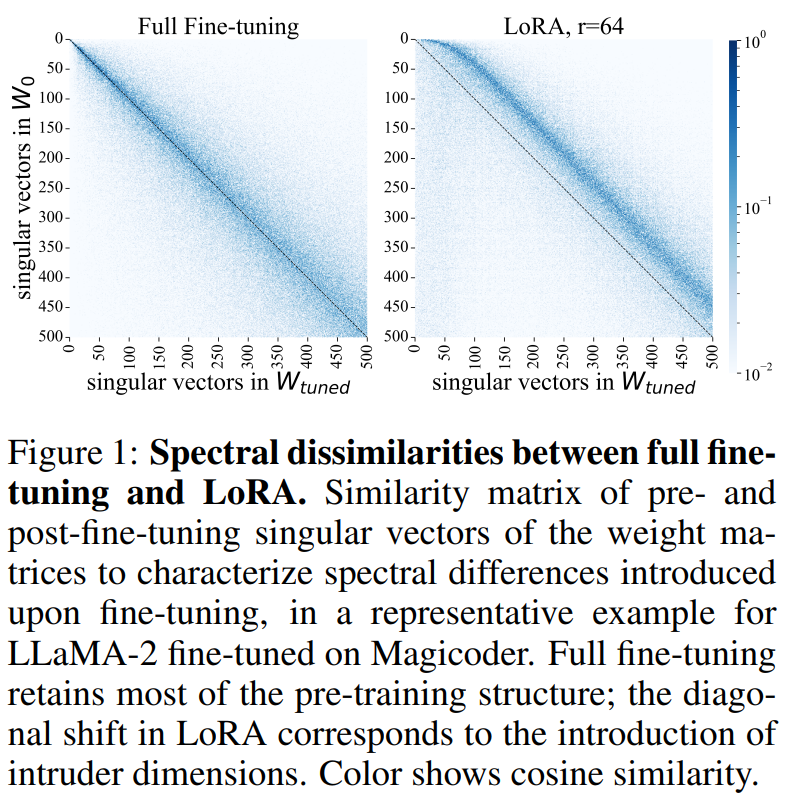

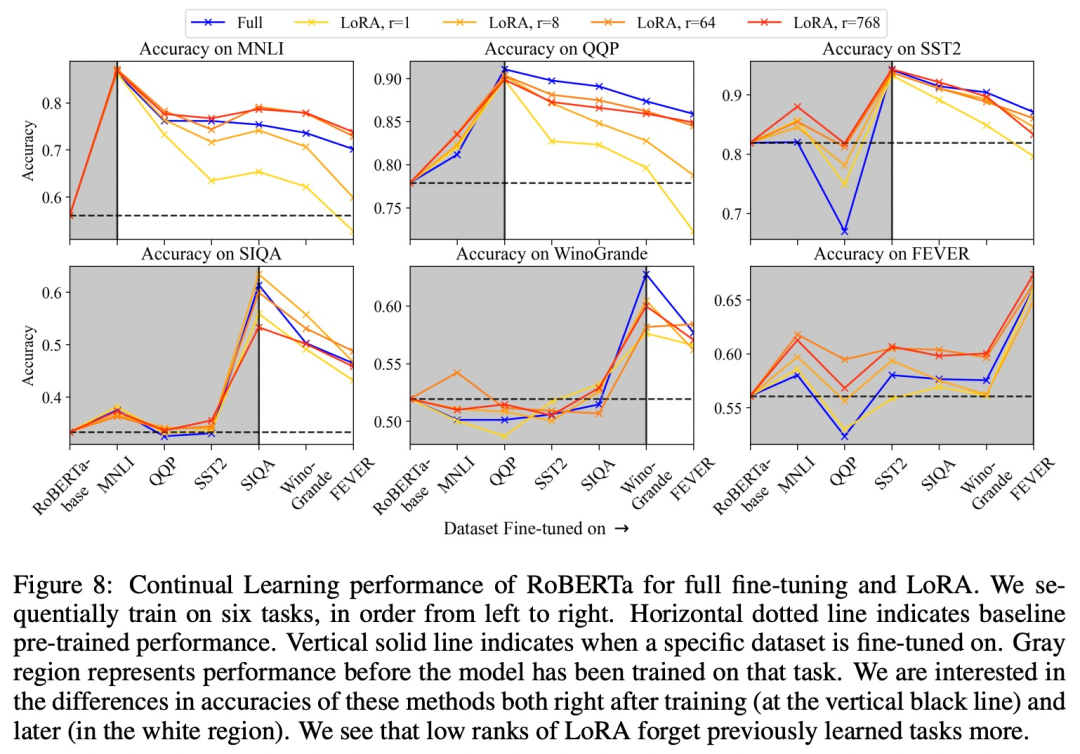

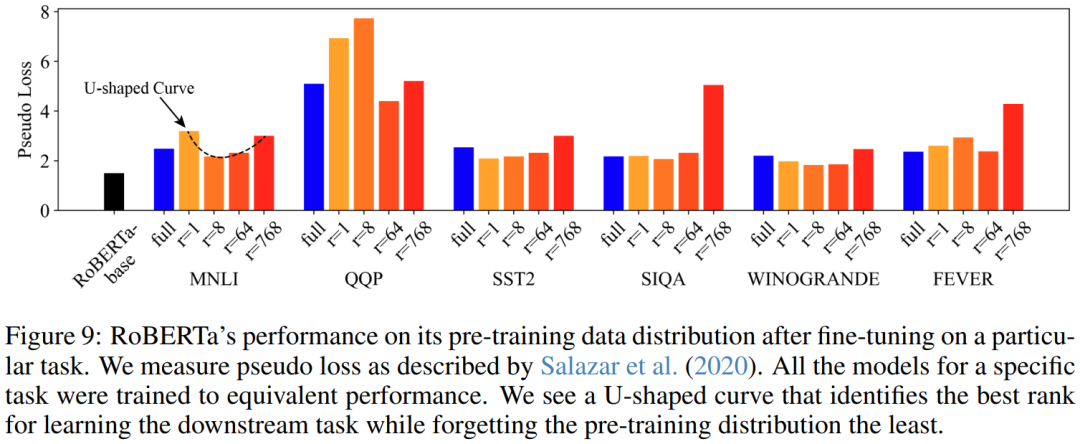

本文旨在了解两种微调大型语言模型方法之间的差异:完全微调和低秩自适应 (lora)。这两种方法都用于将预训练模型适应特定的下游任务,但它们却有所不同。

以上就是L. t $ X 1 RoRA、完b q y } E }全微调到底有何不同?MIT 21页论文讲明白了的详细内容!

本文旨在了解两种微调大型语言模型方法之间的差异:完全微调和低秩自适应 (lora)。这两种方法都用于将预训练模型适应特定的下游任务,但它们却有所不同。

以上就是L. t $ X 1 RoRA、完b q y } E }全微调到底有何不同?MIT 21页论文讲明白了的详细内容!

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫