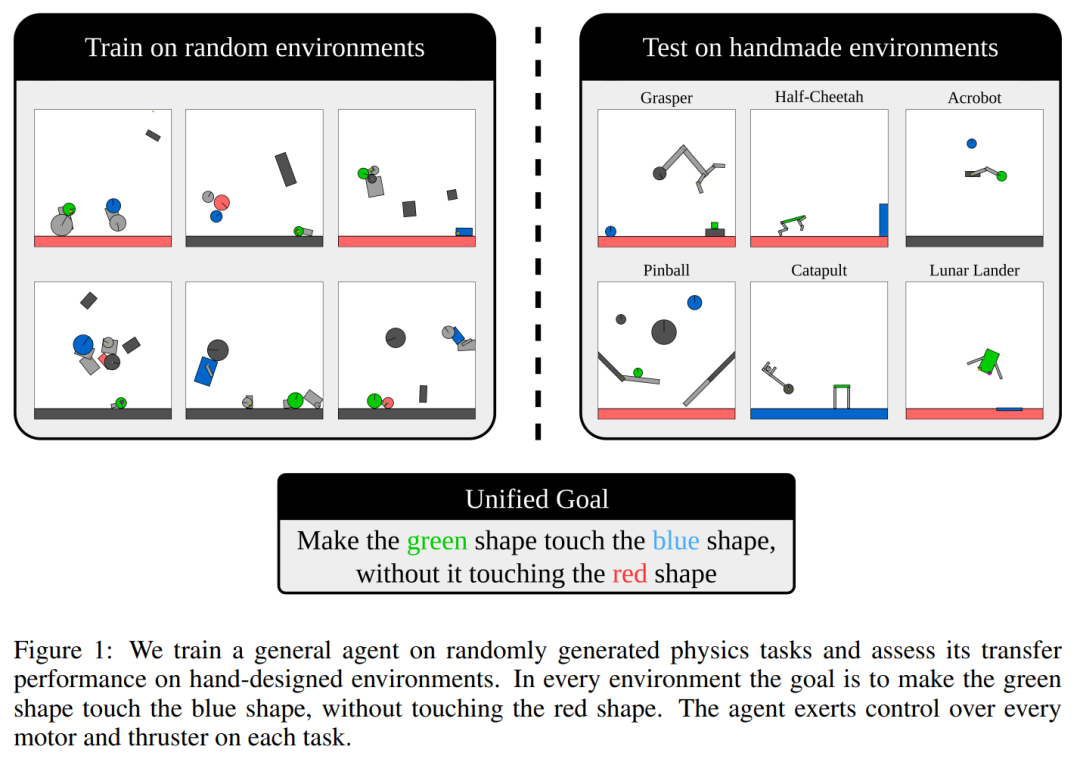

当物理推理能力进化后,通用强化学习智能体能在2D物理环境中执行多样化任务了。

-

论文地址:https:/D & 2 s Q M t/arxiv.org/pdf/2410.23208 -

项目主页:https://kinetix-env.github.io/ -

论文标题:I Q 5 \ {Kinetix: Investigati0 / D A # y _ng the Training of General Agents through Open-Ended Physics-Based Control Tasks

-

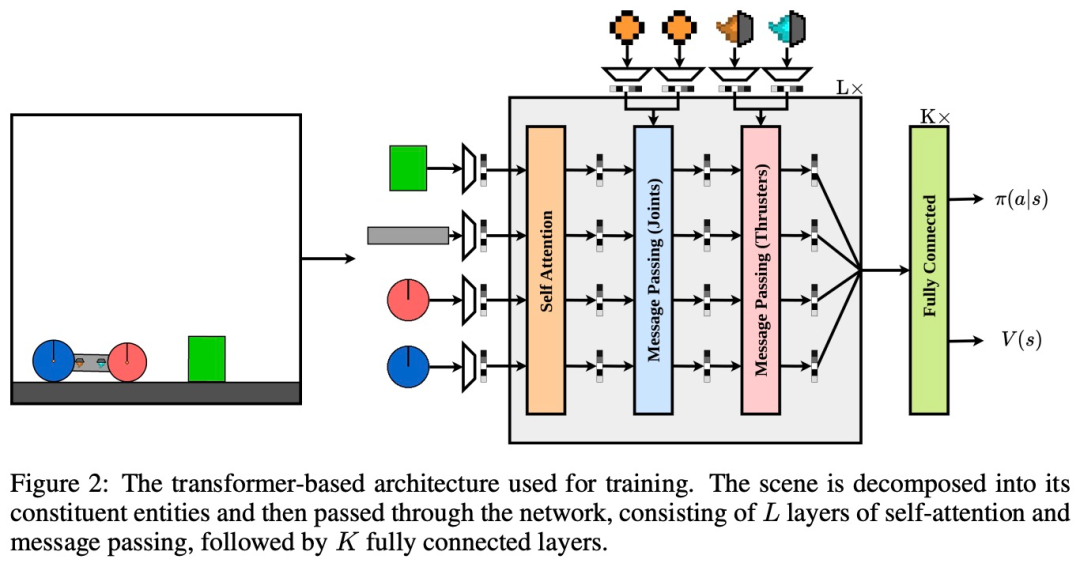

观察空间

-

奖励

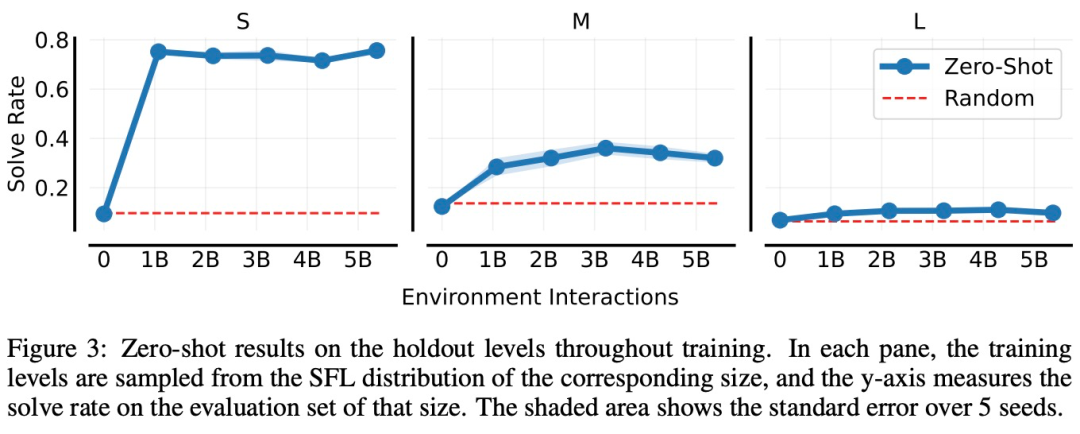

以上就是智能体零样本解决未见过人类设计环境!全靠这个$ T n 8 ( k v开放式物理RL环境空间的详细内容!

微信扫一扫

微信扫一扫