AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

论文题目:Mini-Omni: Language Models Can Hear, Talk While Thinking in Streaming -

论文地址:https://arxiv.org/abs/2$ S B { k U ; ^408.16725 -

代码仓库:https:/9 8 8 ; I G z ^ )/github.com/gpt-omni/mini-omni

-

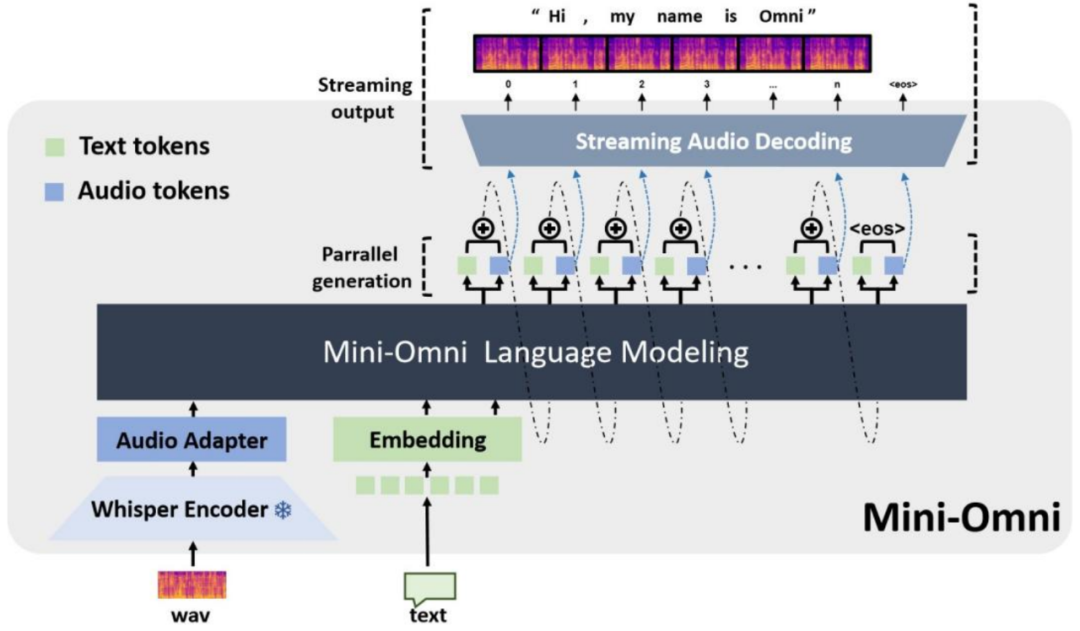

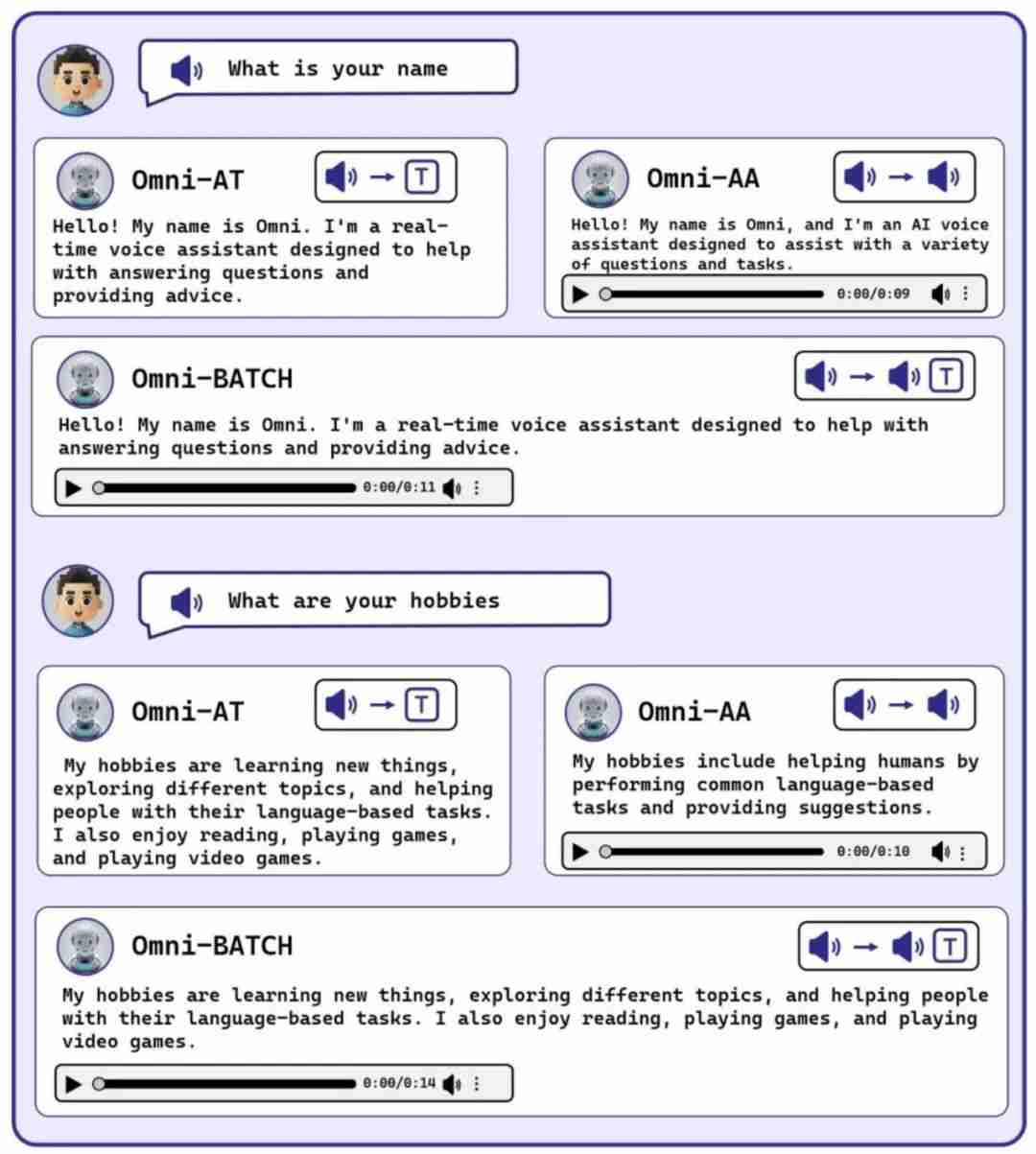

提出了^ o = * / t [ e p首个开% 0 1源的端到端D [ 8 $ r 8 A 5、实时语音a R 4 t e P T t N交互的多模i c 2 T态模型解决方案,支持语音流式输出,不需要额外的 ASR 或 TTS 系统。 -

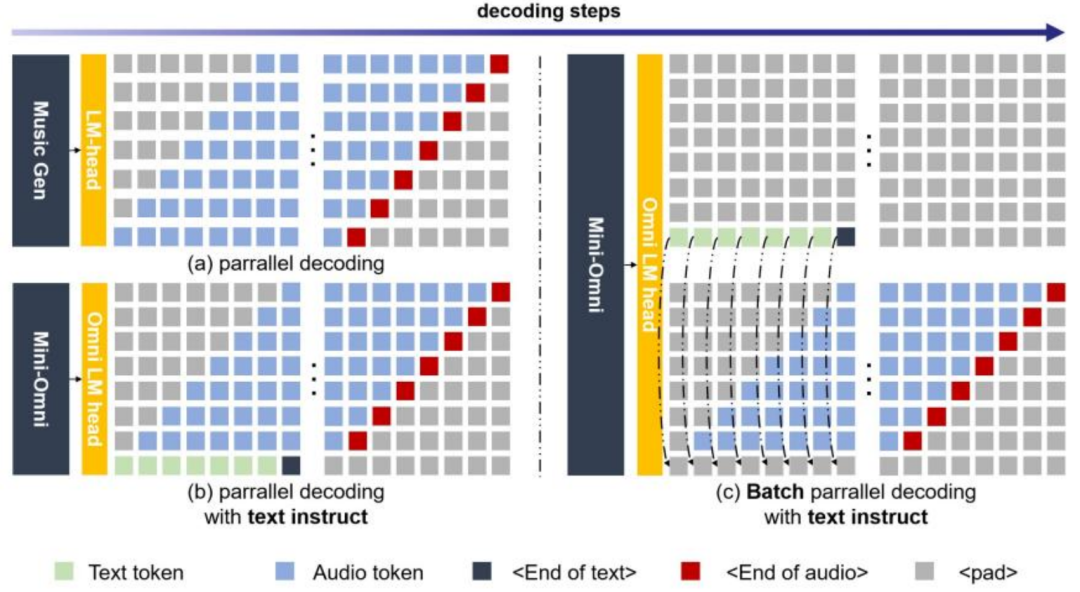

推理过程中,可同时生成语音和文本信息/ n 4 Y W F,通过文本指导语音生成,有效降低语音推理的学习难度。 -

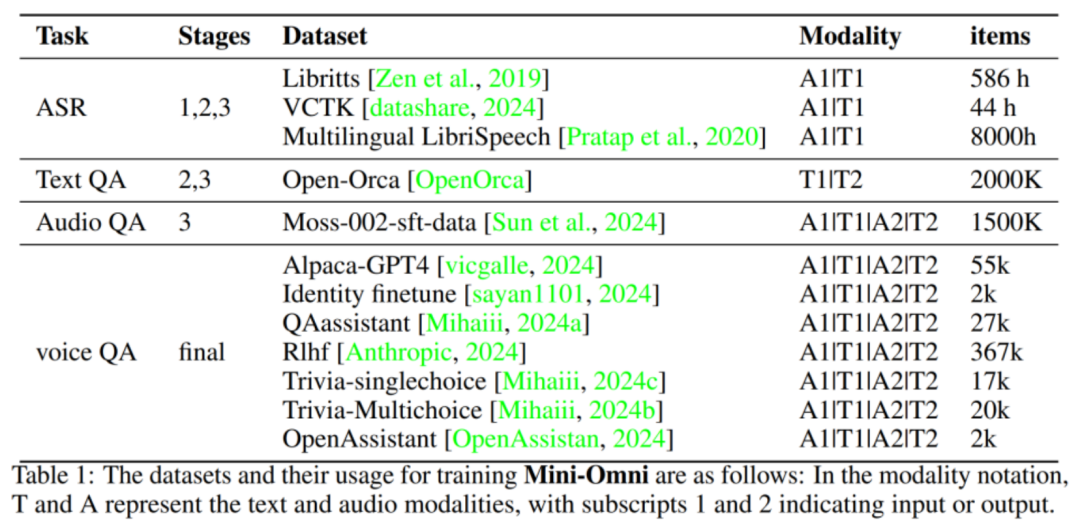

提出多阶段的训练方案,` ? c [ 4 {可通过少量开源或合成数据使任意语言模型具备语音交互能力。

以上就是让大模型能听会说,国内机构开源全球首个端到端语音对话模型Mini-Omni的详细内容!w | r 3 $ z _

微信扫一扫

微信扫一扫