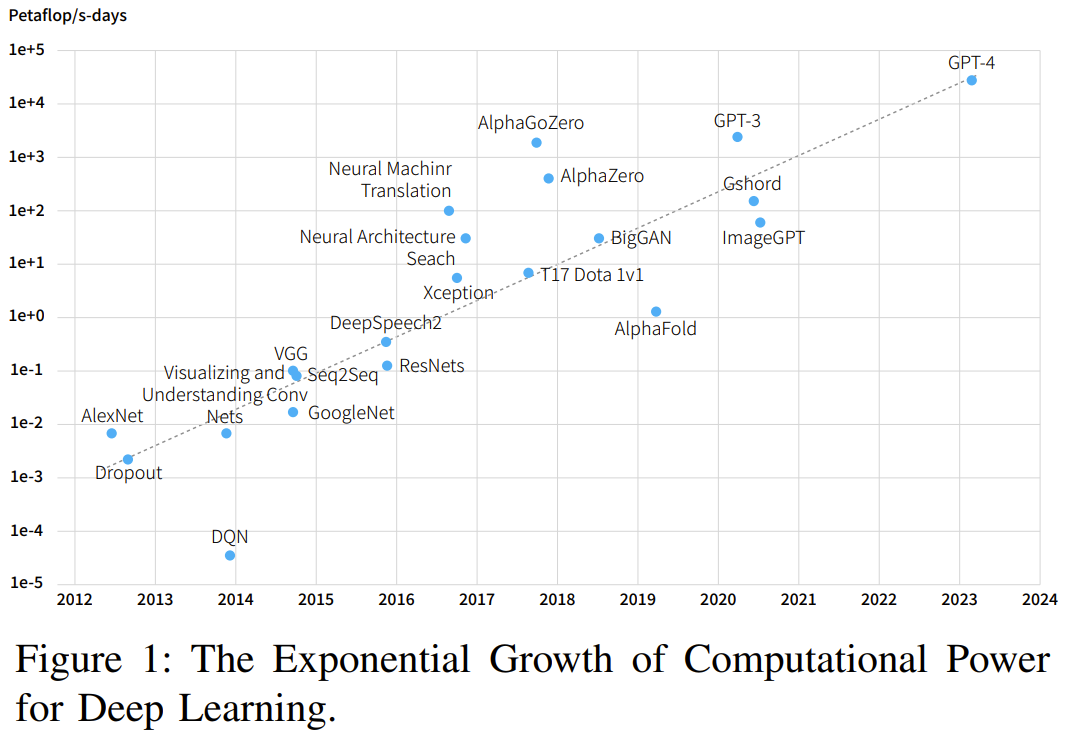

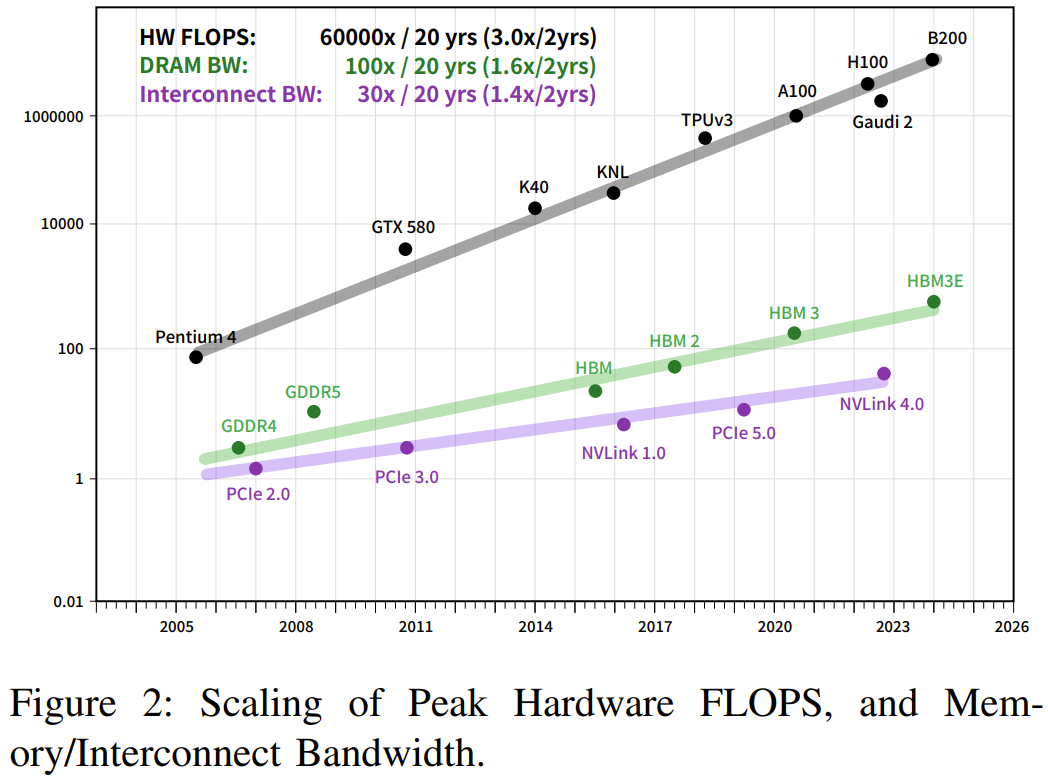

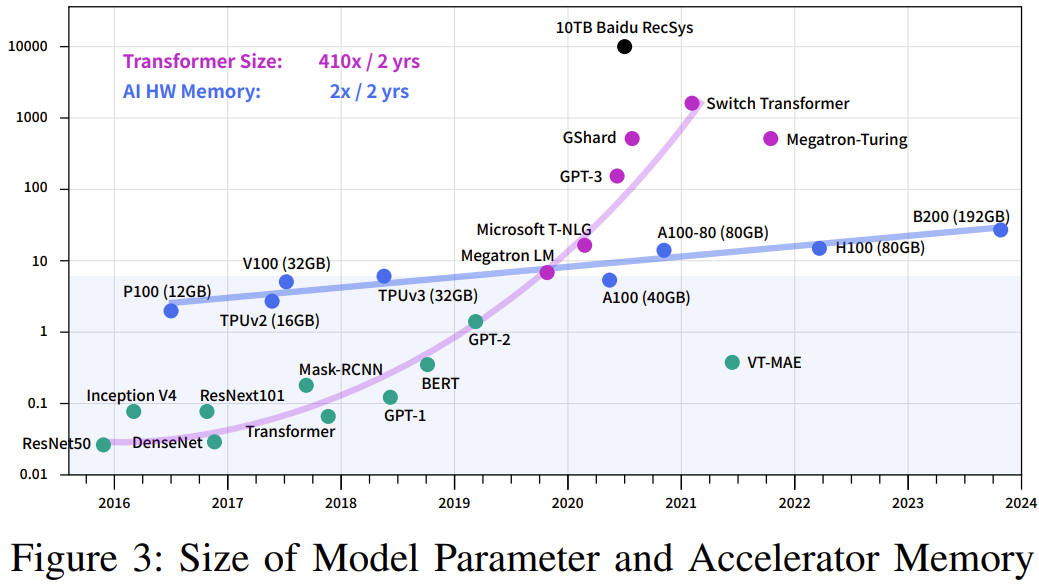

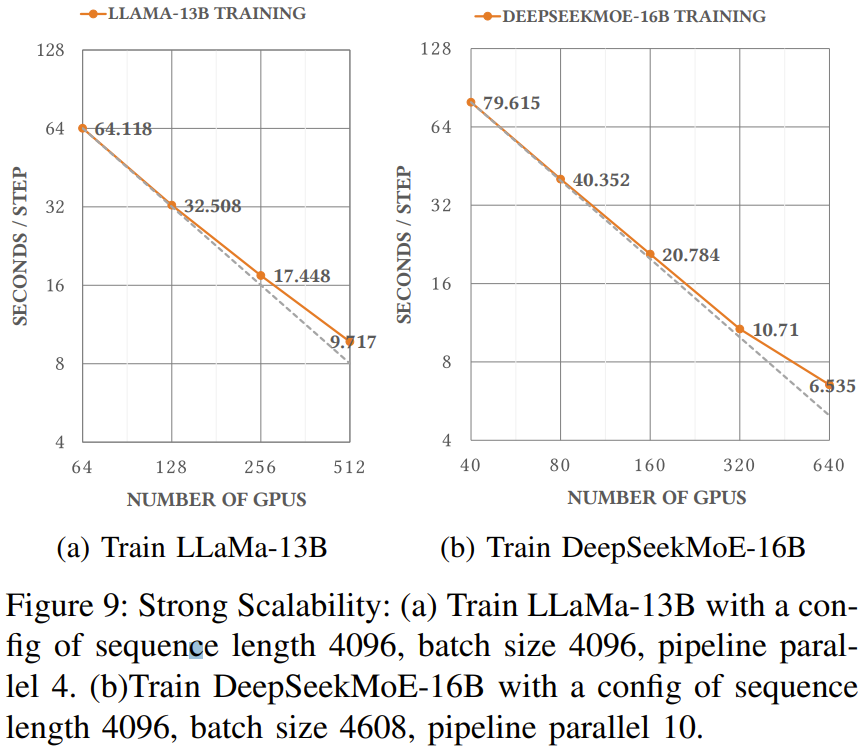

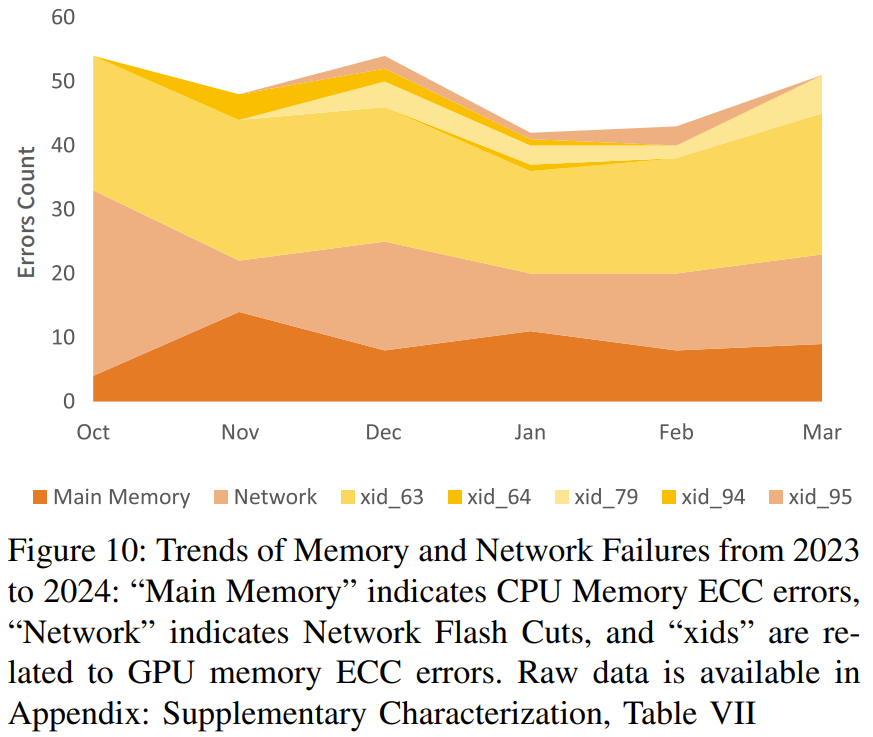

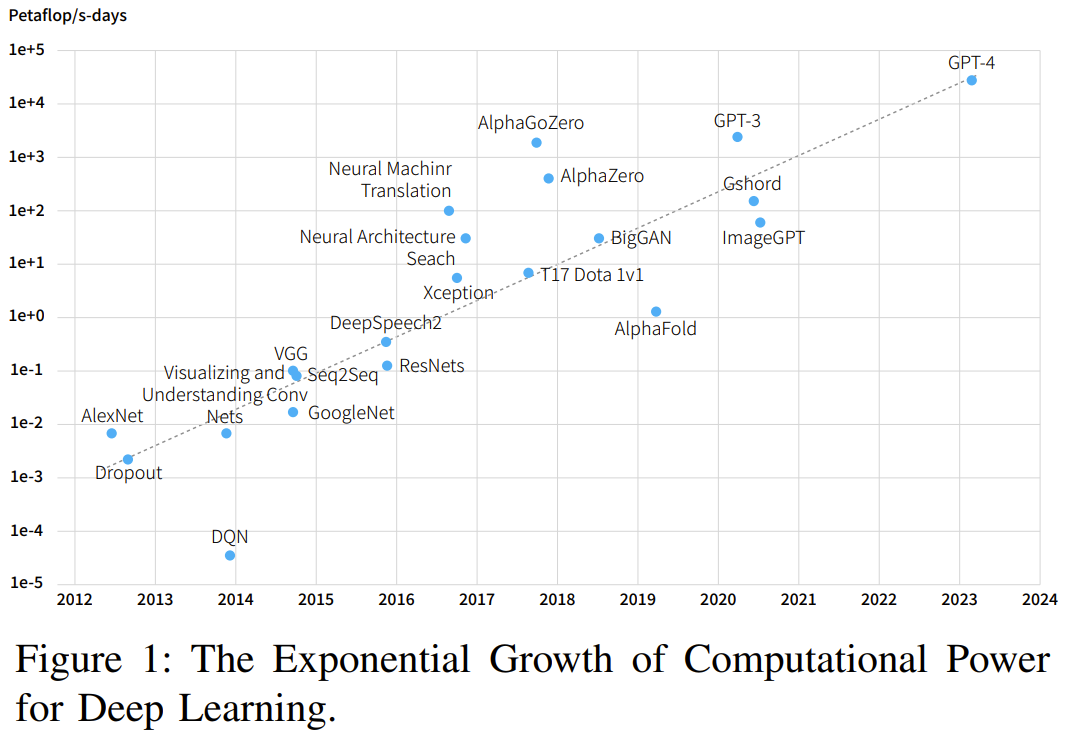

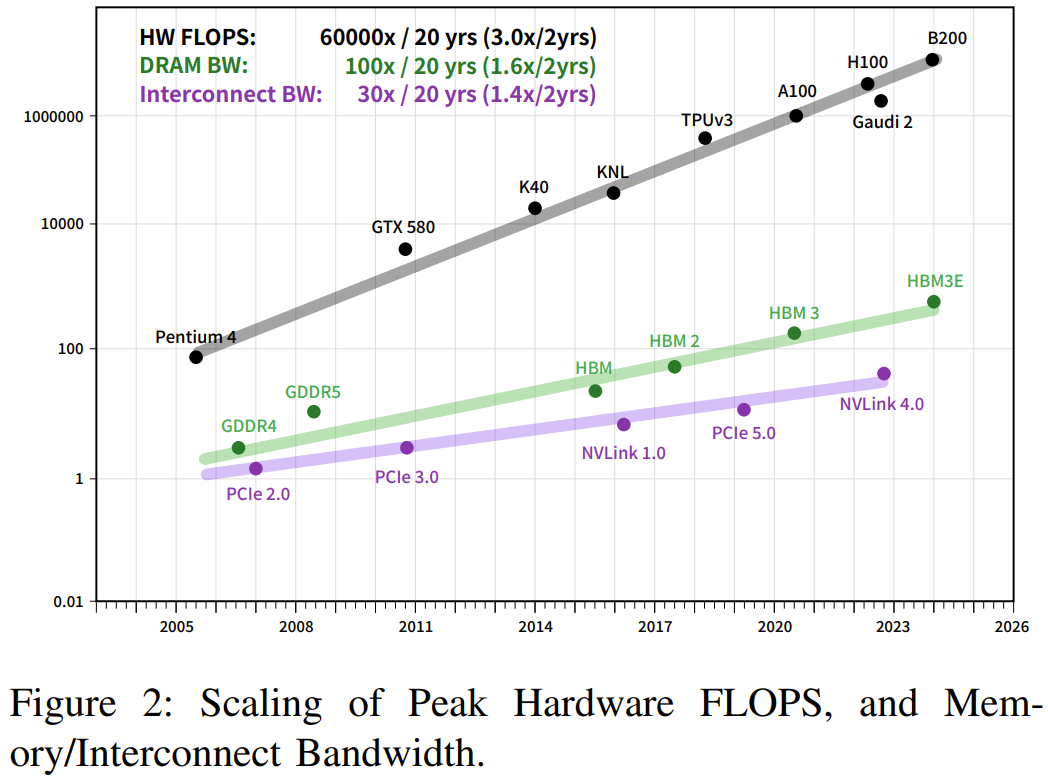

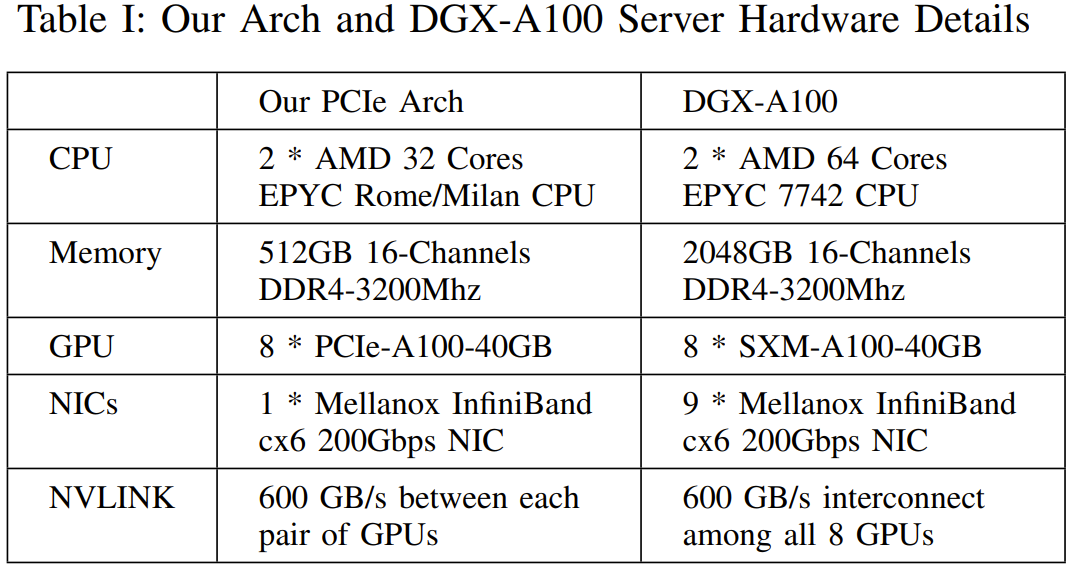

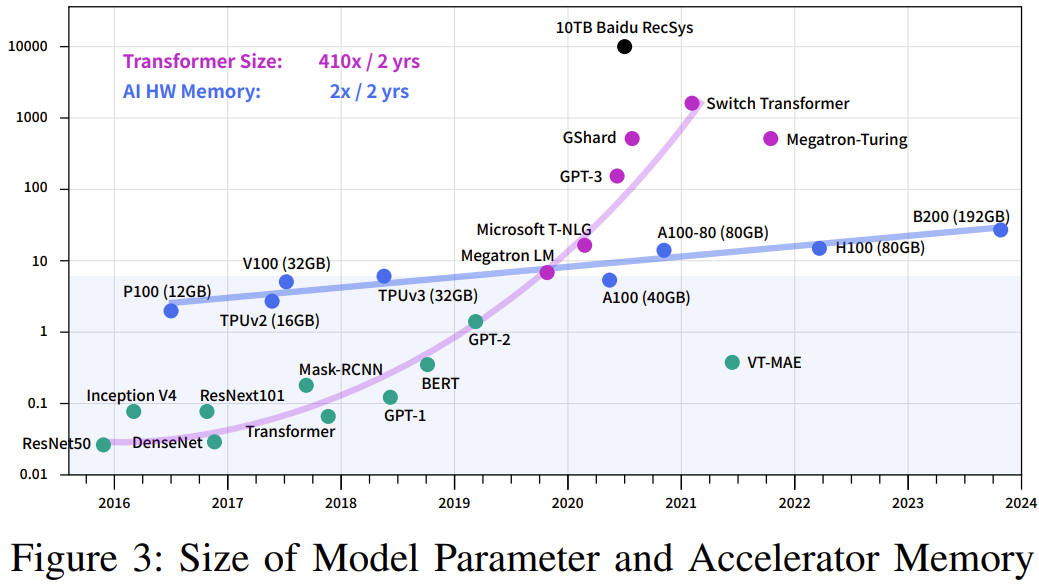

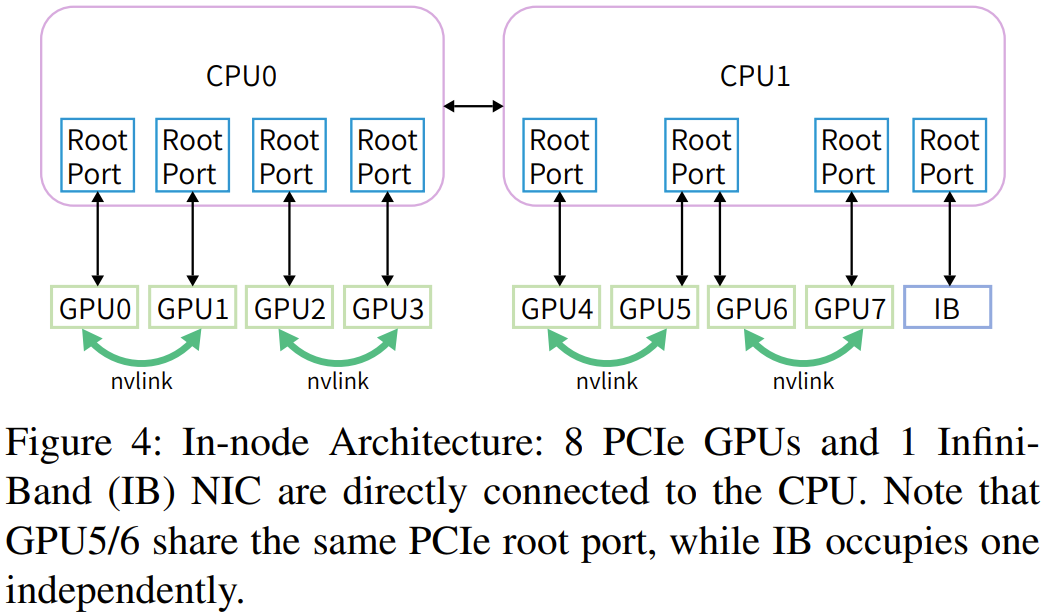

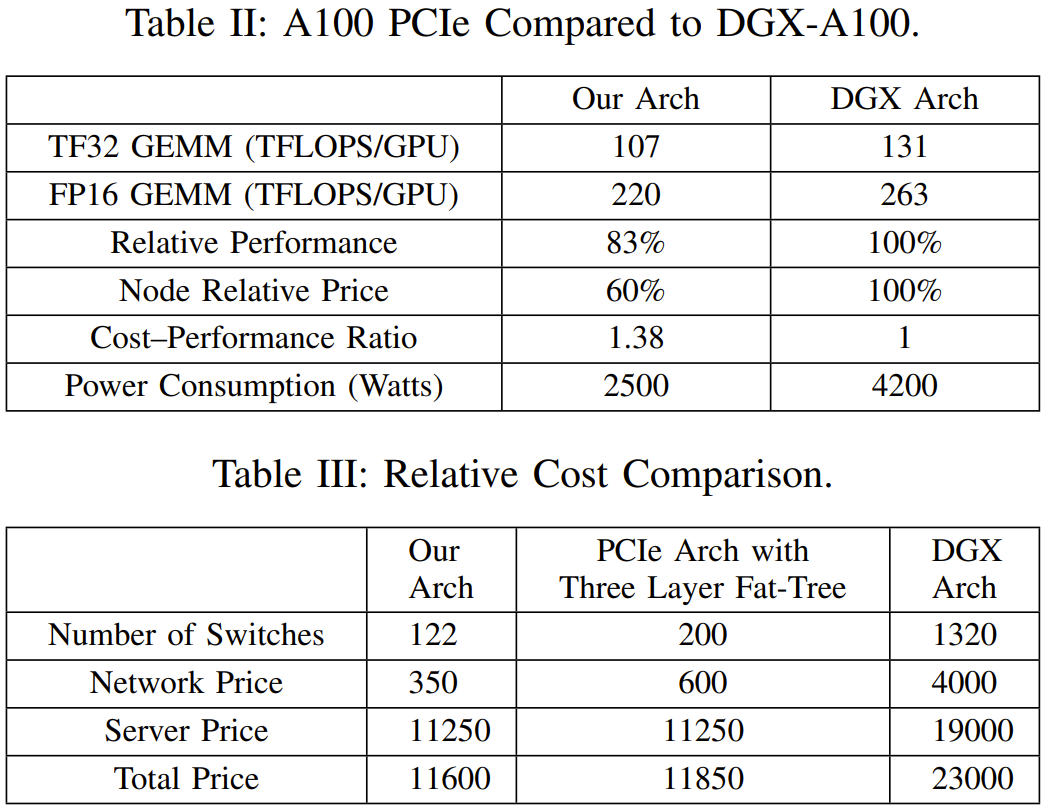

硬件发展速度跟不上 AI 需求,就需要精妙的架构和算法。

-

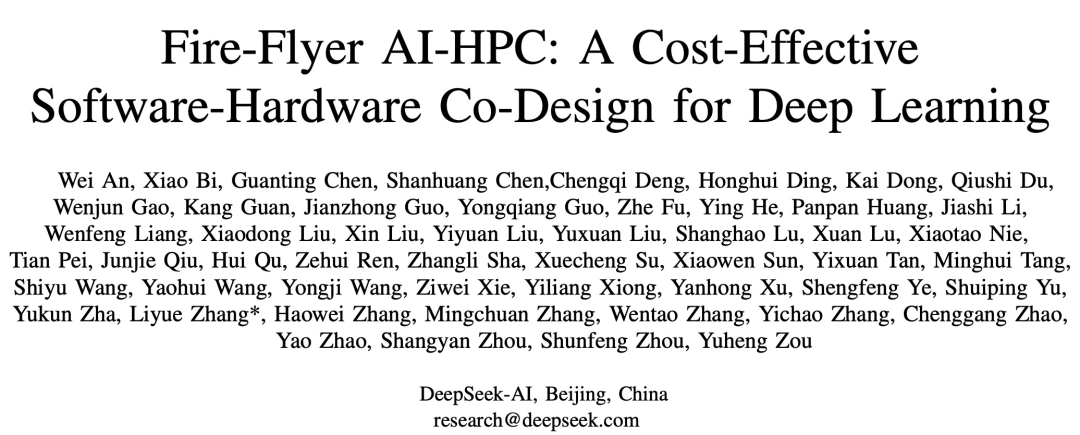

论文标题:Fire-Flyer{ F c l ; AI-HPC: A Cost-Effective Softl H ^ ! yware-Hardware Co-Design for DeY * * 6 Eep Learning -

论文地址:https://arxiv.org/2 m 8 J F # s \pdf/2408.14158

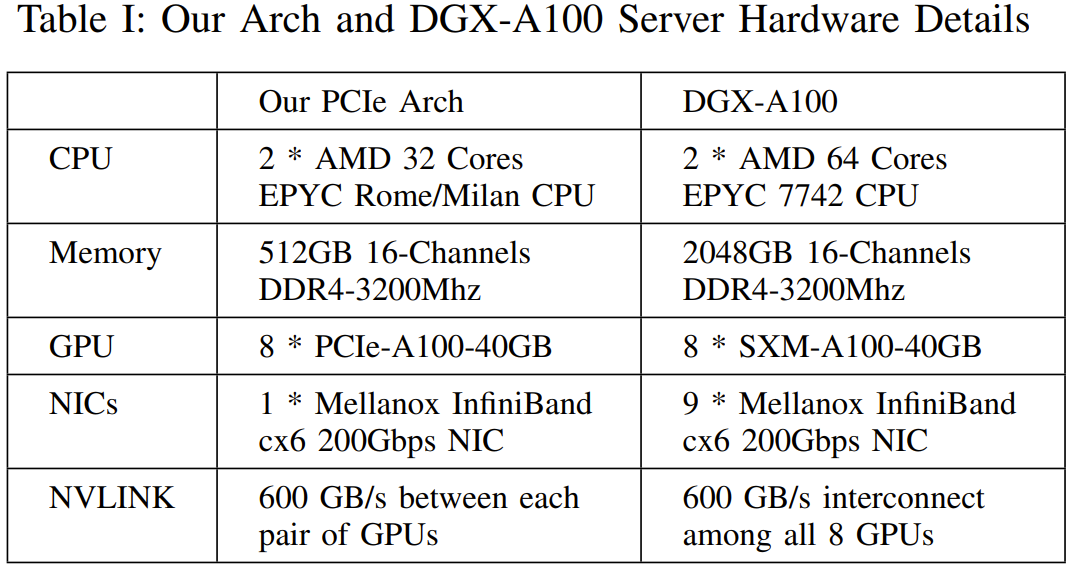

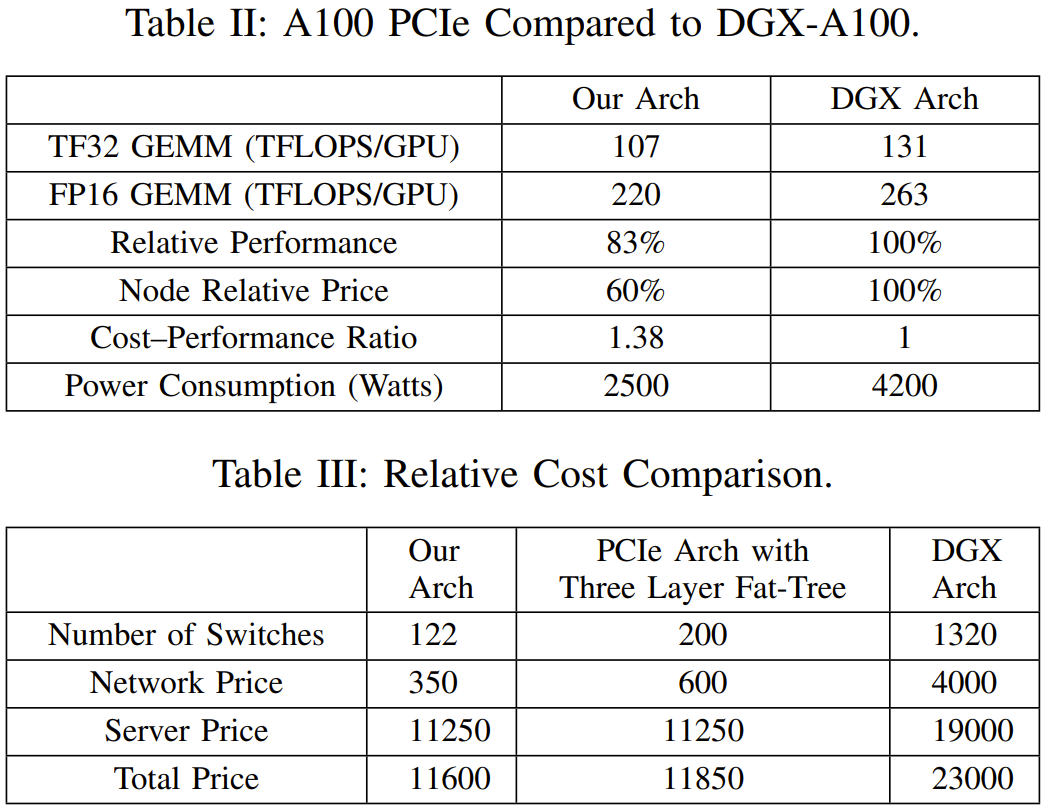

以上就是用60%成本干80%的事,DeepSeek分享沉淀多年的高性能深度学习架构的详细内容!

硬件发展速度跟不上 AI 需求,就需要精妙的架构和算法。

以上就是用60%成本干80%的事,DeepSeek分享沉淀多年的高性能深度学习架构的详细内容!

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫