aixiv专栏是本站发布学术、技术内容的栏目。过去数年,本站aixiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

论文标题:WISE:– z C % E Rethinking the Knowledge Memory for Lifelong Model Editing of Large Language Models

-

论文链接: https://arxiv.org/abF K Z ^ / V {s/2405.14768 -

代码链接: https://github.com/zjunlp/EasyEdit

来驱动 [3,16,17]。) v & e u l

来驱动 [3,16,17]。) v & e u l

-

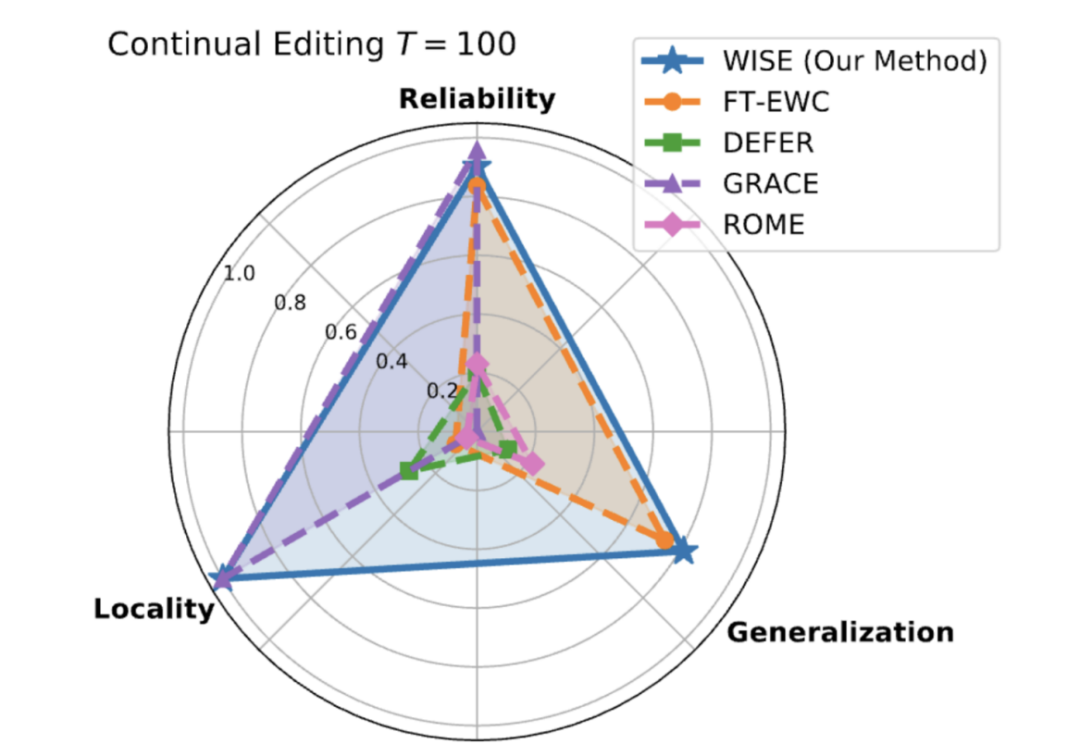

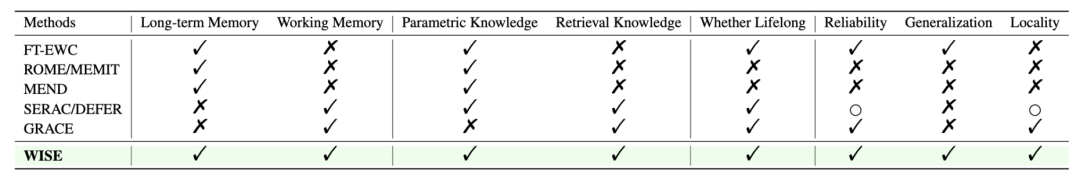

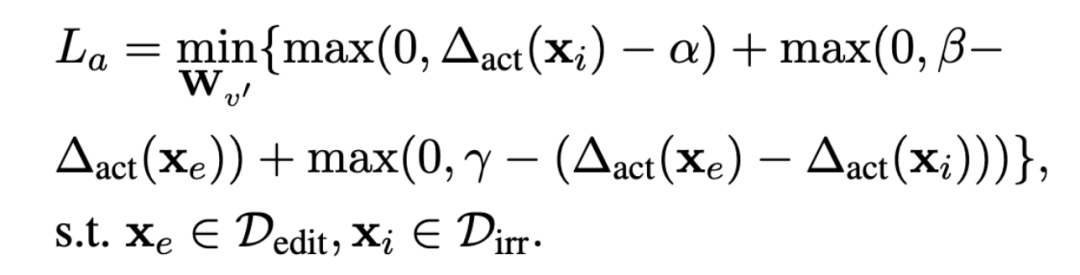

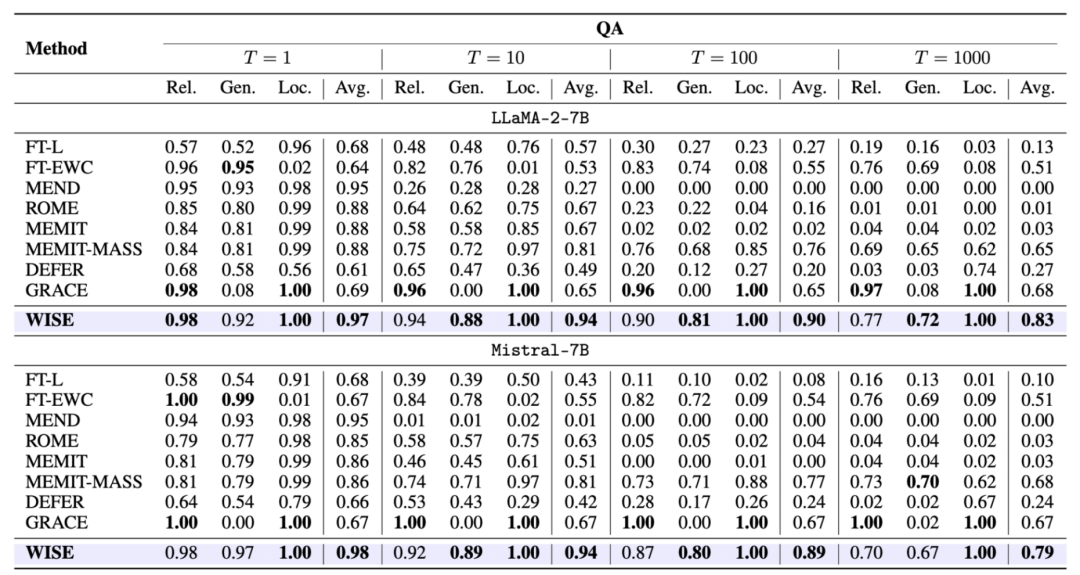

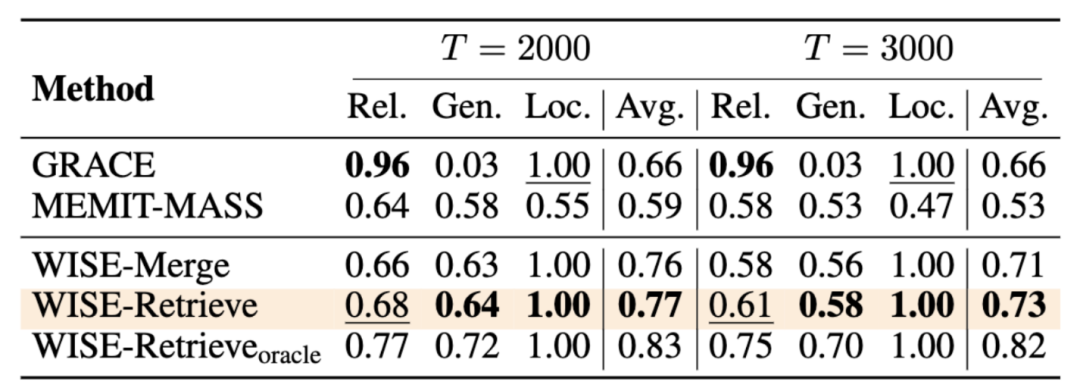

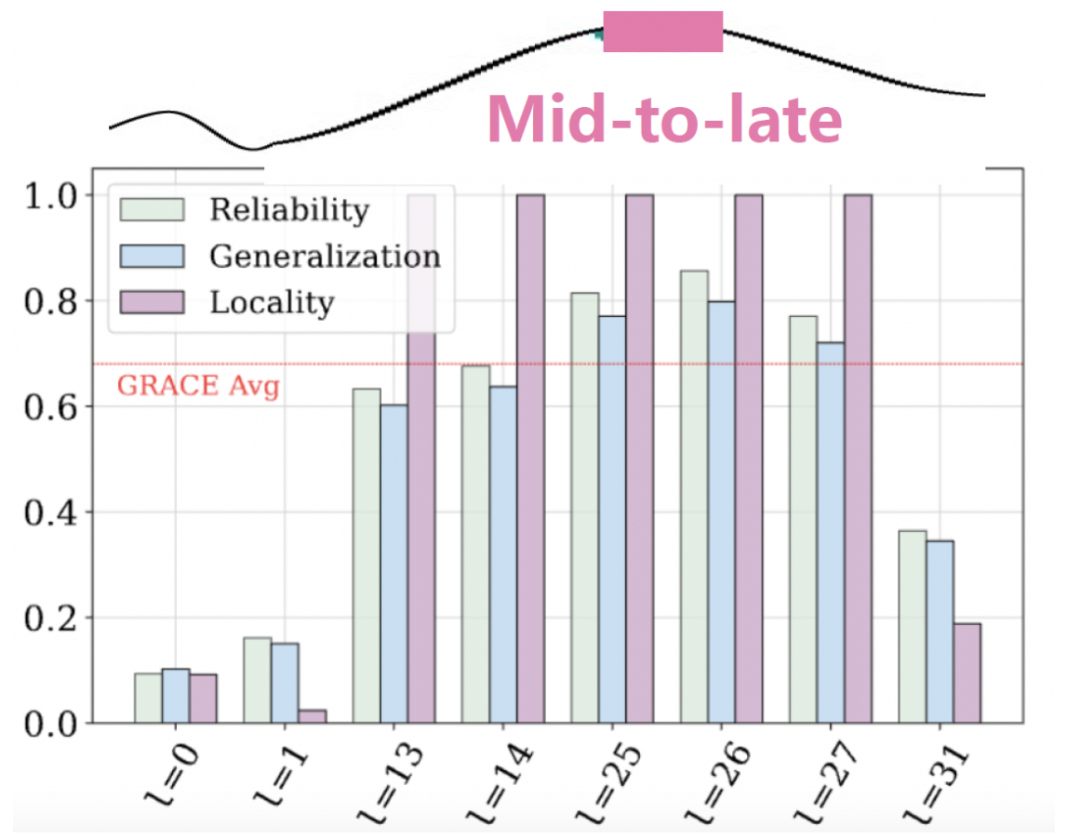

可靠性(Reliability):模型能够在顺序编辑后记住当前和之前的m / m P编辑操作。

-

泛化能力(Generalization)a R ) . D P ` x ;:模型不仅仅记住查询-目标对,] _ & k 3 e f #而是能够理解并泛化到不同类型的查询。

-

局部性(Locality):模型编辑操作不会影响与编辑知识无关的预训练知识。

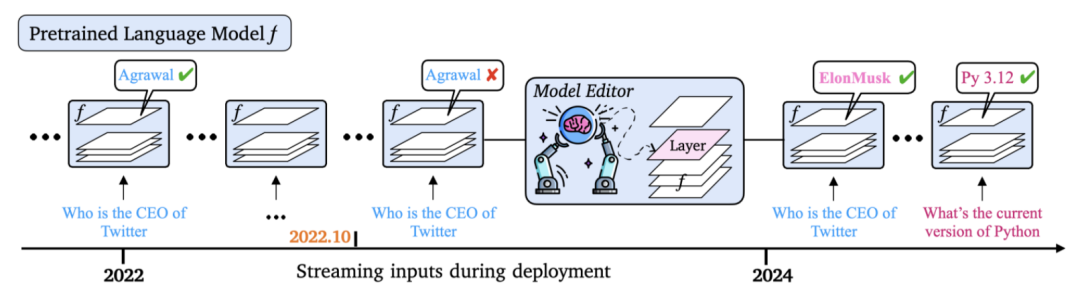

上预训练的模型

上预训练的模型 , 当模型需要纠正错误或注入新知识时会使用一个随时间变化的编辑数据z y + . Z \集

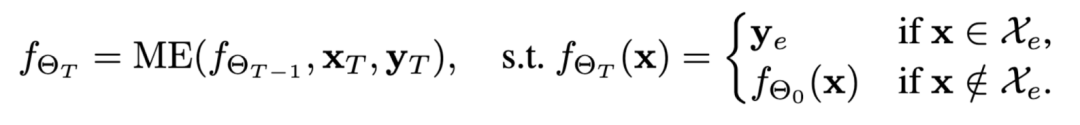

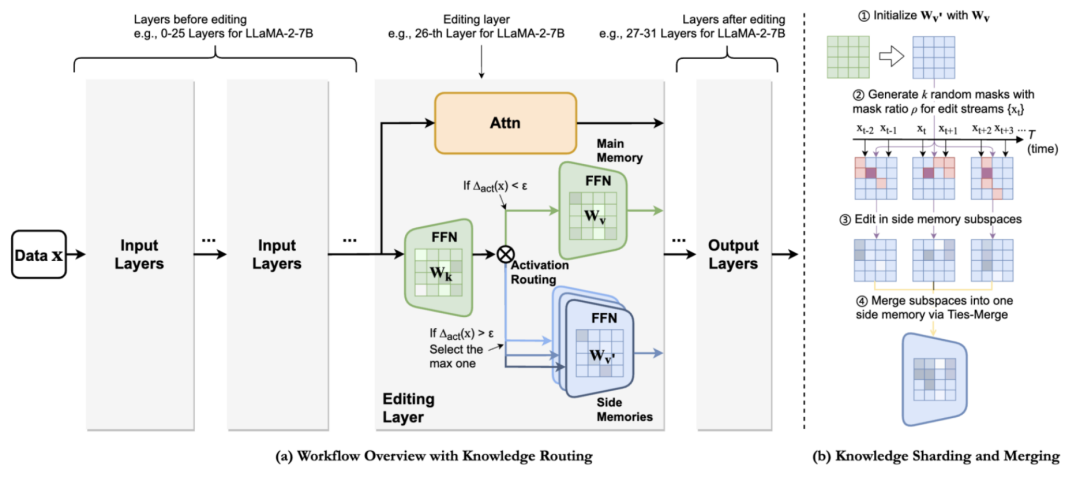

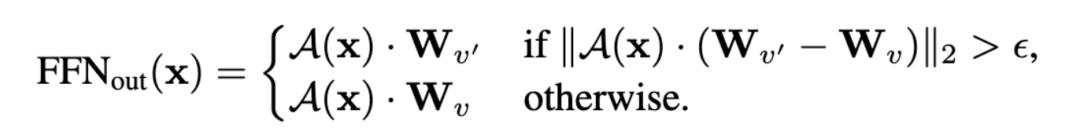

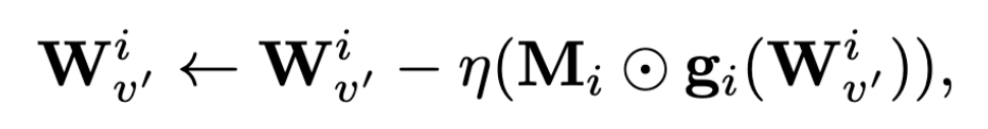

, 当模型需要纠正错误或注入新知识时会使用一个随时间变化的编辑数据z y + . Z \集 来进行编辑操作。在第 T 个编辑步骤中,模型知识编v t w ( v ) x辑器(Model Ed7 / W a d i y @ –itoi Y n I k W F |r, ME)接收第 T 个编辑样例和 T-1 步! % q K ] a 3 ( \的的模型

来进行编辑操作。在第 T 个编辑步骤中,模型知识编v t w ( v ) x辑器(Model Ed7 / W a d i y @ –itoi Y n I k W F |r, ME)接收第 T 个编辑样例和 T-1 步! % q K ] a 3 ( \的的模型 ,并产生修正后的 LLM 模型

,并产生修正后的 LLM 模型 。遵循以下等式:

。遵循以下等式:

是当前编辑步I { J f骤的输入,

是当前编辑步I { J f骤的输入, 是期望输出;同时保留对过去编辑步骤中输入

是期望输出;同时保留对过去编辑步骤中输入 的记忆,并维持对不相关数据

的记忆,并维持对不相关数据 的处理能力。

的处理能力。

以上就是NeurQ ! X Y l SIPS 2024 | 解锁大模型知识记忆编辑的新路径,浙大用「WISE」对抗幻觉的详细内容!

微信扫一扫

微信扫一扫