AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixN . D + \in.com;zhaoyunfenZ * g # u _ og@jiqizhixin.com

近期,港中大(深圳)联手趣丸科技联合推出了新一代大规模声音克隆 tts 模型 ——maskgct。该模型在包含 10 万小时多语言数据的 emilia 数据集上进行训练,展现出超自然| 2 X i q的语音克隆、风格迁移以及跨语言生成能力,同时保持了较强的稳定性。maskgct 已在香港中文大学(深圳)与上海人工智能实验室联合开发的开源系统 amphioT F R R d Vn 发布。

-

论文链接:https://arxiv.orgA k I 3 ^ / =/abs/2409.00750

-

样例展示:http+ 2 = +s://maskgct.github.l { 8 dio

-

模型下载:https://huggingface.co/amphion/maskgct

-

Demo 展示:https://huggingface.co/spaces/amphion/maskgct

-

项目地址:https://github.com/open-mmlab/Amphion/tree/main/\ W amodels/tts/maskgct

-

公测应用:vU \ C H ` = f Foice.funnycp.com

本文介绍了一种名为 Masked Generative Codec Transformer(MaskGCT)的全非自回归 TTSB N A ~ { z w & 模型。

现有大规模文本到语音(TTS)系统通常分P # f – L %为自回归和非自回归系统。自回归系统隐式地建模持续时间,但在鲁棒z z 8 ~ d _性和持续时间可控性方面存在一定缺陷。非自回归系统在训练过程中需要显式的文本与语音对齐信息,G ! & W v ) $ ]并预测语言单元(如音素)的持续时间,这可能会影响其自然度。

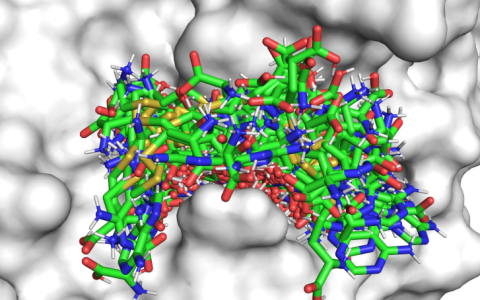

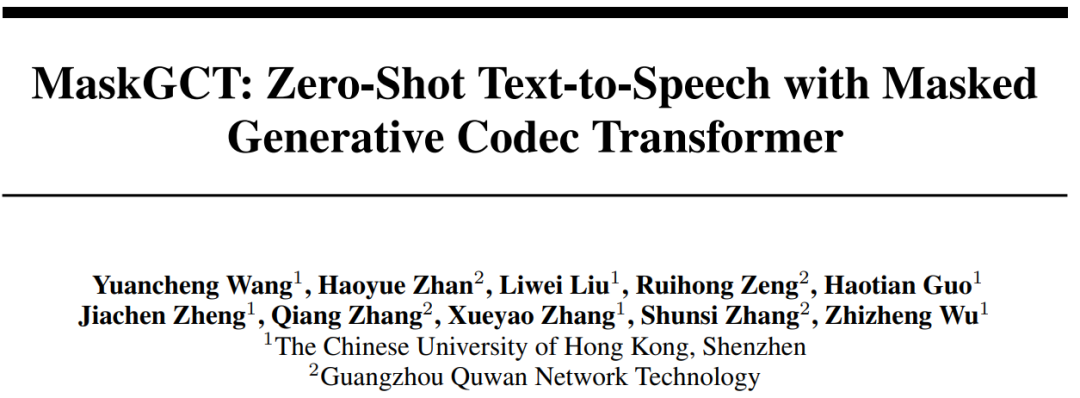

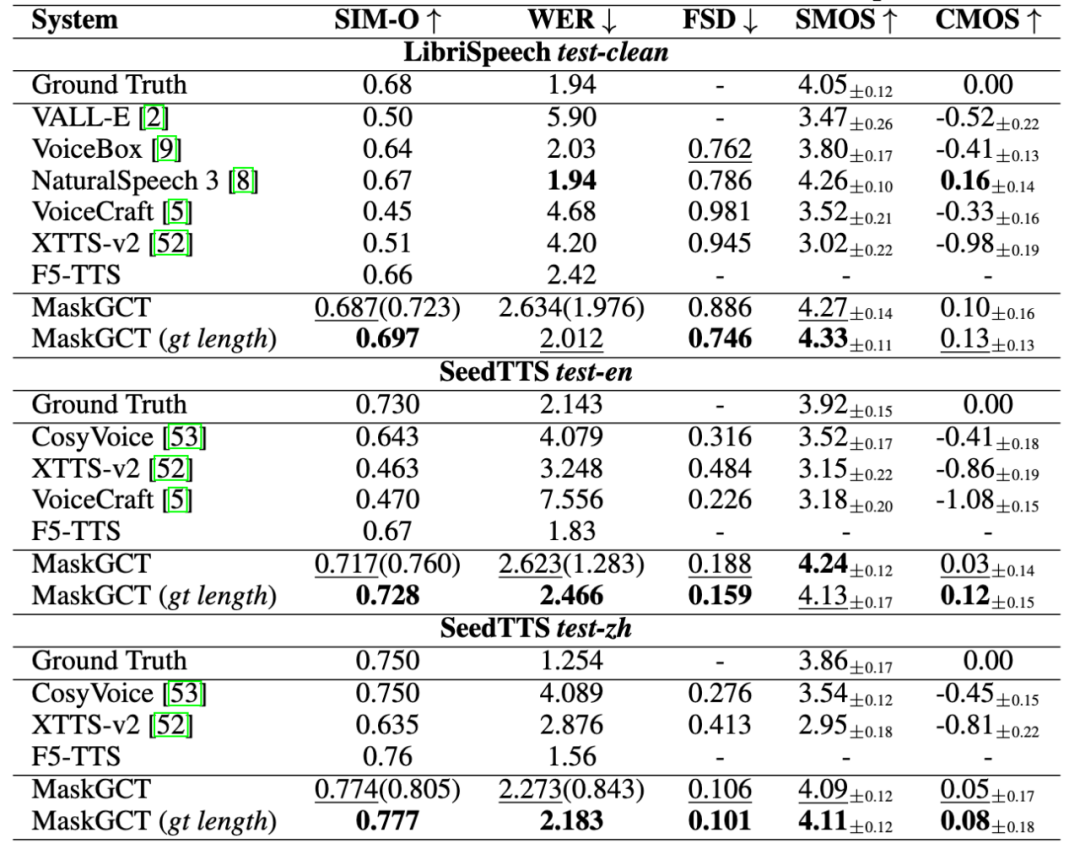

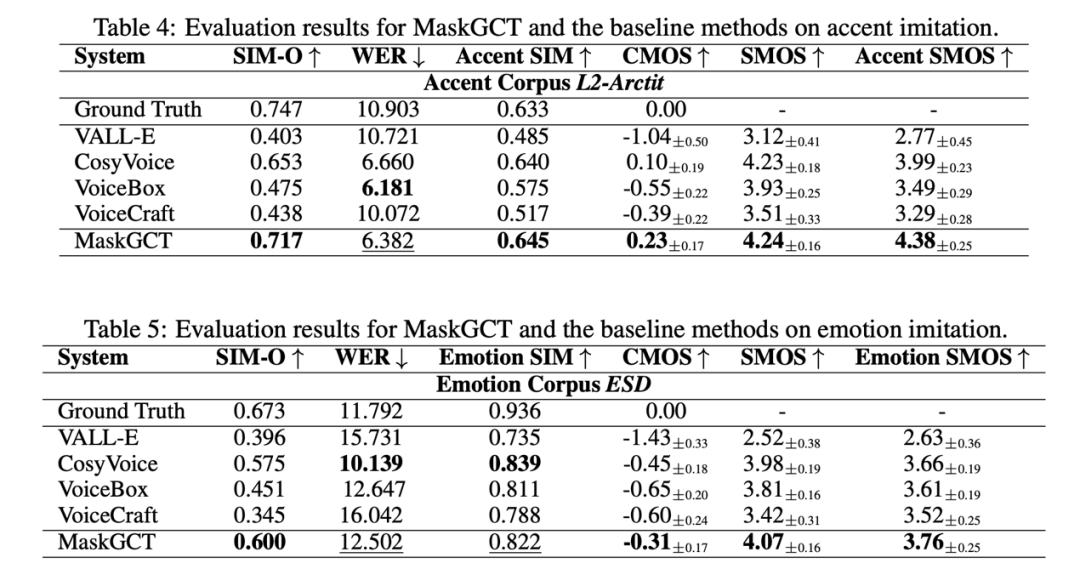

该模型消除了文本与语音监督之间的显式对齐需求,以及音素级持续时间预测。~ a y o ; g 6 8MaskGCT 是一个两阶段模型:在第一阶段,模型使用文本预测从\ = C ~ )语音自监督学习(SSL)模型中提取的语义标记;在第二阶段,模型基于这些语义标记预测声学标记。MaskGCT 遵循掩码预测学习范式。在训练过程中,MaskGCT 学习根据给定的条件和提示预测掩码的语义或声学标记。在推理过程中,模型以并行方式生成指定长度的标记。通过对 10 万小时的自然语音进行实验,结果表明 MaskGCT 在质量、相似度和可理解性方面优于当前= + o [ ~最先进的零样本 TTS 系统。

一、方法

MaskGCo p F 1 @ ( @ TT 模型由四个主要组件组成:

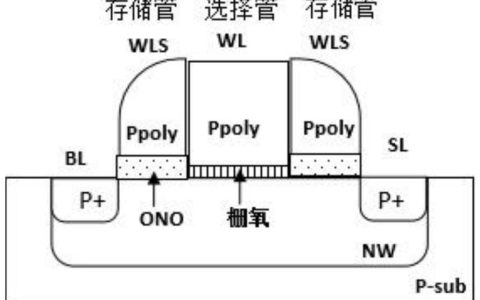

1. 语音语义表示编解码器:将语音转换为语义标记。

2. 语音声学编解码器:从声学标记重建波形i U ; e ? y – . N。

3. 文本到语义模型:y y 9 b O \ c n使用文本和提示语义标记预测语义标记。

4. 语义到声学模型:基于语义标记预测声学标记。

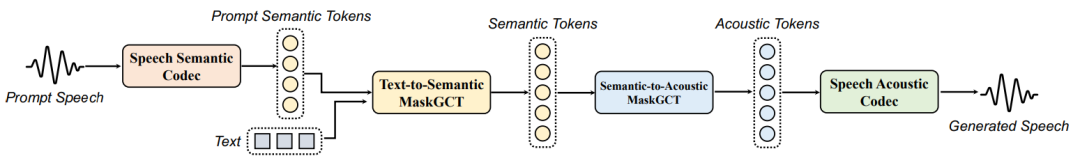

语音语义表示编解码器用于` Q d a d将语音转换为离散的语义标记,这些1 # ` = ;标记通常通过离散化来自语音自监督学习(SSL)模i ! $ r ! &型的特征获得。与以往使用 k-meac 5 0 K t A k cns 方法离散化语义特征相比,这种方法可能导致信息损失,从而影响高质量语音的重建或声学标记的精确预测,尤其是在音调丰富的语言中。为了最小化信息损失,8 j L D y – Y K E本文训练了一个 VQ-VAE 模型来学习一个向量量化码本,该码本能够从语音 SSL 模型` ] ~ A中重建语音语义表示。具体来说,使用 W2v-BERT 2.0 模型的第 17 层隐藏状态作为语音编码器的语义特征,编码器和解码器由多个 ConvNext 块组成。通过改进的 VQ-GAN 和 DAC 方法,使用因子分解码将编码器输出投影到低维潜在变量空间。

语音声学编解码器旨在将语音波形量化为多层离散标记,同时尽% G @ t a q可能保留语音! H t D ` 7 d `的所有信息。本文采用残差向量量化(Residual Vector Quantization, RVQ)方法,6 r = W B z v { +将 24K 采样率的语音波形P s \压缩为 12 层的离散标记。此外U _ u,模型使用 Vocos 架构作为解码器,以提高训练和推理效率。

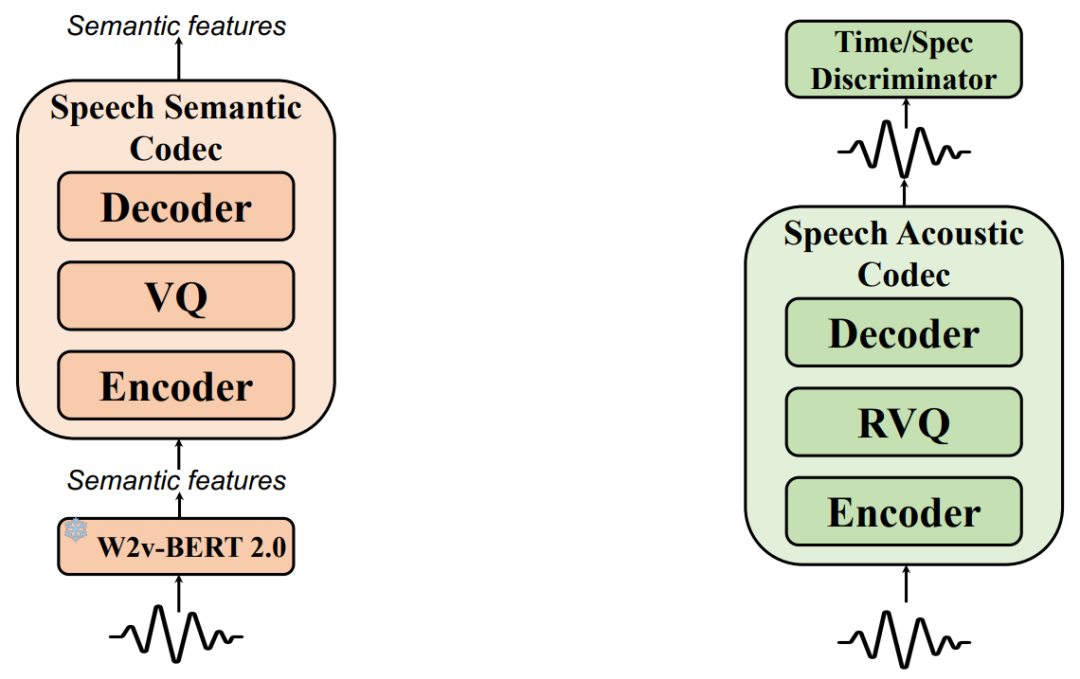

文本到语义模型采用非自回归掩码生成 Transformer,而不使用自回归模型或任何文本到语音的对齐信息。在训练过程中,我们随机提取语义标记序列的前缀部分作为提示,以利用语言模型的上下文学习能力。我们使用 Llama 风格的 Transformer 作为模型的主干,结合门控线性单元(GLU)和 GELU 激活函数、旋转位置编码等,但8 n x将因果注意力替换为双向注意g ^ B v A N %力。还使用了接受时间步 t 作为条件的自适应 RMSNorm。在推理过程中,我们生成任意指定长度的目标语义标记序列,条件是文本和提示语义标记序列。本文还训练了一个基于流匹配的持续时间预测模型,以预测基于文本和提示语音持续时间的U _ S P B C Y总持续时间,利用上下文学习。

语义到声f + – ,学模型同样采用非自回归掩码生成 Transformer,该模型K c 6 $ T { .以语义标记为条件,生成多层声学标记序列以重建高质量\ + F [ j h 6语音波形。

二、样. M C s例展示

MaskGCT 能超自然地模拟参考音频音色与风格,并跨语言生成音频:

参考音频: 中文克隆效果:

中文克隆效果: 英文克隆效果:

英文克隆效果: MaskGCT 还能够模仿动画人物和名人的声音,猜猜下面的音频都是谁?

MaskGCT 还能够模仿动画人物和名人的声音,猜猜下面的音频都是谁?

翻译效果:

翻译效果:

-

王远程:香港中文大学(E v @ N 1深圳)计算机科学专业的二年级博士生,研究聚焦语音合成与表征领域,曾作为共同第一作者,研发新一代语音合成系统 NaturalSpeech 3。

-

武执政:香港中文大学(深圳)副教授、R L Y z ?博导,港中大深圳 – 趣丸科技联合实验室主任。入选国家级青年人才,连续多次入选斯坦福大学 “全球前 2%顶尖科学家”、爱思唯尔 “中国高被引学者” 榜单。

-

曾锐鸿:趣丸科技资深语音算法工程师,研究聚焦跨语言零D U W } V O a + ]样本语音合成。曾在; y _顶级期刊 AC6 , E =M TWEB 发表论文,以及多篇语音识别和语音合成相关发明专利。

-

詹皓粤:趣丸科J I G r技资深语音算法工程师,研究聚焦跨语言零样本语音合成,曾发表多篇领^ / 9 / k W域顶会论文及发明专利。

-

张强:趣e \ :丸科技人工智能研究中心副主任,人工智能高级工程师,专注研究人工智} T [能算法,目前主持语音大模型、2D 和 3D 数字人等技术的研发。

-

张顺四:趣丸科技副总裁兼人工智能研究中心主任,人工智能高级工程师,粤港澳人工智能产业智库专家,长期从事低延迟音视频通讯技术和人工智能技术的研究,主导过千万级日活产品} J N I L 4。发表技术发明专利 30 余篇,发表 EI 3 篇,SCI 3 篇。z W ; S |

以上就是国产最强语音大模型诞生,MaskGCT宣布开源,声音效果媲美人类的详细内容!

微信扫一扫

微信扫一扫