AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享) @ l s –,欢迎投稿或者联系报道。投稿邮箱:D ; Iliyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

论文链接:https://arxiv.org/pdf/2410.23168

-

开源模型:https:% j / # P//huggingface.co/Haiyang-W

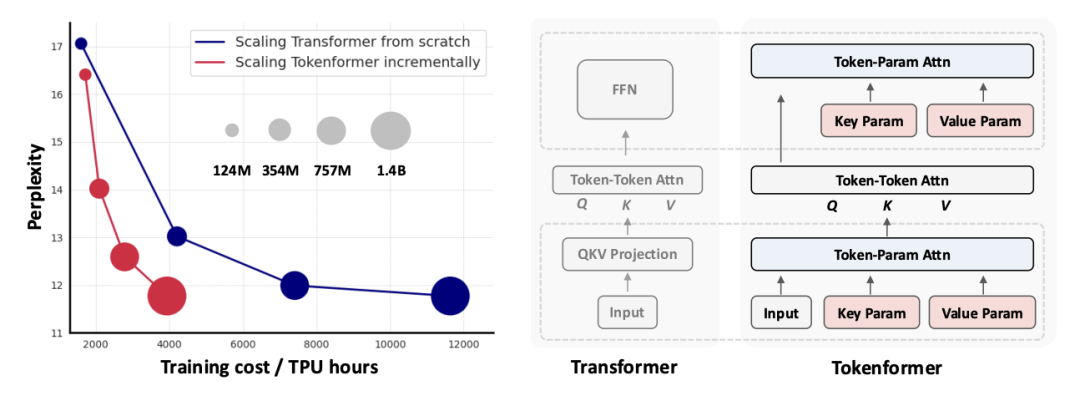

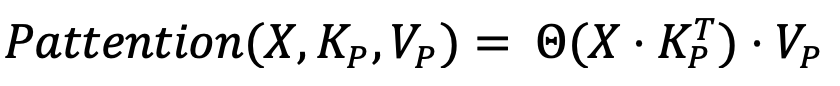

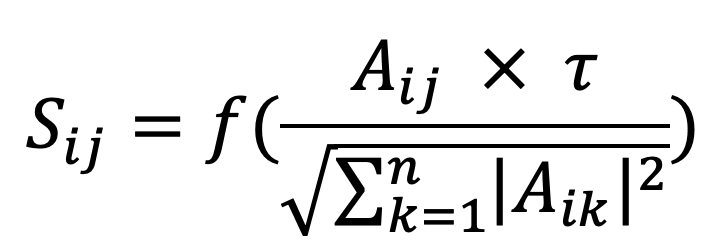

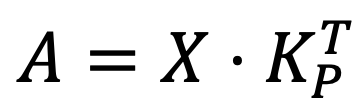

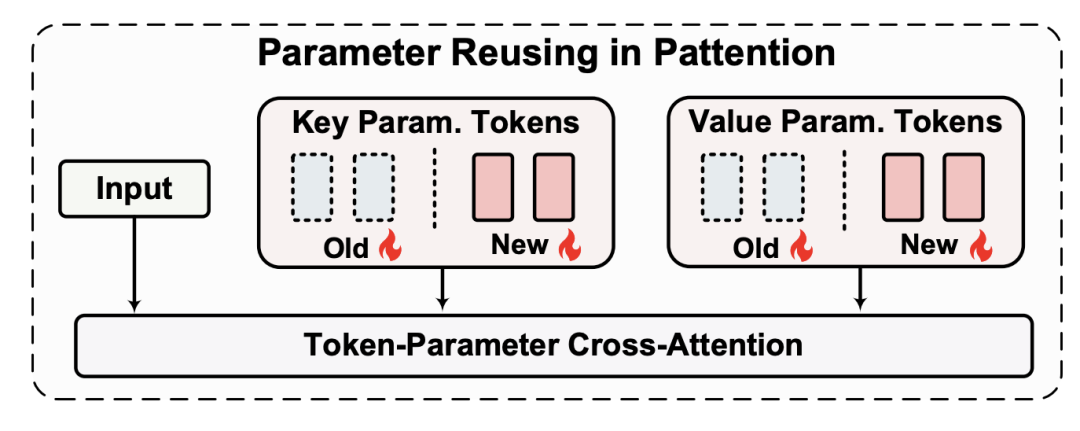

代表 key,

代表 key,  表示 valuh C o X J q ae。输出如下:

表示 valuh C o X J q ae。输出如下:

。

。

和

和 。

。 和

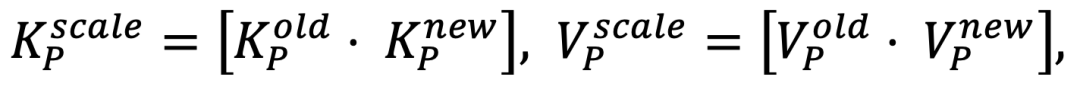

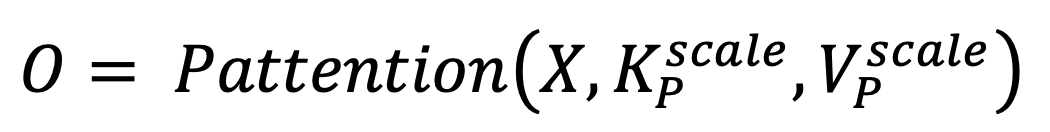

和 ,进而组合成新的 key-value set,

,进而组合成新的 key-value set,

以上就是Token化一切,甚至网络!北大&1 ! #amp;谷歌&马普所提出TokenFormer,Transformer从来没有这么灵活过!的详细内容!

微信扫一扫

微信扫一扫