AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhi5 N |xin.com;zhaoyunfeng+ p G P@jiqizhixin.com

-

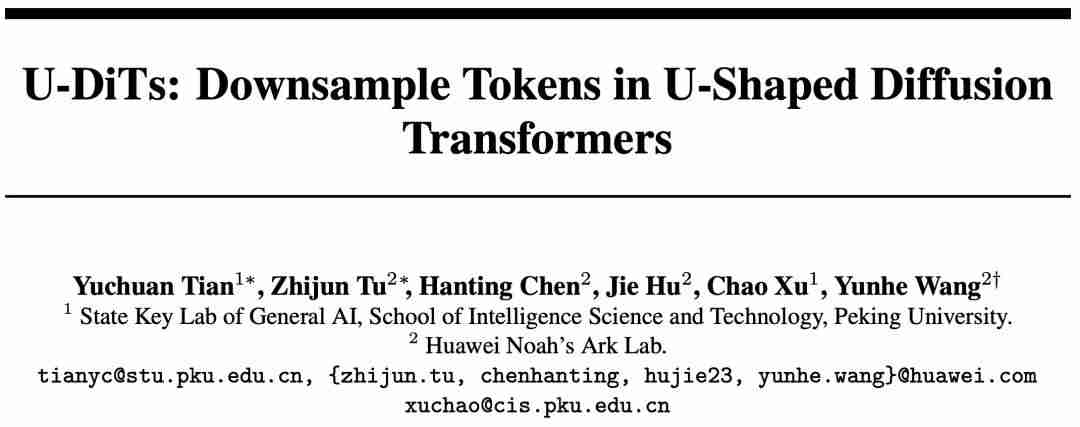

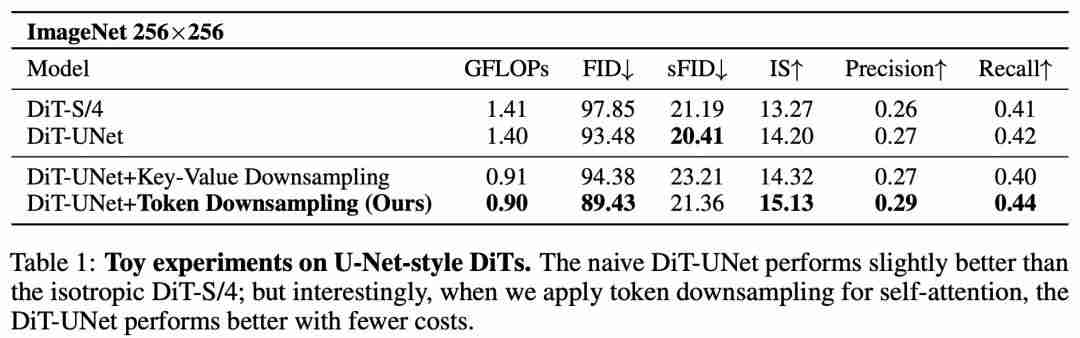

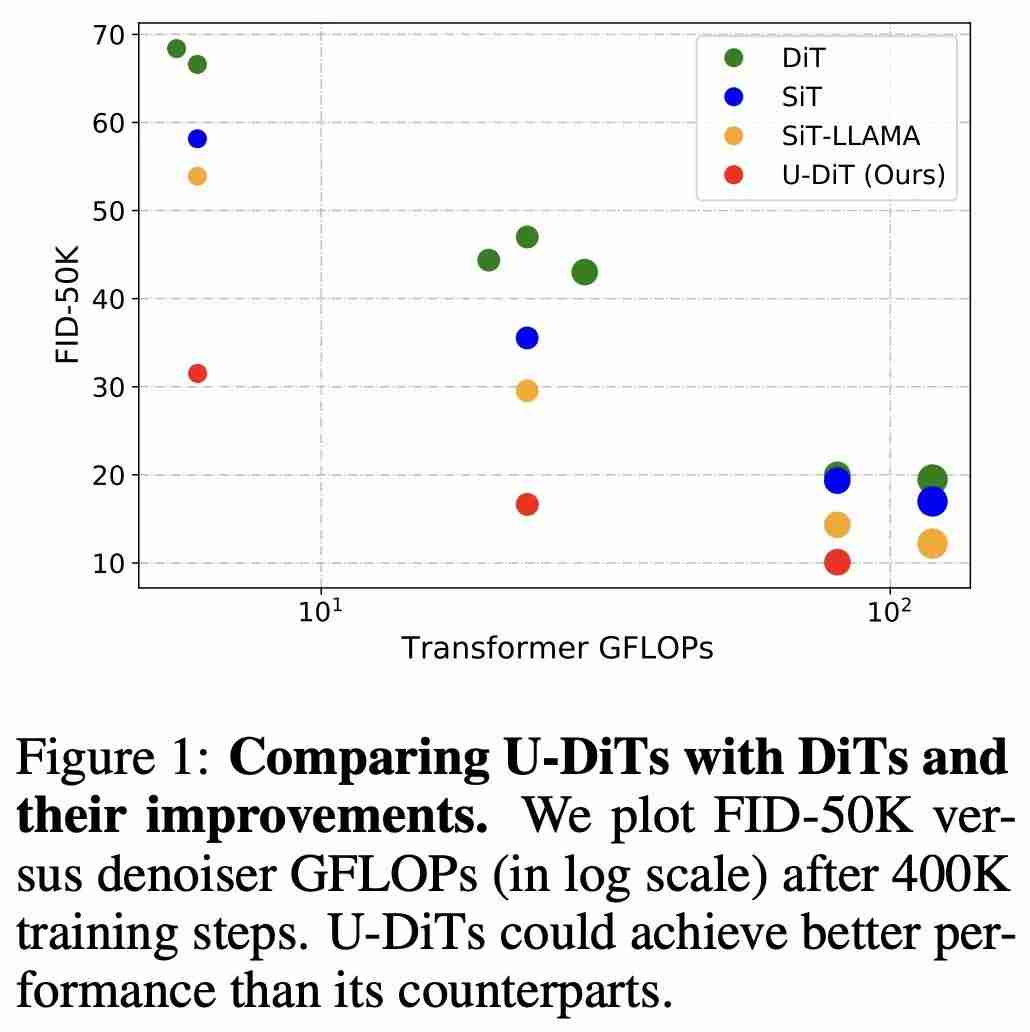

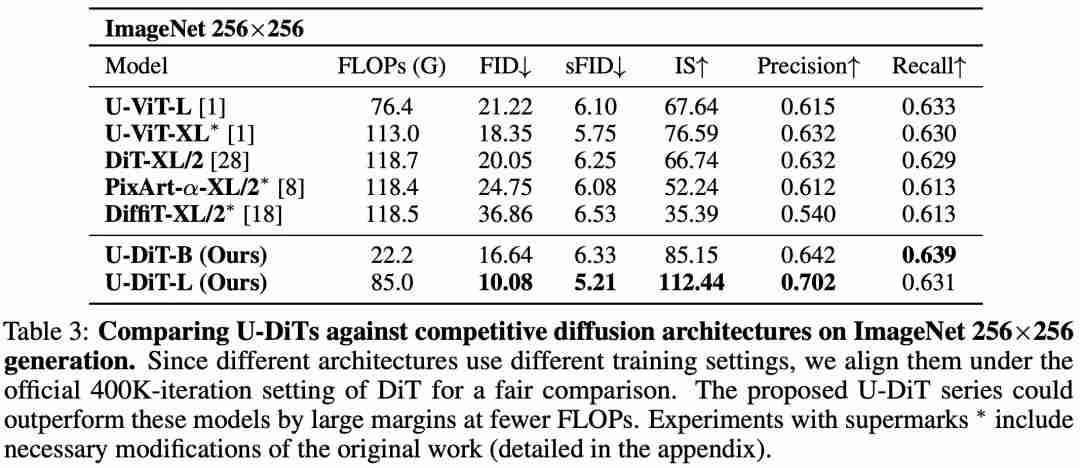

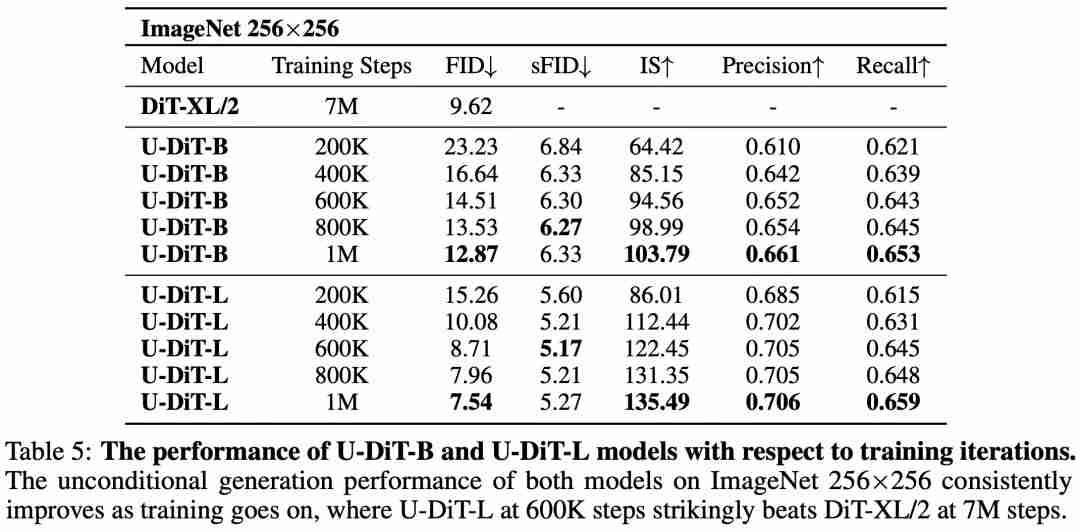

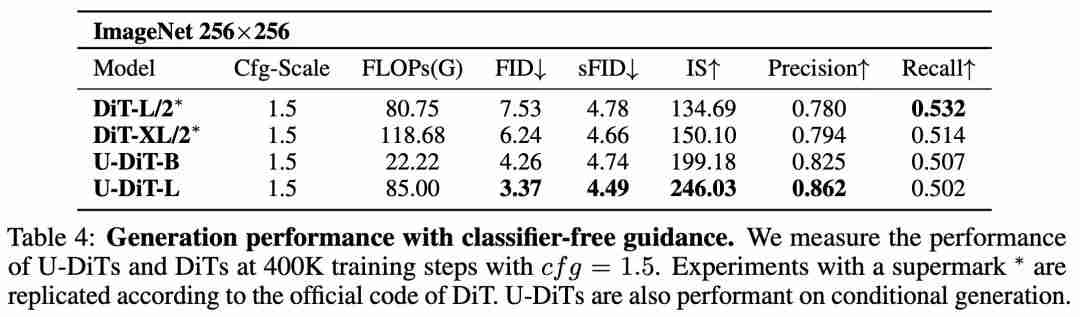

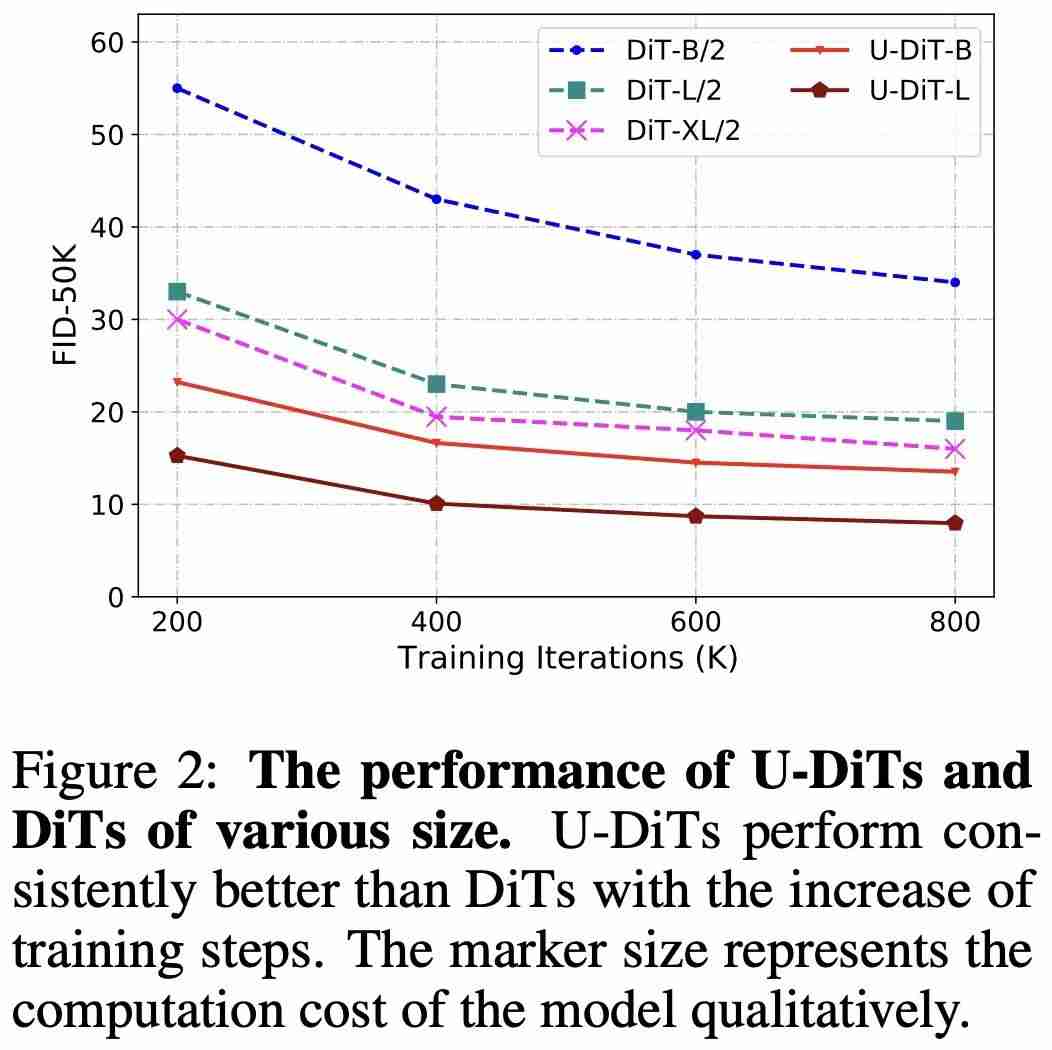

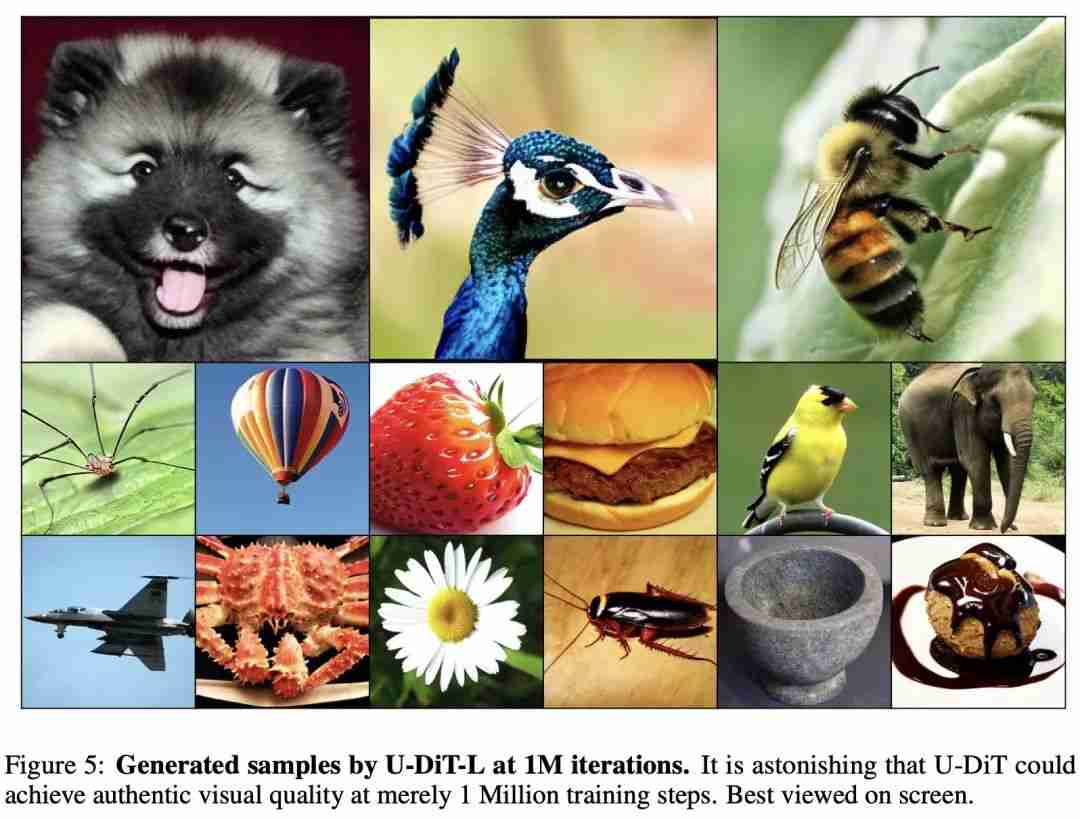

论文: m 6 – Z + 0标题:u-dits: downsample tokens in u-shaped diffusion tranE : B W U } ` vsformers

-

论文地址:https5 l $ F z T G://arxiv.org/pdf/2405.02730

-

GitHub 地址:https://github.com/YuchuanX 5 d &Tian/U-DiT

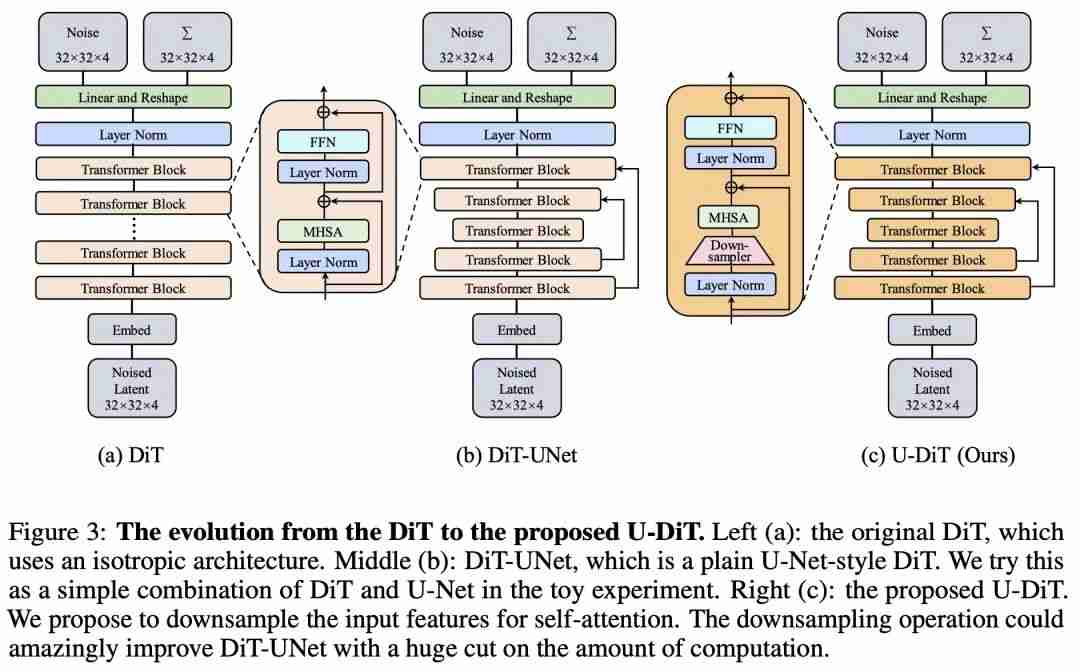

以上就是Make U-Nets Great Again!北大&华为提出扩散架构U-DiT,六分之一算力即可超越DiT的详细内容!

微信扫一扫

微信扫一扫