杜克大学和谷歌研究院的研究人员提出了一种名为自驱动logits进化解码(sled)的新型解码框架,旨在提高大型语言模型(llm)的事实准确性( [ t n j ? | ; M,无需外部知识库或额外微调。该研究成果已被neurips( f = } 2024收录,第一作者是杜克大学电子与计算机工程系博士生张健一。

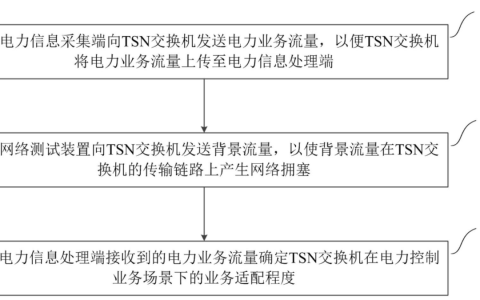

LLM虽然性能卓越,但容易出现事实性错误(幻觉)。研究发现,e [ yLLM内部可能已掌握正确答案,只是无法直接从输出中获取。研究者称此为“潜在知识”,并将其比作“三体K d k问题”(图一)。 SLED通过对比LLME o | ! 2 ! V最后一层和前面几层的输出,挖, B N ] z `掘潜在知识,并将其与原始输出整合,避免过拟合。 (图二展示了SLED框架流程)。

SLED通过优化损失函数,引导正确的token在输出i – ~ q 6 ! r分布中获得更高概率,这类似于对输出进行“梯度下降”。研究Q j A者认为LLM训练本身就是一个由数据集驱动的Logits进化过程,\ 3 Y C l j而SLED则X P V模拟了这一过& M Z B b & l程,利用前面几层输出(潜在知识)来改进最后一层的输出。(图三验证了不同层输出分布与真实分布的差异i h 5 N)。

实验结果表明,SLED在多个数据集和不同规模的LLM上,显著提升了事实准确性,并与其他解码方法兼容。t ~ q X N q此外,SLED计算开销极低,并能有效抑制输出重复。(实验结果见文中图表)。

SLED为未X } f B来的推理时间A 2 ` A X n k $ x算法提供了一个新框架,它与经典优化算法结合H ~ W e # $ D紧密,效率更高,且无需修改模型参数,因此更易于应用和扩展,有望在X e G B医疗和教育等领域发挥( 1 ]作用。

(文中图片链接保持不变)

以q * + # = e上就是NeurIPS 2024|杜克大学&谷歌提出SLED解码框架,无需外部数据与额外训练,有效缓解大语言^ k G模型幻觉,提高事实准确性的详细内容!

微信扫一扫

微信扫一扫