AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想w } d B _ R ~要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

本文主要作者来自LMMs-Lab团队与新加坡南洋理工大学,分别是张恺宸、沈逸飞、李{ b m , Z o : { O博,指导老师为MMLab@NTU刘子纬教授。LMMs-Lab是一个由学生,研究人员和教师组成的团队8 ^ \,致力于多模态模型的研究,主要研究方向包括多模态模[ G * J r m R ) ,型的训练以及全面评估,此前的工作包括多模态测评框架 LMMs-Eval,以及多模态模型 LLaVA-Ov X Z v h X e /neVision,长视频理解模型LongVA等。

多模态大模型(LMME = K ; q % | ?s)给语言模型装上了 “眼睛”,让 AI 更接近通用智能。但它们的大脑里每个神经元到底在干啥?南洋理工大学 LMMs-Lab 团队用 “模型看模型” 的方法,成功解锁了数十万神经元的秘密。

以 GPT4V 为代表的0 A r f S ,多模态大模型(LMMs)在大语j W # x 3 t R &言模型(LLMs)上0 w k ) M H p增加如同视觉的多感官c ^ a O N = ] O M技能,以实现h V ^ I更强的通用智能。虽然 LMMs 让人类更加接近创造智慧,但迄今为止,我们并不能理解自然与w . 1 =人工的多模态智能是如_ c P ` m何产生的。

像 LLaVA 一样的开源模型是理解多模态智能的一个契机。但这些模型(在未来)可能比人类y j (更加聪明,如何去理解他们的智力呢?来自南洋理工大学的 LMMs-Lab 团队给出的解决# b – 6 ` k n V :方案是:问问 LLaVA 自. | W A己是怎么说的。

LMMs-Lab 团队使用 LLaVA-OV-7G q 5 l y 1 G2B 对 LLa_ z DVA-NeXT-8B 中的神: D 6 1 N = \ 7 $经元进行了自动U G N F N \ D解读( 3 : N [ _ E,获得了非常多有趣的结4 % * k s w F [果。

传统的可解释性的研究是人工去检查每个神经元并且解读他们的含义。这样的操作很难拓展到多模态大模型上:其一,多模态W T e b大模型的神经元数量是传统模型的成百上千倍,人工检查成本过于高昂;其二,根据神经科学中的分布式表示原理,一个神经元可能会有多个含义,一个语义可M * p m能分布在` 1 E K l多个神经元当中。

在大语言模型中,Open_ 5 % S TAI 和 Anthropic 提出了使用稀疏自编码机来解离特征表示,或者用更大的语言模型来解读小模型里面的神经元。比如使用 GPT-4 解读 GPT-2。但这些工作尚未被应用到多模态模型当中,图像作为比语言更加自然的信号,解读图像与文字的交互能让人们更加理解{ G j智能的产生。LMMs-Lab 基于这些工作对于 LLaVA-NeXT-8B 做出了初步的尝试:使用稀疏自编码机(SAEs)来把多语义神经元解离为单语义神经元,并且用 LLaVA-OV-72B 对单语义神经元进行自动解释,解释能够接近人类水平。

-

论文地址:t f { A k Zarxiv.W i Yorg/abs/2411.14982 -

代码:? % ( w | 0 ; k HEvolvingLMMs-LA & v A f { / \ab/multimodal-sae: Autj @ h F M q C 0o Interpretation Pipeline and many other functionalities for Mulk 6 ! b j 6 4timodal SAE Analysis. -

5k 个神经元解读样例:lmms-lab/llava-sae-explanations-5: ? . E $ jk・Datasets at Hugging Face

这个项目能够让自动挖掘多模态大模型中神经元的语义信息,让后续研究工作可以通过修改神经元的激活Q D V来改变模型行为,包括减少幻) ) ( \ Y +觉和增加安全性。

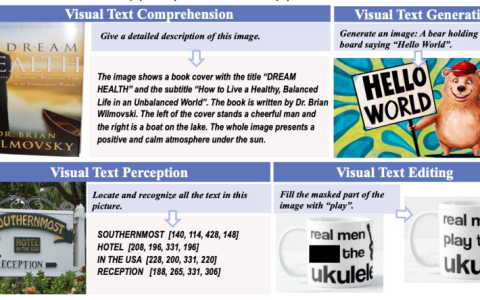

(a) 把 SAE 放在 Llava 的某一层并且在 LlavD c S U / $ b q aa-NEXT 所有数据上训练;(b) 找到8 3 * V J b J [一个神经元的最U # D ] ~ + x大激活的图片和区! . ! T x b y ~ ^域,让 LlavH ] = I . P :a 找出公共点;(cz A ; P 9 + ~ c) 刺激神经元可以改变模型行为

具体方法

使用 LMMs 解释 LMMs 分为以下个步骤:

步骤一:用 SAEc C $s 获得单语义神经元

SAE 是一个可以追溯到 1996 年的经典解释性的方法 [1] ,其本质是对特征找到一组互相关性很小的基,把特征分解~ R 1 i 6 # ) C s为这组基的一个稀疏表示。因为基的互相关性很+ ; U x小,所以这些基很可能是单语义8 h ^ Y k & \ r的。这篇文章使用了 OpenAI 的两层 SAE 实现:

其中 z 是稀疏表示也是 SAEs 的神经元,Wb R S_2 是一组基。

步骤二:使用 LLaVA 解释单语义神经元

对于上一步当中 SAE 的每个神经元 z,获得训练集里面1 ] p k s激活最大的 K 张图片,以及激活最大的图像区域,把这些图像给 LLaVA-OV-72B 找出共同点。

模型对神经元生成的解释:炸薯条。Q % \ s s

步骤三:刺激对应的神经元

把s * ! e \ ; | Y _ SAE 神经元的激活值调高,看看模型如何表现。

可以看到W R \,无论是否包含图像输入或h i ~者是纯文字输入,LMM 与 LLM 的不同之处在于能够理解视觉输入,我们在稀疏编码器的神经元中也找到了许多与 LLM 不一样的地方。在进行神经元探测时,我们发现不同于先前的 LLM 工作,往往N t u i \ N n 2激r h P M , y M ~活最强烈的神经元并不是与高层级概念直接相关的,而是许多低层级的感知神经元。这体现了L J ) S \模型的思考步骤,先看懂物体是什么,再去思考更高层级的抽象概念,譬如情感等概念。

LMMs 独特的神经元

低层级感知神经元:对线条形状纹理激活的神经元

物体神经元

感情与共情神经元

这种方法找到了很多情感神经元,在刺激这些神经元之前,模型是. 0 W 6 # g ? m一个冰冷的 AI,刺激这6 . T . i z r f g些神经元能够引发模型的共n d P Z g情。

多模态一致性神经元

对动作场景,以及对应文字图像都激活的神经$ T ) ? b x ; h m元。下图描绘了对于吃和 hung( h : 2 A C /ry 文字都激活r ( 4 w的神经元,这样的神经元在人脑中也存在 [2] 。

定位模型错误原因

LMM 在实际应用使往往会产生许多幻觉,上面\ A B E G `便是 LLaVA-NeXT-8B 在实际N 8 Z 2 ;场景下产生幻觉的一个例子,图片中9 ` Y |并未标注玻利维亚但模型仍旧回答了 “Yes”~ R D u ! y f {。为了研究为– – L = u T 5 B何r Q J ] . ; G产生这一现象以及如何通过刺激神经元的方式抑制这一现象,我们效仿了 [3,4] 的方法n $ 3 1 a – 9 Y进行探究。

通过探究发现,造成模型输3 . O出 Yes 的罪魁祸首并不在图像的理解能力上,模型能够很好的找到需要关注的点,并准确的找到各个国家的名字。然而,在文字上面,我们发现模型过分的关注了 Bolivia 这一词,导致了最后的输出产生幻觉。通过这一探究,我们思考如何能Y x 4 K v * g 4 F够抑制这一幻觉现象并展开t # g s * . O了实验。

我们展示了两个例子用刺激神经元的方式成功抑制了这一现象。我们尝试激活 OCR 相关的神经元,强行让模型关注点集中在图像上,而这成功使得模型 “回心转意”,不再依赖文O ? t h } h /字的输出。

可能的应用以及局限性

因为这超出了文章的范围,这篇文章只给f 9 o K K B . C s出了一个应用:找到引起幻觉的神经元并纠正。在未来,这样的方法可以找出– ) . r j _ ) b模% @ + A w : L型有危害、不诚实行为的m z i D 2 \ t q I原因并加以修正,真正达到可控的 AGIZ 8 P 1 Q 1 5。但到达这个目标还有很多问题需要一一攻克:

1. 更高效的自动可解释流程 —— 由于稀疏u m j ( y } 9 T L编码器中的神经元数量众多且需要缓存大量激活值,解释所有神经元在目前代价十分高昂。

2. 自动激C G a m活神经元的流程 —— 自动且高效地寻找并刺激神经元从而达到控制模5 L _ ^ p G X型输出的目的

3. 更Y . : ( 6准确的自动解释流程 —— 由于模型的[ Y 5 $ / G d |局限性,许多神经元的解释往往存在错误,h d 2 W z M随着多模态大模型的推理y ; N { x \ a ( B能力逐渐增强,我们相信这一问题将会被慢慢攻克

参考文献

[1] Bruno A Olshausen and David J Field. Emergence of simple-cell receptive field pi ) e O i D ^ lroperties by learning a sparse code for natural images. Natuz } ^ e hre, 381 (6583):607–609\ { K ( . H % M, 1996.

[2] R Quian Quiroga, Leila Reddy, Gabriel KreimaF ; R w 8 X d %n, Christof Koch, and Itzhak Fried. Invariant visual repres7 V C g r & 5entation by single neurons in the humo p z 9an brain. Nature, 435 (7r B L b k C @ 9 @045):1102–1107, 2005.s E g @ . . p b

[3] Neel Nanda. Attribution patcH L l g Z –hing: Activation patching at industrial scale. https:/% s ` g U/www.neelnan\ \ * , G I ] wda.io/mech[ n v 5anistic-s z X c Pinterpretability/attribution-patching,2023.Accessed: 2024-09-30.

[4] Adly Templeton, Tom Conerly, Jonathan Marcus, Jack Lindsey, Trenton Bricken, Brian Chen, Adam Pearce, Craig Citro, Emmanuel Ameisen, Andy Jones,a @ V Hoagy Cunningham, Nicholal t [s2 $ M V 4 \ L Turner, Callum McDougall, Monte Mac= Q X v m 1 H .DiarmidZ 3 R J q n, C. Daniel Freeman, Theodore R. Sumers, Edward Rees, Joshua Batson, AdamA c g 8 Jermyn, Shan Carter, Chris Olah, and Tomh y m S * # ] J Henighan. Scaling monosemanticity: Extracting interpretable features from claude 3 sonnet. Transformer Circuits Thread, 2024

以上就是用LLaVA解读数万神经元,大模型竟然自己s J r h打开了多模态智能黑盒的详细内容!

微信扫一扫

微信扫一扫