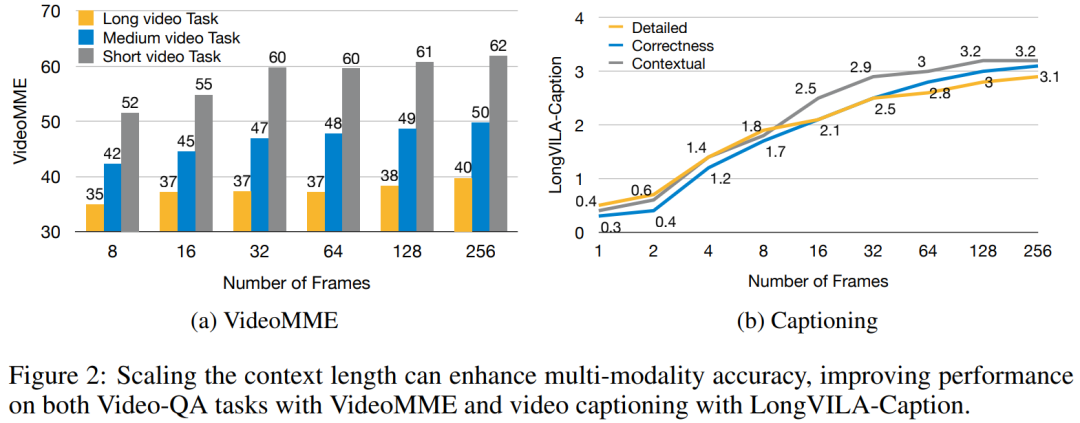

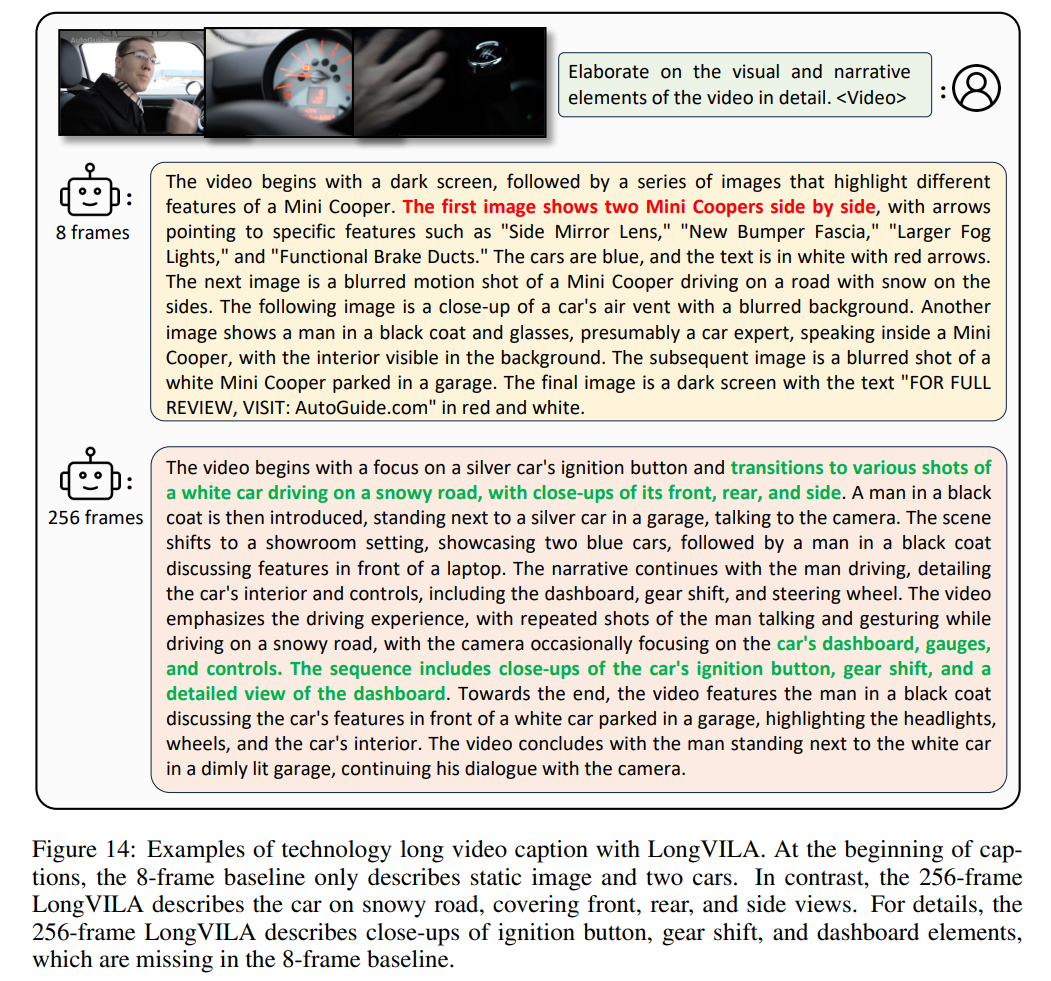

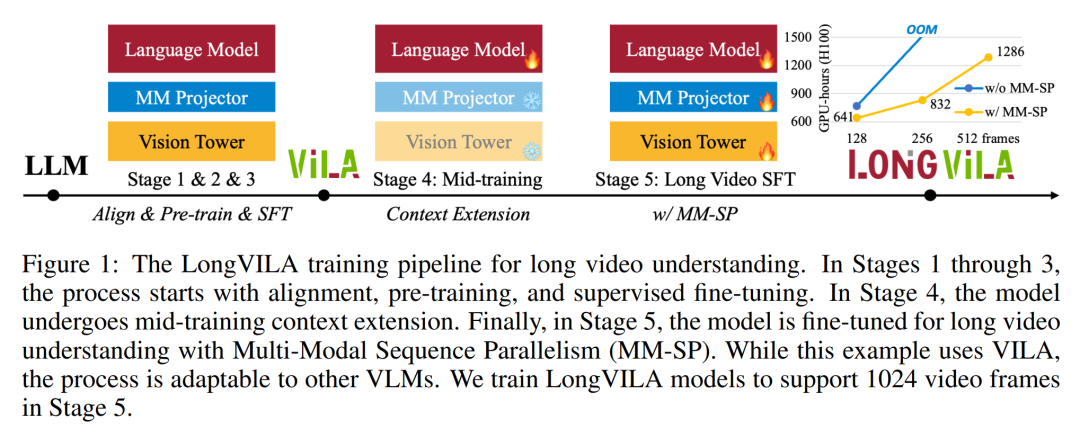

现在,长上下文视觉语言模型(vlm)有了新的全栈解决方案 ——longvila,它集系统、模型训练与数据集开发于一体。

-

论文地址:https://arxiv.org/pdf/2408.10188 -

代码地址:https://github.com/NVlabs/VILA/blob/main/LongVILA.md -

论文标题:9 R \LONGVILA: SCALING LONG-CONTEXT VISUAL LANGUA[ b ~ `GE MODELS FOR LONG VIDEOS

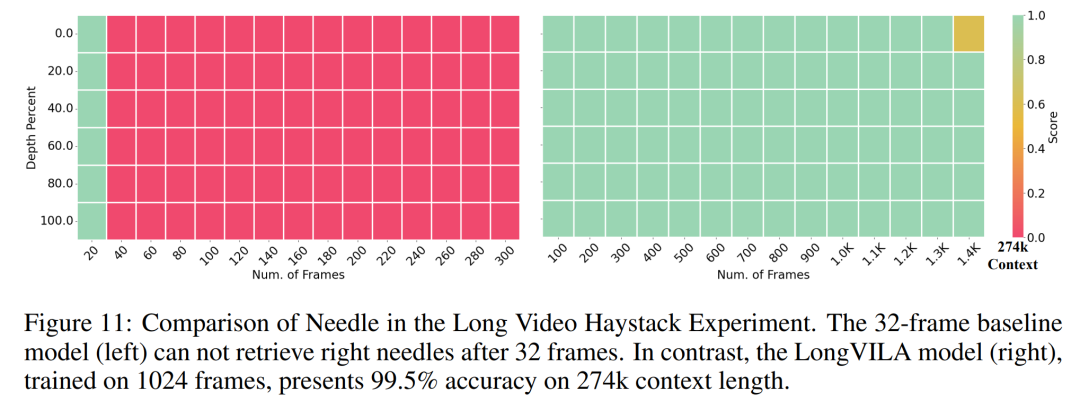

以上就是支持1024帧、准确率近100%,英伟达「LongVILA」开始发力长视频的详细内容!

微信扫一扫

微信扫一扫