柔和

柔和 高昂

高昂

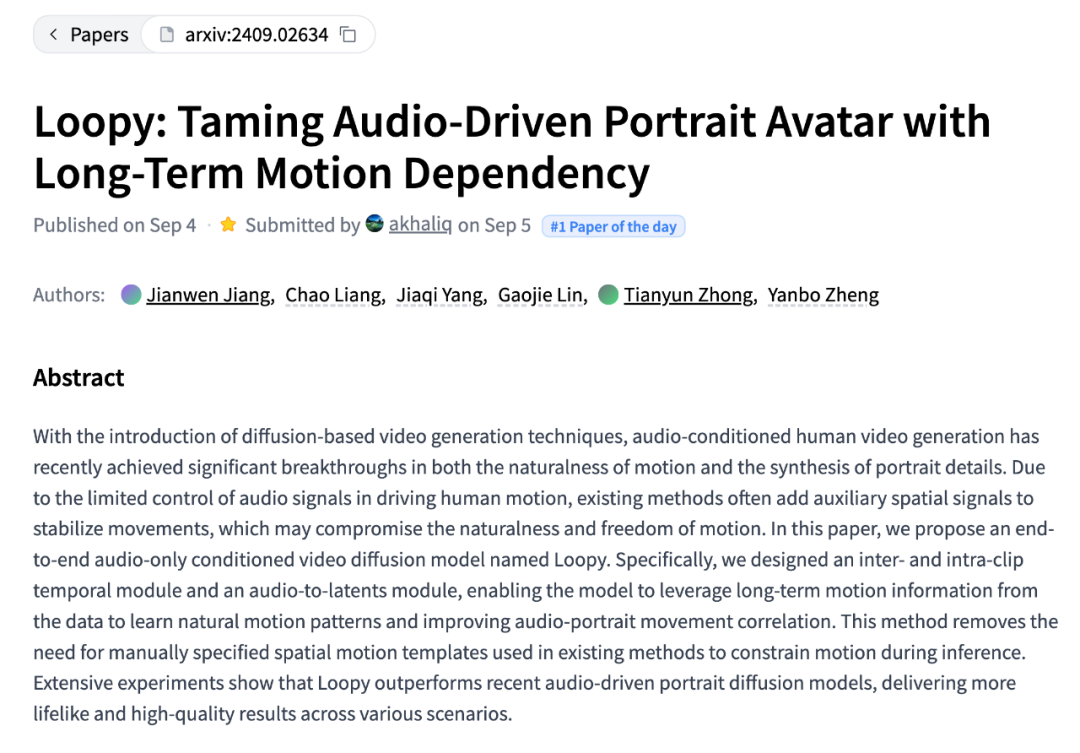

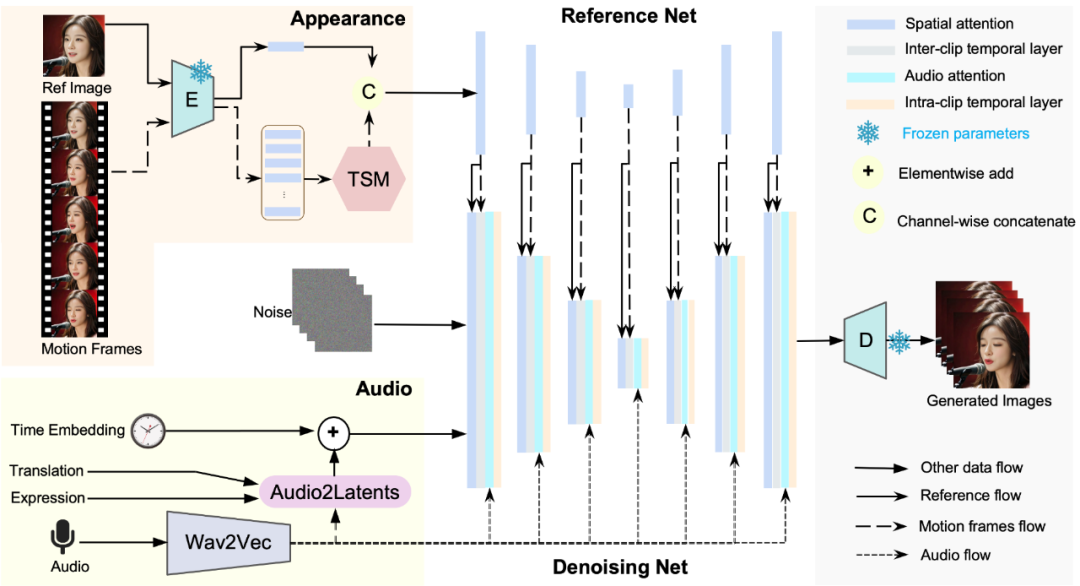

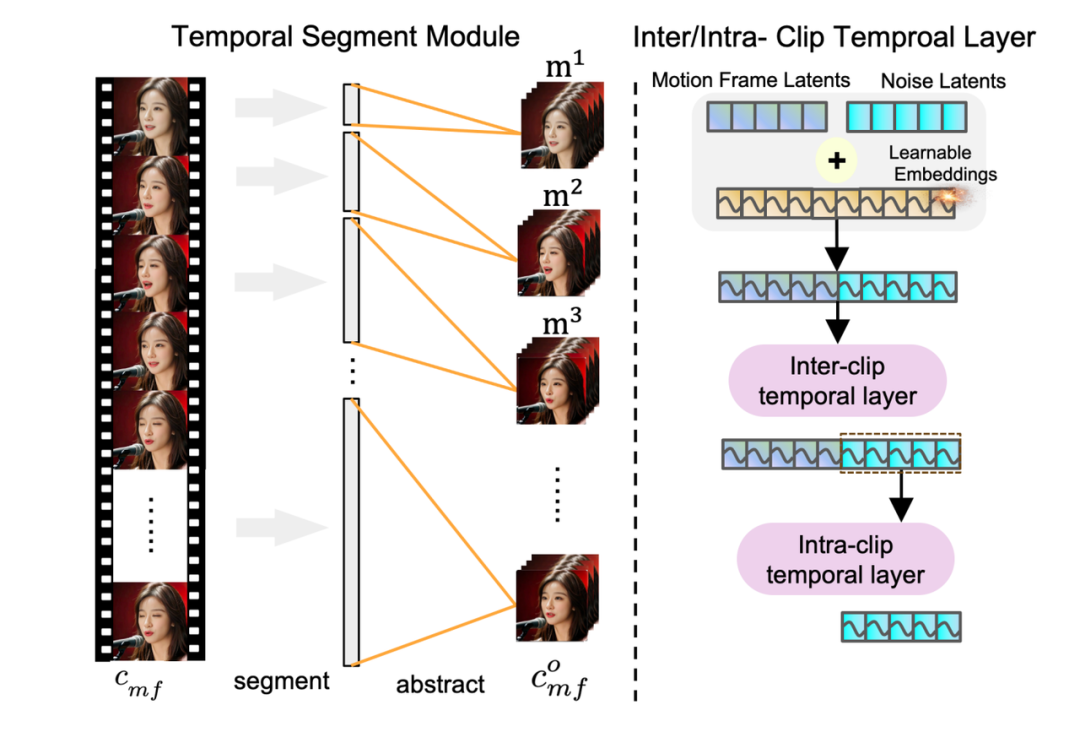

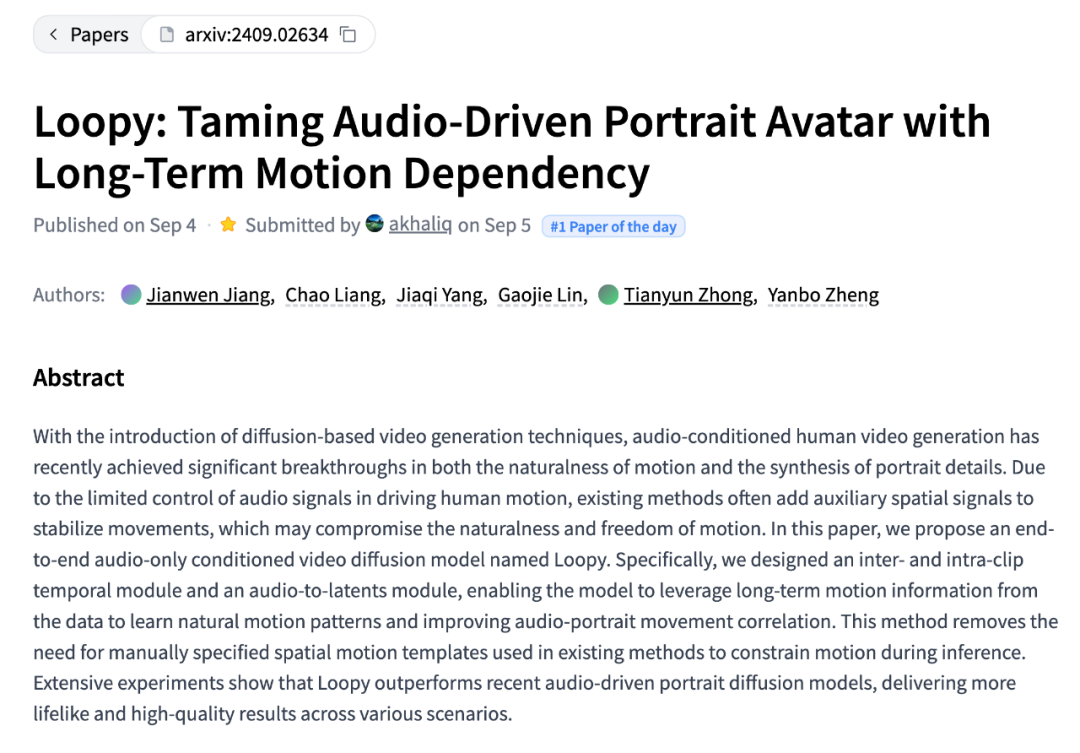

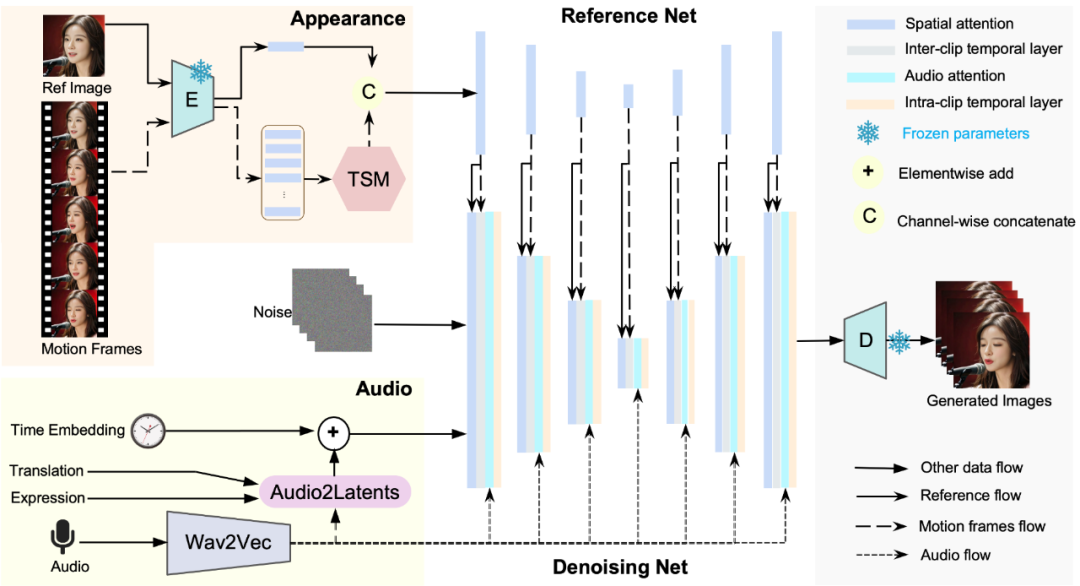

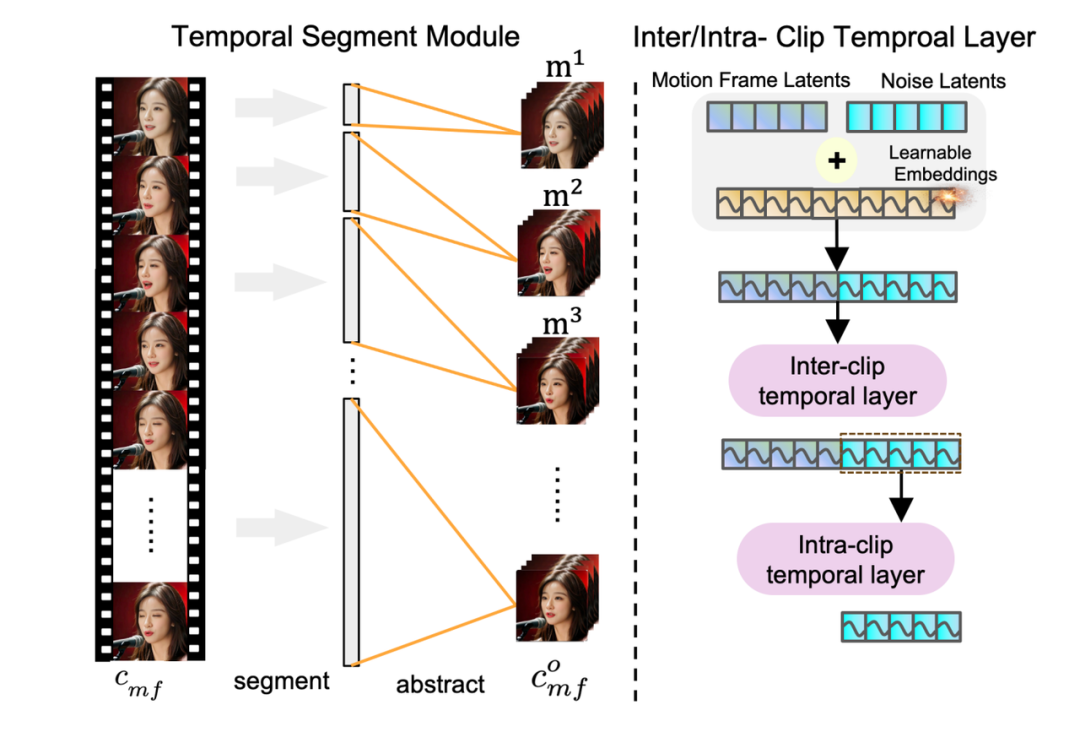

以上就是音频驱动人像视频模型:字节Loopy、CyberHosM \ i `t研究成果揭秘的详细内容!

柔和

柔和 高昂

高昂

以上就是音频驱动人像视频模型:字节Loopy、CyberHosM \ i `t研究成果揭秘的详细内容!

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫