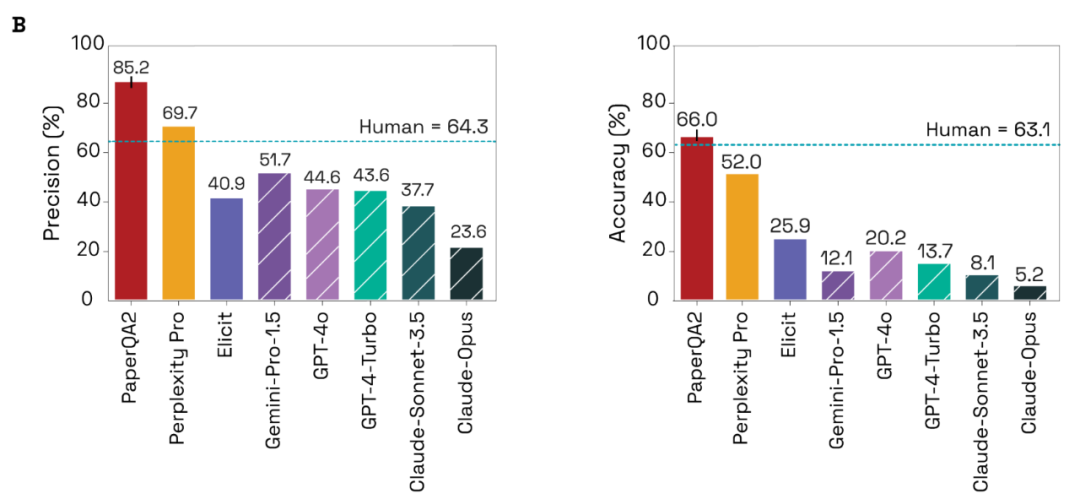

这是 AI 智能体在大部分科学研究中超越人类的第一个案例,或许会彻底改变人类与科学文献互动的方式。

-

论文地址:https://storage.L ) + W EgoogleapiN 1 ) 8 l %s.com/fh-; 0 ^ V k r Ppublic/paperqa/Language_Agents_Science.pdf -

GitHub 链接:https://githuw * Z E w M Xb.com/Future-House/paper-qa

-

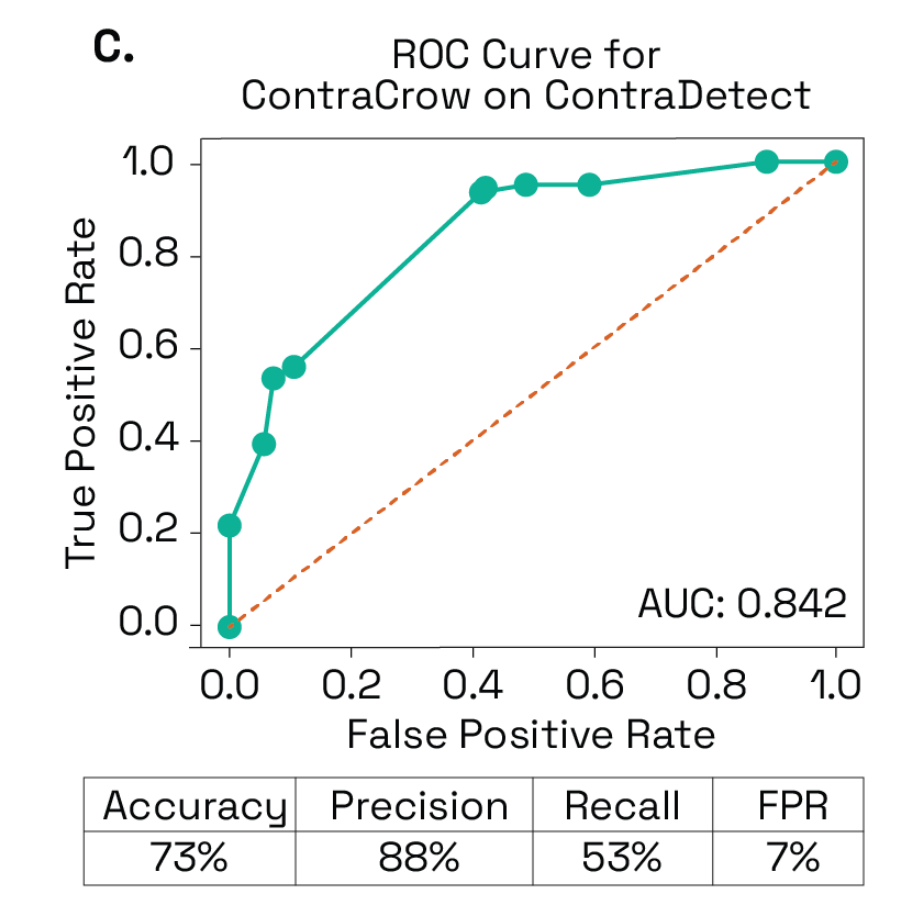

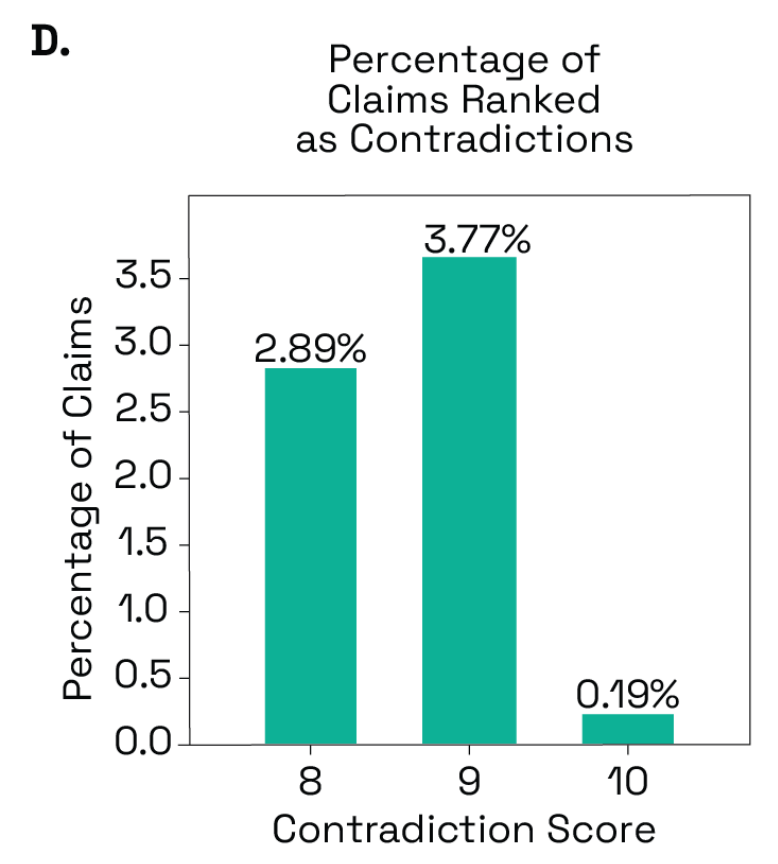

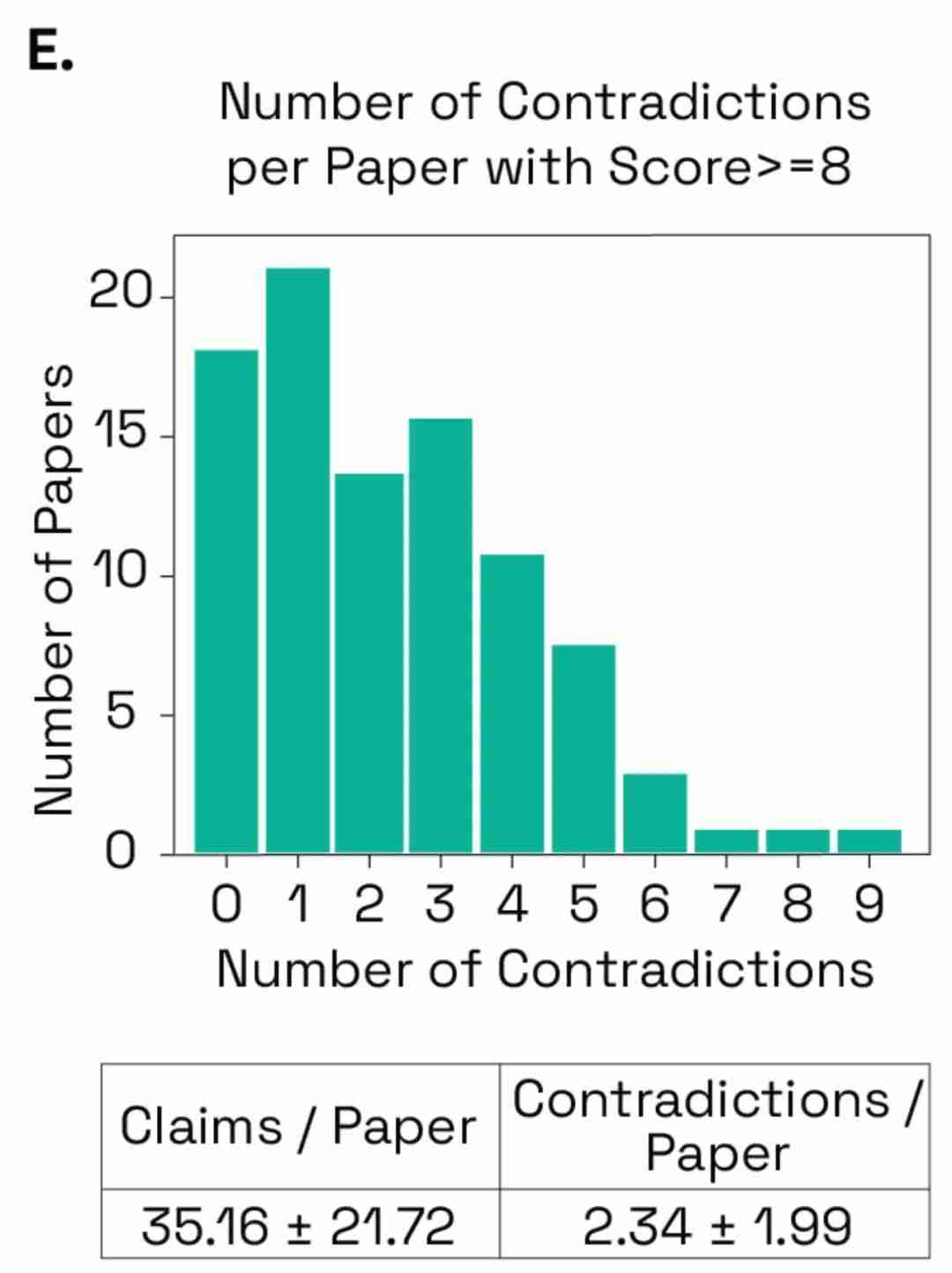

推理问题,即书面信息自相矛盾、过度推断或不受任何引用支持; -

归因问题,即信息可能得到另一个包{ ] | O + j V含的来源支持,但该声明在% 9 ~ ) & B ) 4本地没有包含正确的引用或来源太宽泛(例如数据库门户链接F | o ) ~); -

琐碎的声明,这些声明虽是真实的段落,o ~ x 1但过于迂腐或没有必要。

以上就是检索总结能力超博士后,首个大模型科研智能体PaperQA2开源了的详细内容!

微信扫一扫

微信扫一扫