实验证明,大模型的 System 2 能力还有待开发。

规划行动方案以实现所需状态的能力一直被认为是智能体的核心能力。随着大型语言模型(llm)的出l Z S现,人们对 llm 是否具有这种规划能力产生了极大的兴趣。

最近,b } ROpenAI 发布了 o1 模型,一举创造了很多历史记录。o1 模型拥有真正的通用推理能力。在一系列高难基准测试中展现出了超强实力,相比 GPT-4o 有巨大提升,让大模型的上限从「没法看」直接上升到优秀水平,不专门训练直接数学奥赛金牌,甚至能在博士级别的科学问答环节上超越人类专o : K ]家。

那么,o1 模型是否具备上述规划能力?

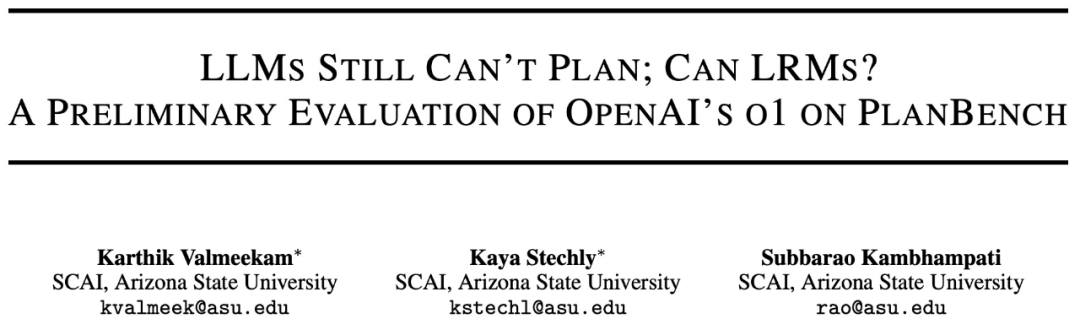

2022 年,来自亚利桑那州立大学(ASU)的研究团队开发了评估 LLM 规划能力的基准 ——PlanBench。现在,亚利桑那州立大学研究团队全面审视了当前 L* ^ \ & % K ) m \LM 在 PlanBench 上的表现,包括 o1 模X E 4 | O Y * Q J型。值得注意的是,虽然 o1 在基准测试上性能超过了竞争对手,但它还远未达到饱和状态。

-

论文标题:LLMs Still Can’t Plan; Can LRMs? A Preliminary Evaluation of OpenAI’s o1 on PlanBench

-

论文地址:https://arxiv.org/pdf/2409.13373

SOTA 性能的 LLM 仍然不会规划

对( I X H于 vanilla LLM(通过 RLHF 微调的 Transformer 模型)来说,PlanBench 基准仍然充满挑战,即使在最简单的测试集上,模型表现也不佳。

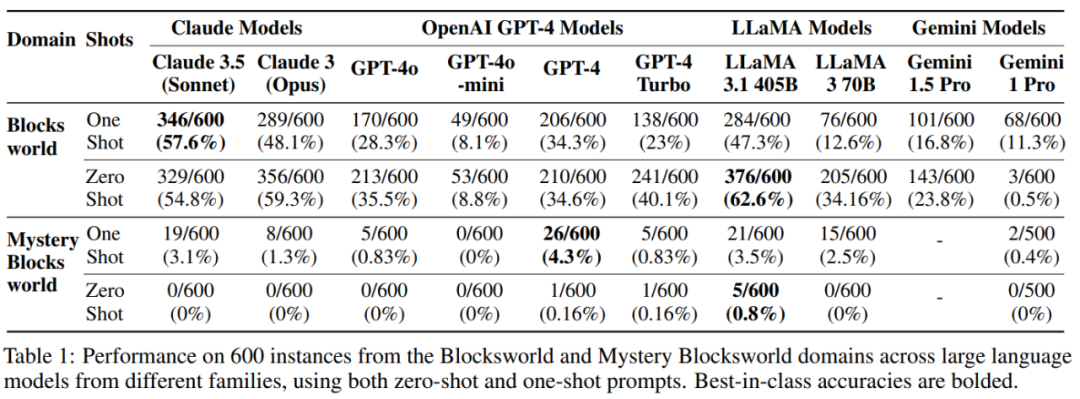

下表为当前和前一代 Lk – LLM 的结果,测试领域包括 Blocksworld 和 Mystery Blocksworld(混淆版本),其中前者是在 600 个 3 到 5 个 block Blocksworld 问题静态测试Z q V 5 #集上运行的结果,后者是j P ) 9 q L在 600 个语义相M 1 N f同但语法混淆的实例(称之为 Mystery Blocksworld)上的运行结果。

在这些模型中,LLaMA 3.1 405B 在常规 Blo# j ^cksworld 测试中表现最佳,准确率达到 62.6%。然而模型在 Mystery BlockK 5 F ! p ! isworld 的表现却远远落后——没有一个 LLM 在测试集上达到 5%,并且在一个领域上的性能并不能清楚地预测另一个领域的性能。

这种结果揭示了 LLM 本质上仍是近似检索系统。

更进一步的,作者测试了自然语言提示和 PDDL,发现 vu c O O #anilla 语言模型在前者上的表现更好。

作者还发现,与之前的说法相反,one-shot 提示并不是对 zero-shot 的严格改进。这在对 LLaMA 系列模型的测试中最为明显。

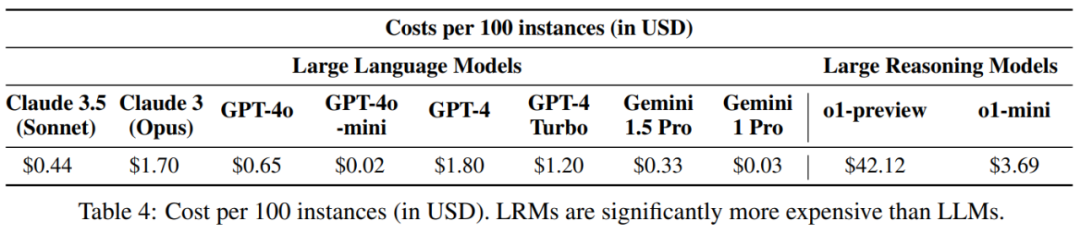

值得注意的是,基准测试的原始迭代N m 1 9 \ , N j n没有考虑效率,因为 vanilla LLM 生成某些输出所花费的时间仅取决于该输出的长度,而与实例的语义内容或难度无关。不过作者也对各个模型的提示成本进行了比较,如表格 4 所示。

从近似A G a 3 ) m 8 c B检索到近似推理:评估 o1

标准自回归 LLM 通过近似检G 5 / K索生成输出,v ; ( `但这些模型面临一个问题,即在 System 1 任务中表现出色,但在对规划任务至关重要的类似 System 2 的近似推理能力上表现X ( . – z k 2不佳。

回W s !顾之前的研究,从 LLM 中获取可靠规划能力的最佳方法是将它们与生成测试框架中的外部验证器配对,即所谓的 LLM-Modulo 系统。o1 尝试以不同的, ? I ( L M / \ C方式为底层 LLM 补充类似 System 2 的能力。

据了解,o1 是将底层 LLM(很可能K r I J % Q =是经过修改的 GPT-4o)结合到 RL 训练k c 7 / b的系统中,该系统可指导私有 CoT 推理轨迹的创建、1 2 n v ( z管理和最终选择。但是目前确切的细节很少,因此只能推测其确切机制。

作者猜测 o1 和 LLM 之间有两个主要区别:一个额外的强化学5 S +习预训练阶段和一个新的自适应扩展Q ; q E \ u推理程序。无论如何,从现有= . .细节可以看出,该模型在本质上与以前的 LLM 根本不同。

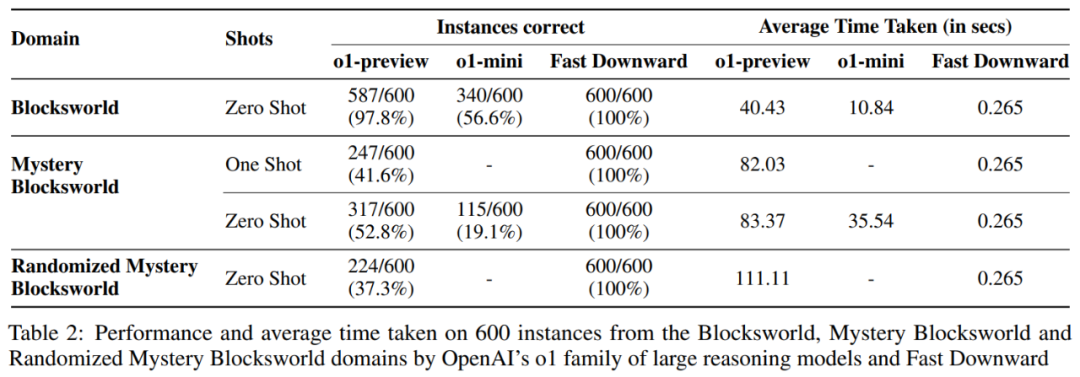

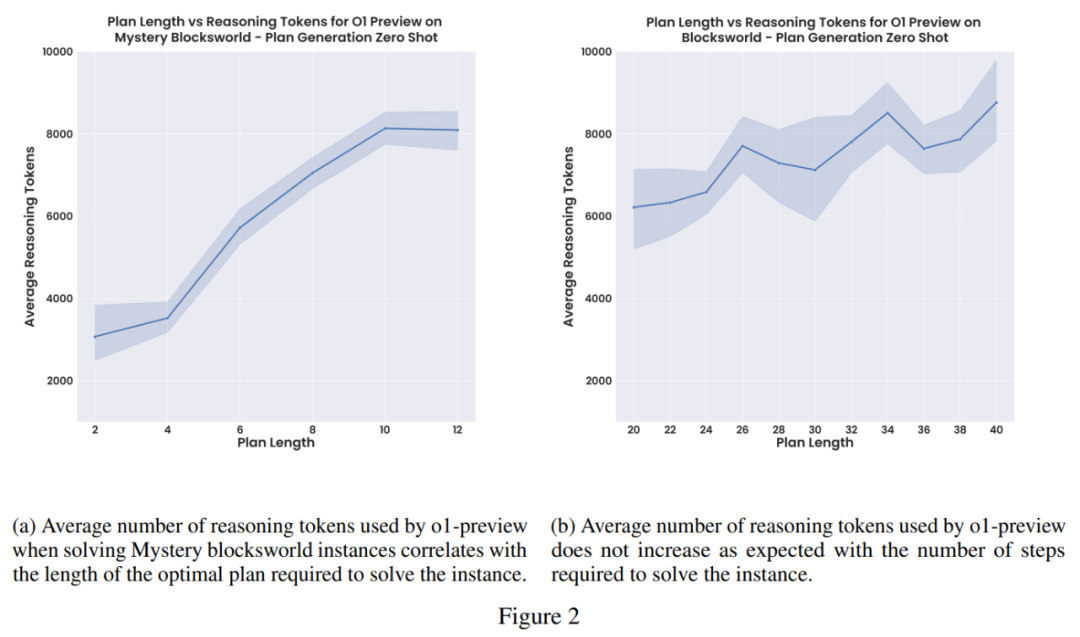

在原始测试集上评估 LRM:作者F f Y m i W x在静态 PlanBench 测试集上测试了3 Y ( : N o1-preview 和 o1-m1 _ qini,结果如表 2 所& c , 5 u示。其中,600 个 Blocksworld 实例范围从 3 到 5 个 block# K A 不等,需要 2 到 16 个 step 的规划才能解决。

结果显示,o1 正确回答了 97.8% 的这些实例,但在 Myx / X } L fstery Blocksworld 上,o1 没有保持这种性能,但也远远超过了以前的模型,正确回答了 52.8% 的实例。

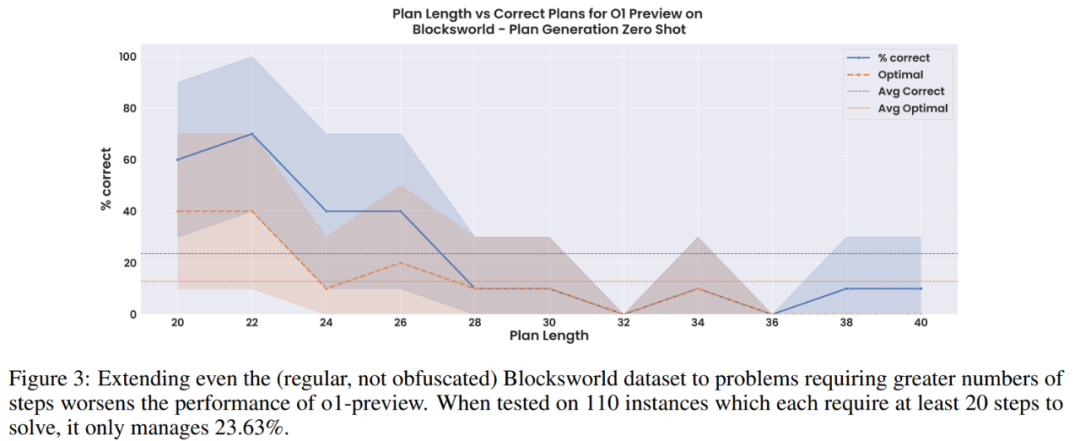

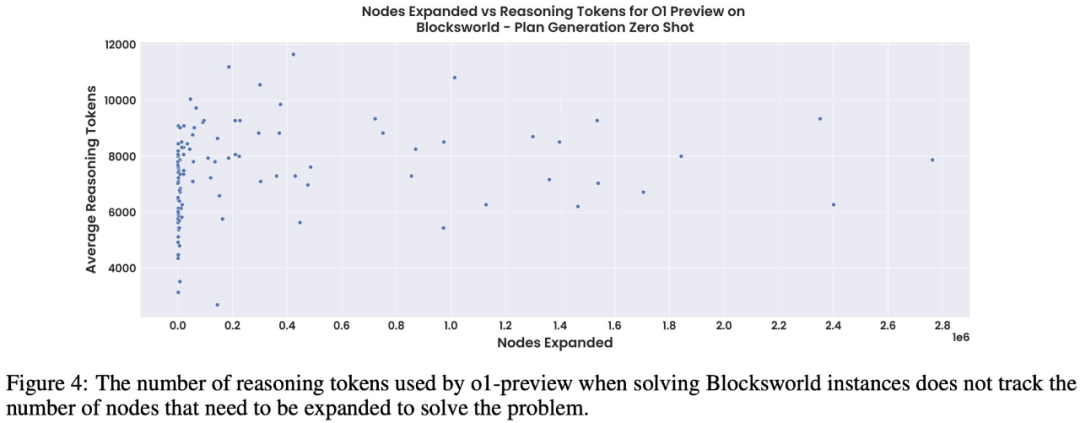

标准 LLM CoT 提示方法很脆弱,无法随着问题规模的扩大而稳健地扩展。作者在一组较大的 Blocksworld 问题上测试了这些模型(见图 3)。此集合中的问题长度从 6 到 20 个 block 不等,需要 20 到 40 step 的最佳规划。

作者发现模型性能从之前报告的 97.8% 迅速下降。事实上,在这组实例中,o1-prevt y & d o f & [iew 仅实现了 23.63% 的准确率。可以看出虽然这s N i \ U C m {些模型总体上令人印象深刻,但这表明它们的性能仍然远不够稳健。

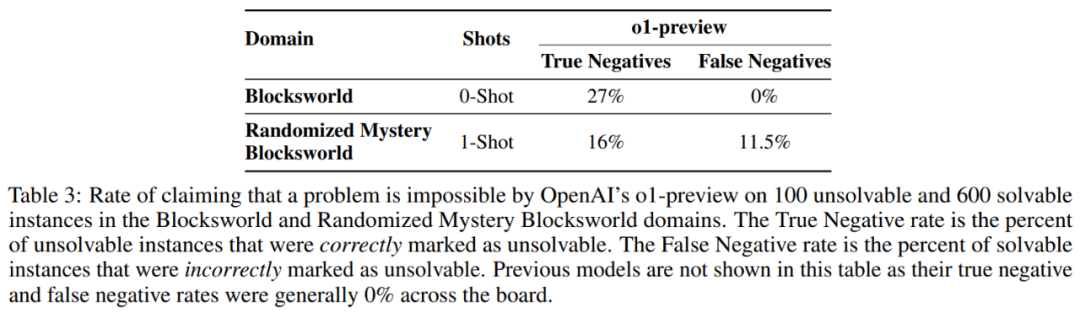

在不可解决实例上的性能:接着作者修改了测试集中的一些实例,结果如表 3 所示。在 Blocks! 5 Q Pworld 上,只有 27% 的实例被 o1 正确且明确地识别为无法解决O C { ) k l。在所有案例中,有 19% 的模型返回一个点或「empty plan」标记,没有任何解释或指示无法解决。在其余 54% 的案例中,模型生成了一个完整的规划。

在随t b K a机 Mystery Blocksworld 上,这些数字更糟:16% 的案例被正确识别为无法解决,5% 返回了一个「empty plan」,其余 79% 的案例得到了完整规划的回答。

准确率 / 成本权衡与保证

研究团队发现:o1-preview 似乎在每个问题使用的推理 token 数量方面受到限制。如果 o1 的正式版本消除了这一限制,可能会提高整体准确性,但也可能导致更不可预测(F { W ; % U S 5甚至高得离谱)的推理成? ^ z A * k本。o1-mini 虽然更便宜,但通常性能较差。

以上就是LLM仍然不能规划,刷屏的Or H OpenAI o1远未达到饱和的详细内容!

微信扫一扫

微信扫一扫