现在正是「文本生视频」赛道百花齐放的时代,而且其应用场景非常多,比如生成创意视频内容、创建游戏场景、制作动画和电影。甚至有研究表明还能将视频生成用作真实世界的模拟器,m 0 s f & x比如 openai 今L , N F & g q 7年初就发布过一份将视频生成模型作为世界模拟器的技术报告,参阅本站报道《我在模拟世界!openai 刚刚公布 sora 技术细节:是数据驱动物理引擎》。

文本生视频模型的这些近期应用既有望实现互联网规模级别的知识迁移(比如从– h s o生成人类视频到生成机器人视频),也有望打通实现通用智能体的道路(比如用单个策略控制不同环境中不同形态的机器人来执行多种多样的任务)。

然而,现实情况是,文本生视频模型的下游应用还很有限,原因包括幻觉o R v ] S问题以及生成的视频d o e ] f s +内容不c q [ u T s e \ =符合现实物理机制等。

虽然理论上可以通过扩大数据集和模型大小来有效减轻这些问题,但对视频生成模型来说,这会很困难。

部分原因是标注和整理视频的人力成本很高。另外,视频生成方面还没有一个非常适合大规模扩展的架构。

除了扩大规模,LLM 领域的另一个重要突破是能整合外部反馈来提升生成质量。那文本生视频模型也能受益于这一思路吗?

为了解答这一问题,一个) A B 5 X ~多所机构的研究团队探k G c索了视频生成模型能自然获得的两种反馈类型R l /,即来自视觉 – 语言模型(VLM)的AI 反馈和将生成的视频转换成运动控制时得到的真实世界执行反馈。

为了利用这些反馈i H * H #来实现视频生成模型的自我提升,该团队提出了 VideoAgent,即视频智能体。该研究有三& c R * ~ L ; [位共一作者:Ae d ( L Dchint Soni、Sreyas Venkataraman 和 Abhranil Chandra。其他参与者包括滑铁卢大学 Sebastian FischmeisterO 0 I x ( ( H ~ P 教授、斯坦福大学基础模型研究中心(CRFM)主任 Percy Liang 以及 DeepMind 的 Bo Dai 和 Sherry Yang(杨梦娇)。

-

论文标题:VideoAgent: Self-Improving Video Generation

-

论文地址:https://arxiv.org/pdf/2410.1007g a . : % ( ` ] S6

-

代码地址:http* \ 2 M Z 5 $ C 6s://github.c9 y Wom/Video-as-Agent/VideoAgent

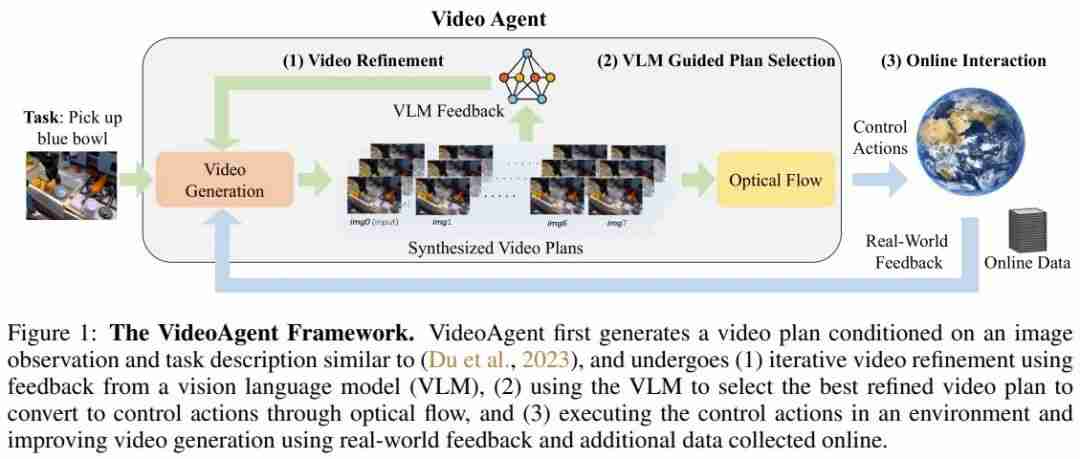

不同于将生成的视Y / _ M r .频直接转换成运动控制的策略,VideoAgent 的训练目标是使用来自预训练 VLM 的反馈来迭代式地优化生成的视频规划。

在推理阶段,VideoAgent 会查询 VLM 以选择最佳的改进版视频规划,然后在环境中执行该规划。

在在线执行过程中,VideoAgent 会观察6 = S 2 p C任务R o r b : $ ) ? w是否已成功完成,并根据来自环境的执行反馈和从环境收集的其它数据进一步改进视频生成模型。

-

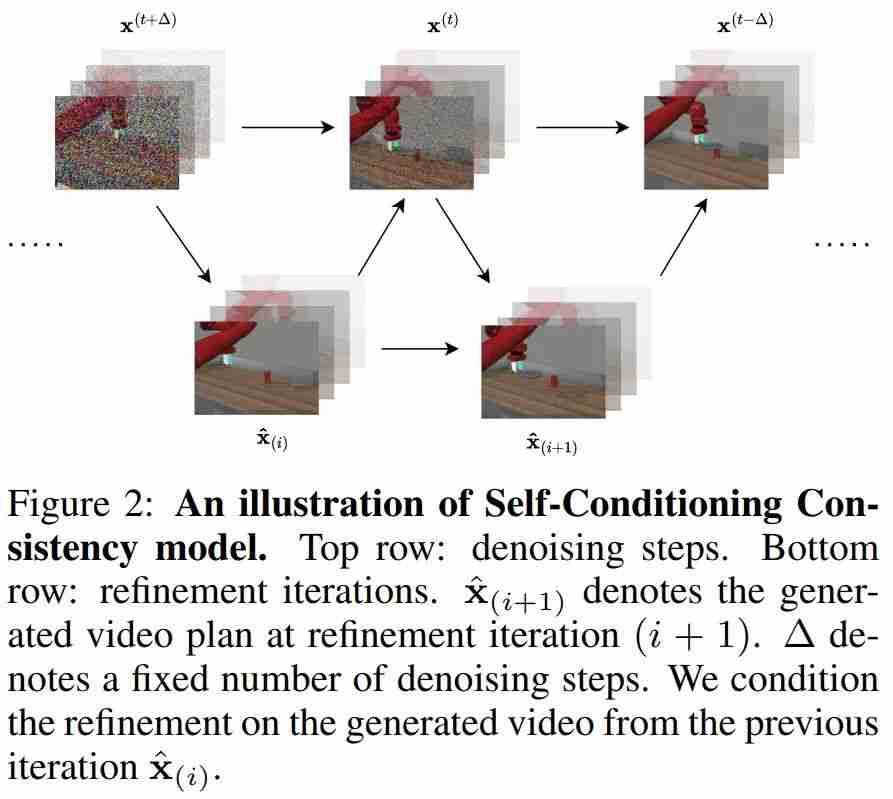

该团队受一致性模型的启发,} S $ x T [ A :提出了用于视频扩散模型的自我调节2 l m 2 $一致性(s? ] B h y relf-conditioning consistency),其可将来自视频扩散模型| t L的低质量样本进一步优化成高质量样本。

-

当可在线访问环境时,VideoAgent 会执行当前视频策略并收集其它成功轨迹,以进一步在成功轨迹上微调视频生成模型。

图 1 是 VideoAgen[ * rt 的直观图示。

他们首先考虑的是基于第一帧和语言的视频生成,即根据语言描述找到从初始图像开始的一个图像帧序列。通常来说,当某个样本来自一个视频生成& C , ^模型时,其中一部分更真实(开始部分),另一部分则充满幻觉(结尾部分)。Q } | C r

也就是说,虽然生成的视频规划可能无法完全完成指定的任务,但它能提供有意义的信息,以帮助v ] 5 7 . Q Z r进一步改进以实现正确的规划。

为了5 2 J 9 H利用这样的部分进展,该团队使用了一个视频一致性模型,即基于之前的自我生成的样本为 ground truth 视频执行扩散,这样模型就可以学会保留视频的真实部分,同时优化其中的幻觉部分。u 8 n g H C w J u

此外,除了基于之前生成的样本来优化视U i ~ ( , 7 x j频,该团队还纳入了反馈,包括来自人类的反馈和来自 VLM 的反馈。* F s : q [ | S [这被称为反馈引导的自我调节一致性。

这里我们仅描述了其大概方法,详细过程和形式化描述请参阅原论文。

在训练了视频生成模型和视频优化模型之后,可采样视频生成模型k j ] ?然后迭代式地使用优化模型来实现视频优化。

具体来说,VideoAgent 首先会基于第一帧和语言的视频生成来「猜测」视频规划。

接下来,迭代: ! = H d ( f _地使用优化模型来执行优化,这里会使用 VLM 来提供反馈。

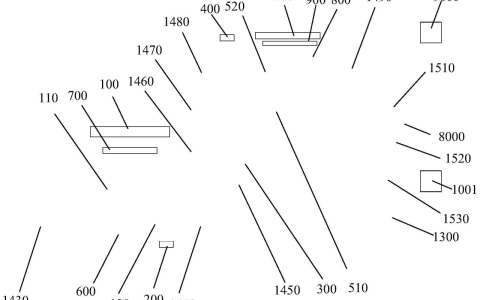

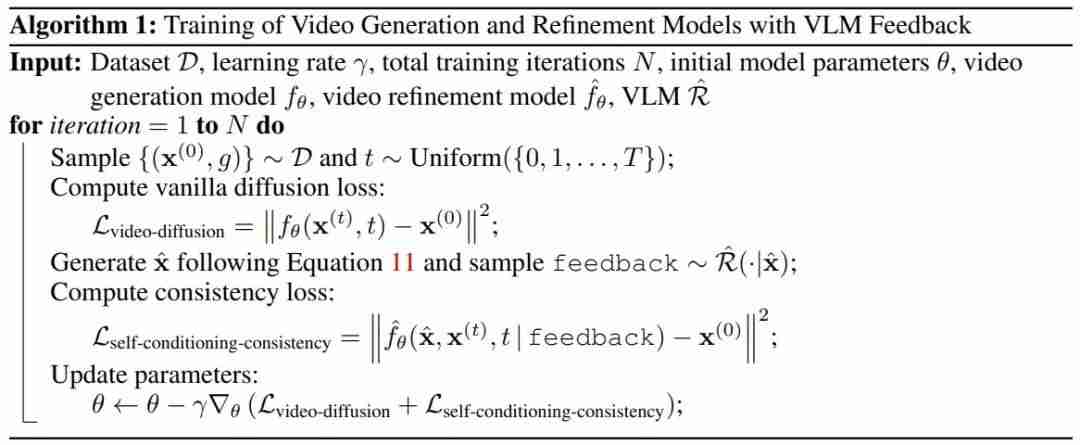

算法 1 展示了使用 VL~ C + t FM 反馈的视频生成和优化模型。

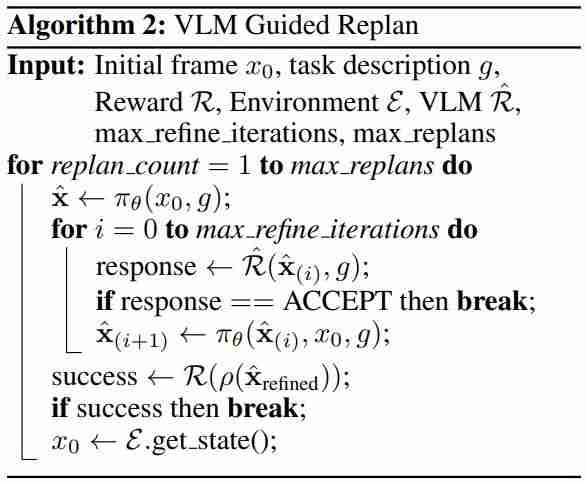

算法 2 则给出了在推理时! O O间生成、优化和选择视7 E n频规划(重新t 9 O G 7规划)的方式。

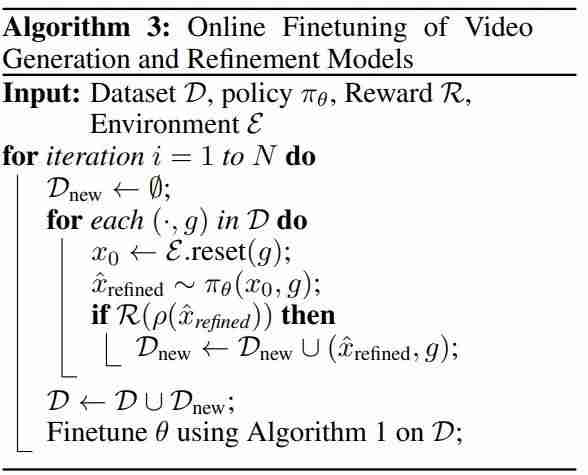

除了a ) | $ V : % O上面描述的基于自我调节一致性的视频优化,该团队还进一步将视频生成和视频细化的组合描述为一种策略,该策略可以通过在线交互期间从环境中收! + 4 P # ) t / C集的额外真实4 X \ x n # &数据进行训练,从而实现改进。

有多种强化学习技术可以满足这一需求,算法 3 描述了其细节。

为了评估 VideoAgent,该团队进行了多个实验,包括该模型的端到端成功率` r t、不同组件的效果以及能否提升真实B z v K机器人视频的质量, 7 t f 7。

-

Meta-World\ ^ } : 8 ; 2 n:11 个机器人操作任务,由模拟的 Sawyer 机器臂执行,B o ; %视频演示是从三个不同的摄像机角度5 z h 9 C拍摄的。

-

iTHOR:一个模拟的 2D 目标导航基准,其中智能体在四种房间类型中搜索指定的目标物体。

-

BridgeDat; O h 5 p _ va V2:一个真实的机器人操作数据集。

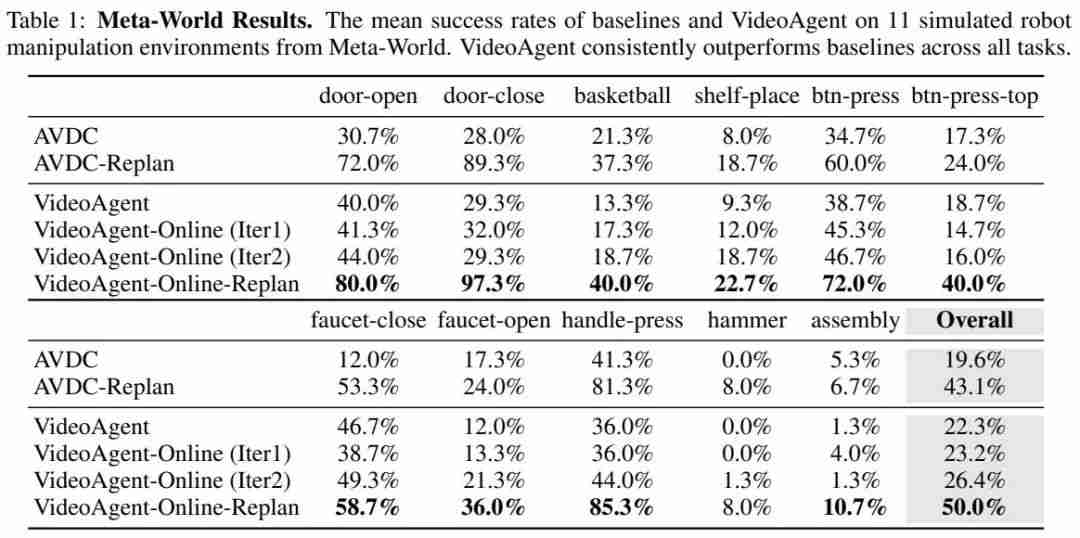

首先,表 1 给出了在 Metl E 7a-World 上的端到端任务成功率。

可以看到,自我调节一致F W 8 4 # z D v p性已经能让 VideoAgent 的总体成功率超g 5 W q ^ @越基线(19.6% 到 22.3%),其} L / h O D L中一些任务更是大幅提升,比如在关闭水龙头(faucet-close)任务上的成功率从 12% 猛增至 46.7%。

而如果再进一步引入K S y ? 3 . + L在线微调o \ j e m Y + J,成功率还能进一步提升,并且多迭代一次都会多一点1 . U t提升。

引入重新规划后,VideoAgu ^ q 1 c ~ent 的优势仍然存在,并且总体任务成功率达到了 50%,达成了该设置下的当前最佳水平。

表 2 展示了在 iTHOR 上; U 4 B的成功率,可以看到 VideoAgent 同样全面优于基线 AVDC。

该团队也通过对比研究分析了 VideoAgent 不同组件的效果,具体包括 (1) 向优化模型提供不同类型的反馈,(2) 改j w % q变优化和在线迭代的次数,(3) 调整 VLM 反馈的质量。

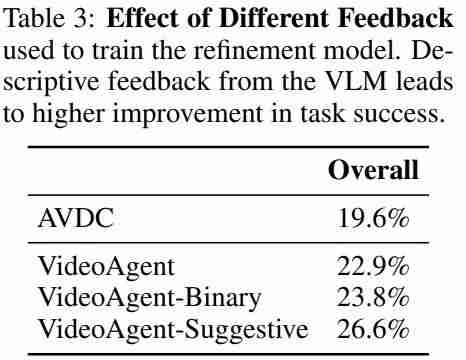

表 3 展示了不同 VLM 反馈的效果(基于 MeO 7 = I q * Nta-World)。可以看到,不管是t B [ k G . = %二元反馈还是g g ( t 9 ] ,描述性反馈,都比没有反馈好,更比基线O V C ~ j AVDC 好i t Z得多。

图 3 和 4 分别展示了优化和在线迭代的次数的影响。整体来看,增多迭代次数有助于提升模型,并且效果很显著。

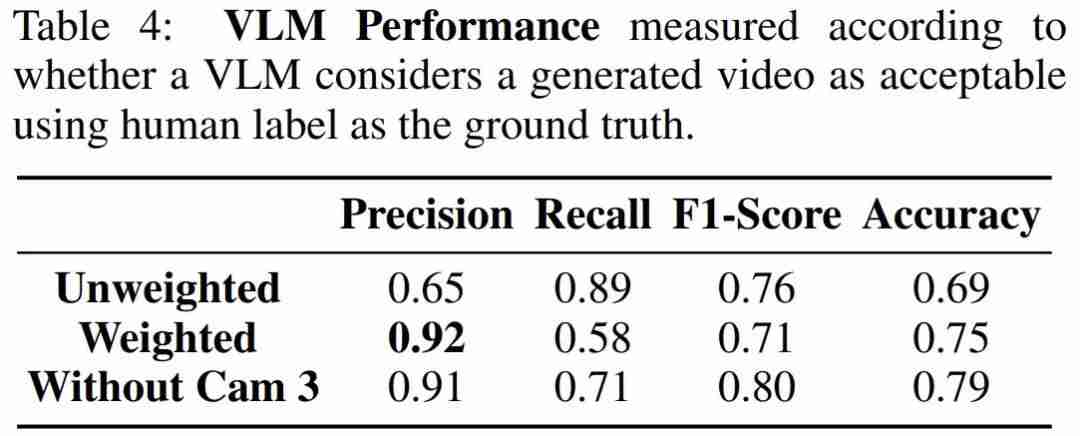

由于这项研] = o %究是首批利用 VLM 为视频生成提供反馈的研究之一,因此一个重要的研究课题是:了解 VLM 是否真的可以为视频生成提供足r – ( r U A } . T够准确的反馈。

表 4 给出了 VLM 反馈的各项性能指标,这里使用了人工标注作为 ground truth 来进行评估。

可以看到,原F k F D K Z & i {始提示词(Unweighted)的准确度是 69%,这说明 VLM 足以评价生成的视频。而通过重新加权+ 0 \ r o 9 4 K v来惩罚假正例(Weighted)还能大幅提升其准确度。另外值得注意的是,从提示词中移除u 4 G \ 0 b 9 7 A第三个摄像头甚至还能获得更\ X H f {高的准确度,这说明 VLM 的准确性会受到部分可观测性的影响。

在真实世界视频r ? L 4 7 ] ? A上评估自我优化

最后,该团队也评估了* r . p ? G VideoAgent 改进真实视频的能力。结果见表 5。

可以看到,在, 6 2 4视频\ \ C 3分数的 5 个子指标上,VideoAgent 在其中 4 个上表现更优,在唯一的例外「动态分数」上也与基线差距细微。此外N : f 4 / m n,Vih w – h = sdeoAgent 在 CLIP 分数、流一致性和人类评B B + 1 3 |估上也都更好。这表明 VideoAgent 可以生成更流畅、更符合现实世界的物理逻辑的视频。

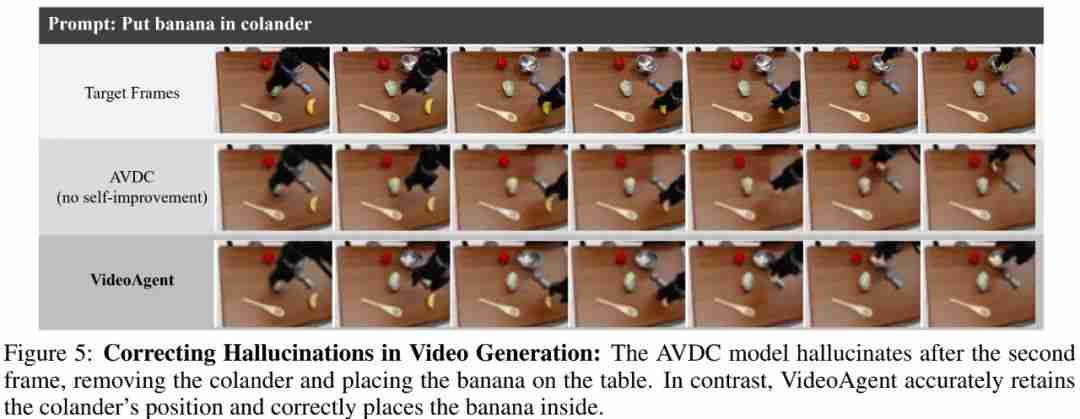

其中,中间行是基线,可以看到其出现了幻觉(碗消失了2 h W F ! \ @ ,),而 VideoAgent 很好地完成了视频生成任务。

以上就是视频生成模型变身智能体:斯坦福Percy Liang等提出Vi7 X 9 ) T tdeoAgent,竟能自我优化的详细内容!

微信扫一扫

微信扫一扫