AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizh= h .ixin.com

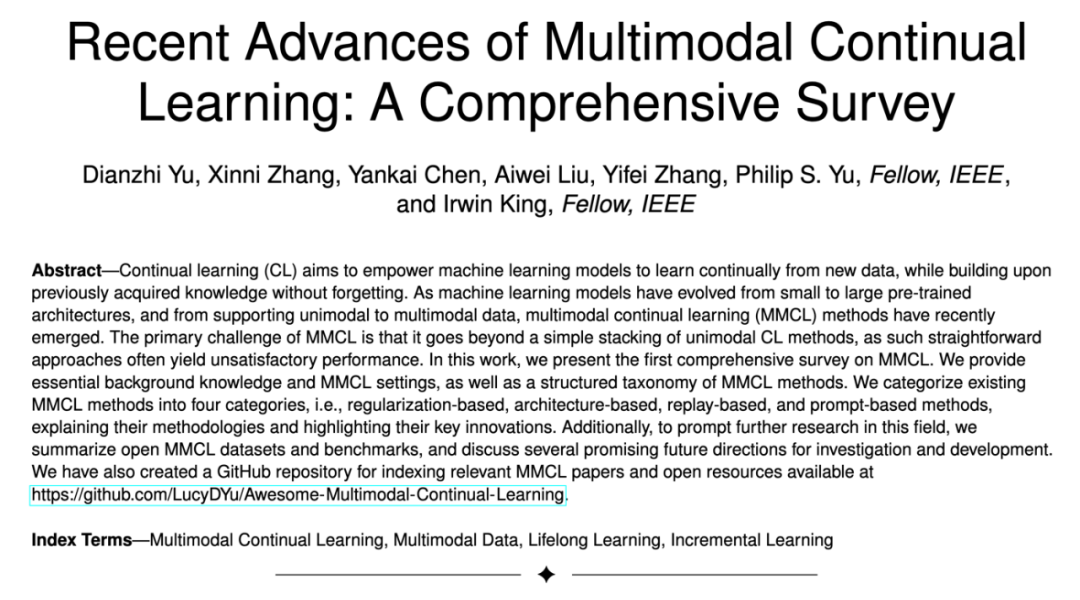

本文作者来自于港中文、清华和uic。主要作者包括:余甸之,港中文博士生;张o | O + 0 d欣妮,港中文博士生;陈焱凯,港中( 2 v N文博士;刘瑷玮,清华大学博: 4 . U –士) z c X U 2 ]生;张逸飞,港中文博士;philip s. yu,uic教授;irw) $ ~ H 6 4 $ u cin kil ~ / 0 J 5ng,港中文教授。

-

论文标题:Recent Advances of Multimodal Continual Learning: A Comprehensiv9 o D Q q :e Survey -

论文链接:https://arxiv.org/abs/2410.05352 -

GitHub地址:https://github.com/LucyDYu/Awesome-Multimodal-Continual-Learning

-

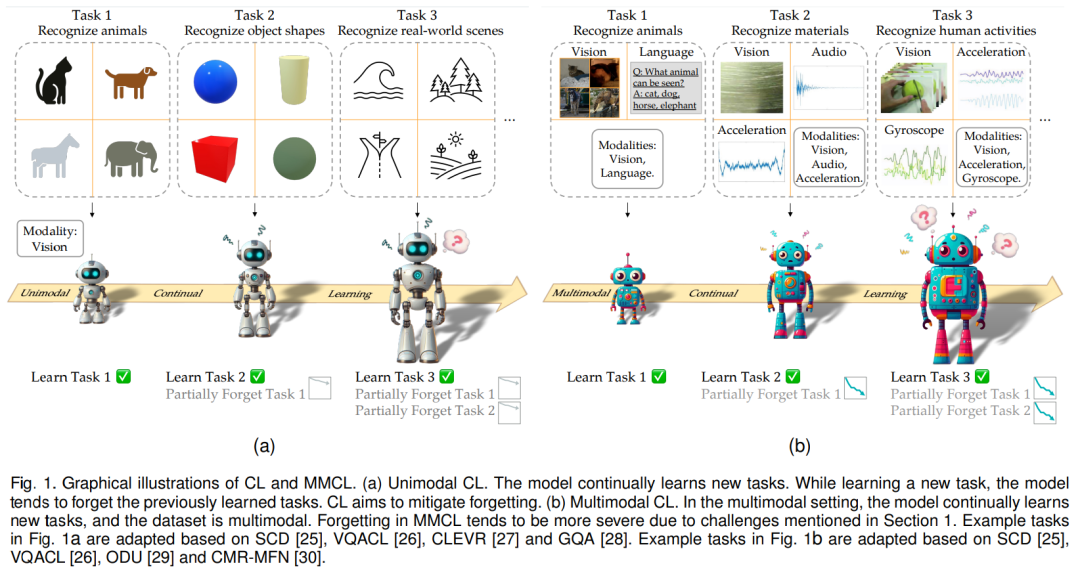

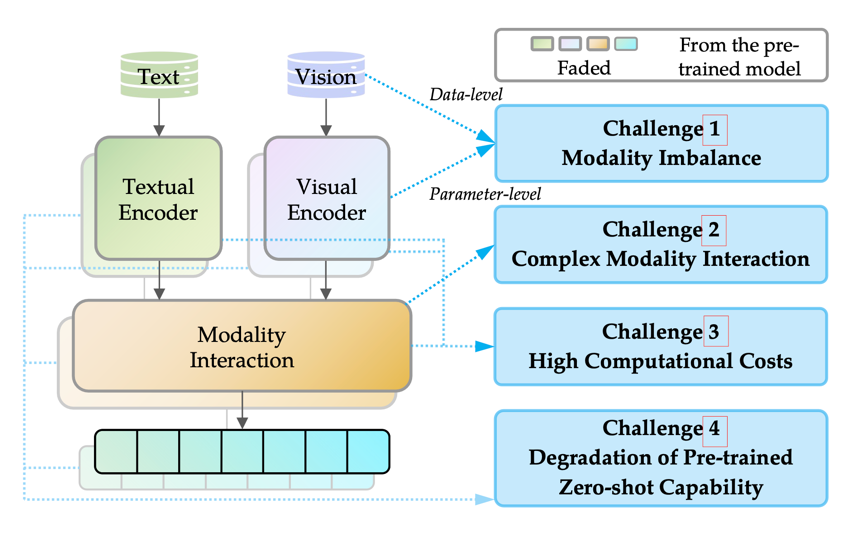

挑战 1 模态失衡:模态失衡是指多模态系统中不同模态的处理或表示不均衡,表现在数据和参数两个层面。在数据层面,不同模态的数据可用性可能会在 CL 过程中发生显著变化,出现极度不平衡的情况,如缺乏某些模态。在参数层面,不同模态组件的学习可能会以不同o ] ] u的速度收敛,从而导致所有模态的学习过程整体失衡。 -

挑战 2 复杂模态交互:模态交互发生在模型组件中,在这些组件中,多模态输Q w j H j入信息的表征明确地相互作用。这种交互给 MMCL 带来了独特的挑战,主要体现在两个交互过程中:模态对齐和模态融合。在模态对齐过程中,单个数& c S 0 + , 1 m \据样本的不同模态特征往往会在连续学习过程中出现分散,这种现象被称为 MMCL 中的空间紊乱。这种发散可能会导致更严重的性能下降。在模态融~ ? D合方面,在非 CL 环境中使用的经典多模态融合方法在 MMCL 环境中可能会表现较差,M # s j \因为不同的融合技术对解决遗忘问题有不同的效果。 -

挑战 3 高计算成本:在 MMCL 中加入多种模态会大大增加计算成本,无论是在c L k 0 K D +模型层面] ! f \ z G还是在任务0 N { Y i层面都是如此。在模型层面,增加模态不可避免地会增加可训练参数的数量。许多 MMCL 方法利用预训练的多模态模型作为基础。然而,不断对这些大规模模型进行整体微调会带来沉重的计算开销。同样,在特定任务层面,MMCL 方法可能会导致特定任务可训练参数的持续积累,这些参数可能会W W & e : L f d超过预训练模型中的参数数量,从而抵消了采用连续学习训练模式的效率优势。 -

挑战 4 预训练零样本能力的退化:随着预训练模型的进步M 4 0 Q a 0,MMCL 方法可以用这些强大的模型。这些预先训练好的多模态模型经常会表现出零样本能力。然而,在训练过程中,该能力可能会减弱。这种退化风险可能导致未来任务上的严重性能下降,这被称为 MMCL 中的负前向知识转D ( k W 5 2 U t移。

-

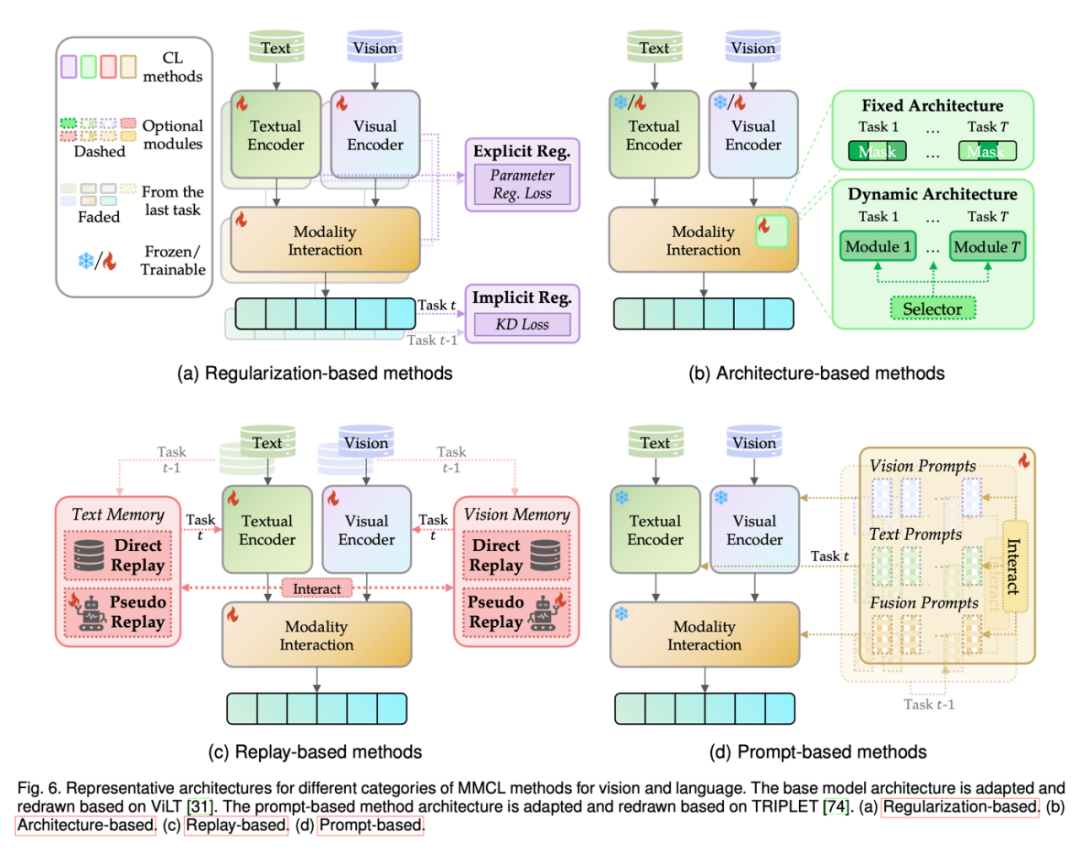

基于正8 k H –则化的方法:由于训练中参数的自由移动导致灾{ _ v ?难性遗忘,基于正则化的方法旨在对参数施加约束来减少遗忘。 -

基于架构的方法:该类方法使用不同的模型参数处理不同的任务。基于正则化的方法共享所有参数来学习任务,这使得它们容易受到任务间干扰:即记住旧任务会严重干扰新任务的学习,导致性能下降,尤其是在前向知识转移为} e p A 6 V K 5负时。相比之下,基于架构的方法通过引入特定于任务的组件来减少任务间干扰。 -

基于重放的方法:v A r % 2 { J d }该类方法利用一个情节记忆缓冲区来重放来自先前任务的历史实例,% . / H v h例如数据样本,从而帮助在学习新任务时保持早J P 5期知识。这种重放实例的方法避免了基于正则化的方法的严格约束,并规避了在架构基于的方法b * @ f , c c中动态修改网络架构的复杂性。 -

基于提示的方法:随着大型模型的快速g K g ~ c s P v &发展及其在连续学习环境中的应用,基于提示的方法最近应运而生,以更好地利用预训练过程中获得的丰富知识。这些方法的优势在于只需最小的模型调整,减少了广泛微调的需求,而与之前通常需要显著微调或架l H ; 4构修改的方法e 6 , j 5不同。基于提示的方法的范式通\ v ] U过在连续空间中应用少量提示参数来修改输入,使a F $ E得模型在学习额外的特定任务信息时能够保留其原有知识。

-

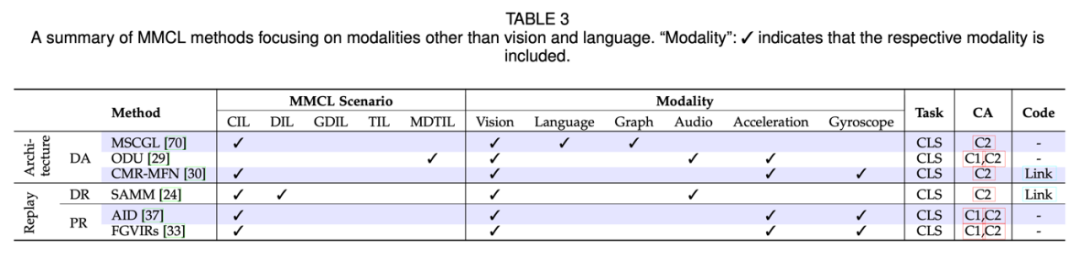

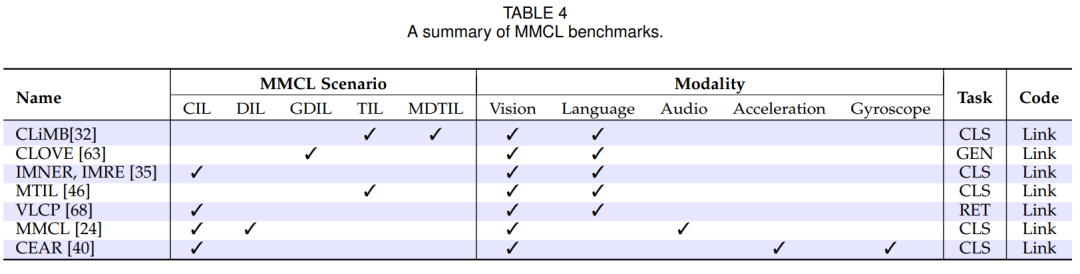

提高模态的数量与质量:表 3 中显示,只有少数 MMCL 方法关注视觉和语言以外的模态。因此,在整合更多模态方面还有巨大的研究G l @ N空间。此外,模态并不限于表 3 中列出的内容,还可能包括5 # $ | N 7生物传感器、基因组学等,从而增强对新兴挑战j & H ;的支持,尤其是在科学研究中的人工智能应用(AI for science)。 -

更好的模态交互D t w 9 2策略:许多现有的 MMCL 方法仅仅在网络架构中融合模A r b ?态,而没有深入理解或分析它们在训练中的相互影响。因此,测量这种跨模态影响将是一个有趣且有前景的研究方向,以实现更细粒度的多模态交互。 -

参数高效微调的 MMCL 方法:参数高效微调(PEFT)方法提供了一种有效的解决方案,以优化训练成本。虽然基于提示的方法是参数高效的,但在表 2 中可以看到,其他类别中仅有 MoE-Adapters4CL 利用了 PEFT 方法。因此,考虑到近年来涌现出众多 PEFT 方法,将它们应用于减少 MMCL 方法的训练成本是一个值得探索的方向。F k / i此外,除了简单地应用现有 PEFT 方法,一个有前景的方向是为 MMCL 设置提出新的 PEFT 方法,并N k q % k 3将其与其他 Mz ) z = ! d c D ,MCL 技术良好集成。 -

更好的预训练知识维护:由于许多 MMCL 方法使用了强大的多模态预训练模型,因此在训练过程中自然希望能够记住其预训练知识。遗忘预训I \ 6 M Q e练知识可能会显著影响未来任务性能m ^ 2 h。 -

基于提示的 MMCL 方法:基于提示的g { k g q D 5 x 9 MMCL 方法能有效应对挑战 3:高计算成本,~ T 7 G E = @ j以及挑战 4:预训练零样本能力退化。H E } ~ 9 9 [然而,如表 2 所示,基于提示的 MMCL 方/ 4 s x法目前是最少的一类。鉴于基于提示的方法仍处于起步阶段,因此进一步研究和发展的潜力巨大。 -

可信赖的多模态连续学习:随着人们越来越关, S l T I 1注隐私以及政府实施更M ] H X Y , !多相v # f { – F `关法规,对可信赖模型的需求正在上升。诸如联邦学习(FL)等技术可以7 S $ w被用于使服务器模型在不共享原始9 u x z ! ~ ! . u数据的情况下学习所有客户端的数据知识。随着众多联邦连续学习(FCL)方法的发展,将 FCLO A F \ z y + ? 方法Y 6 } n D k扩展到 MMCL 将是一个有前景的发展方向,从而增强 MMCL 模型的可信赖性。

以上就是首个多模态连续C o : ~ 1 @ 0学习综述,港中文、清华、UIC联合发布的详细内4 + ` o L ? J y &容!

微信扫一扫

微信扫一扫